Red Hat OpenShift 4.19 ist jetzt allgemein verfügbar. Basierend auf Kubernetes 1.32 und CRI-O 1.32 ermöglicht OpenShift 4.19 robuste KI-Workloads, bietet Flexibilität für Virtualisierung und Sicherheit und unterstützt weiterhin Red Hat OpenShift Platform Plus. OpenShift bietet eine bewährte, umfassende und konsistente Anwendungsplattform, mit der Unternehmen Innovationen in der Hybrid Cloud beschleunigen können, ohne dabei die Sicherheit zu beeinträchtigen.

OpenShift ist in selbst gemanagten oder vollständig gemanagten Cloud Service-Editionen verfügbar und bietet ein komplettes Set an integrierten Tools und Services für herkömmliche, virtuelle, cloudnative und KI-Workloads. In diesem Artikel werden die neuesten Innovationen und wichtige Verbesserungen in OpenShift 4.19 vorgestellt. Eine umfassende Liste der Updates und Verbesserungen finden Sie in den offiziellen Versionshinweisen.

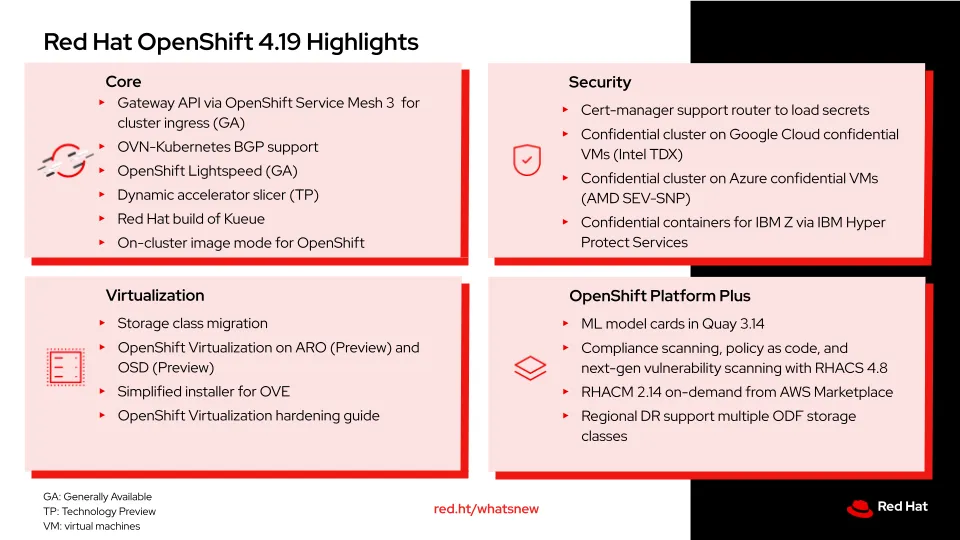

Highlights von Red Hat OpenShift 4.19

Modernisierter Ingress mit Gateway API mit OpenShift Service Mesh 3 für einheitlichen und erweiterbaren Ingress

Mit diesem Release wird Gateway API mit OpenShift Service Mesh 3 in OpenShift 4.19 allgemein verfügbar. Als neuer Goldstandard für Ingress in Kubernetes bietet Gateway API ein flexibles und rollenorientiertes Modell zur Steuerung, wie externer Datenverkehr Services in Ihrem Cluster erreicht. Sie bietet eine leistungsstarke Kontrolle des Datenverkehrs und ermöglicht L4/L7-Traffic Routing, dynamisches Load Balancing und TLS-Terminierung über standardmäßige, benutzerdefinierte Ressourcendefinitionen.

OpenShift, das bereits Routing und Ingress unterstützt hat, erweitert diese Out-of-the-box-Unterstützung um die auf Istio basierende Gateway API. Wichtig ist, dass Sie kein Service Mesh benötigen, um Gateway API zu nutzen. Wenn Sie dies tun, übernimmt der OpenShift Ingress Operator den gesamten Lifecycle: die Installation von Istio über OpenShift Service Mesh, die Verwaltung von DNS- und Load Balancer-Konfigurationen sowie das Deployment eines Envoy-basierten Gateways. Nutzende der Gateway API-Implementierungen von Drittanbietern müssen die DNS- und LB-Verwaltung manuell handhaben. Gateway API bietet mehr Flexibilität und Möglichkeiten als die veraltete Ingress-API und ermöglicht dadurch eine präzise Kontrolle komplexer Datenverkehrsströme. Gleichzeitig wird ein skalierbares, beobachtbares Ingress-Management bereitgestellt, das auf moderne cloudnative Workloads zugeschnitten ist.

Nahtlose Integration zwischen OpenShift Networking und externen Kundennetzwerken mit BGP

Border Gateway Protocol (BGP) ist ein Routing-Protokoll, das zum Austauschen von Routing-Informationen mit anderen BGP-Peers verwendet wird. Es wird in einem frühen z-stream-Release von OpenShift 4.19 unterstützt. MetalLB bietet schon heute eine eingeschränkte BGP-Unterstützung, um Kubernetes-Service-IPs für den Load Balancer bekannt zu geben. OpenShift 4.19 erweitert die BGP-Unterstützung auf den Kern von OpenShift Networking, sodass Sie Routen von Pod- und VM-Netzwerken (virtuelle Maschinen) importieren und an BGP-Peers außerhalb des Clusters bekannt geben können, wobei eine direkte Integration in die Netzwerkstruktur des Anbieters erfolgt. In Kombination mit VRF-Lite-Unterstützung können Sie ein Provider-VPN in einen OpenShift-Cluster für VMs und Pods erweitern, der als benutzerdefiniertes Netzwerk (UDN) definiert ist. Sie können auch Egress-IP-Adressen mit BGP bekannt geben.

Die BGP-Unterstützung für OpenShift Networking umfasst Unterstützung für Bidirectional Forwarding Detection (BFD). Dabei handelt es sich um ein Protokoll, das die schnelle Erkennung von Verbindungsfehlern in Netzwerkgeräten ermöglicht. So kann schnell erkannt werden, wenn eine Verbindung oder ein Pfad zwischen Geräten nicht verfügbar ist, sodass das Routing und die Weiterleitung von Informationen entsprechend angepasst werden können.

Schnellere Red Hat OpenShift Expertise mit Red Hat OpenShift Lightspeed

Dieses neue Release enthält OpenShift Lightspeed, einen virtuellen gen KI-Assistenten, der direkt in die OpenShift-Plattform integriert ist. Mit OpenShift Lightspeed können sich unerfahrene Nutzende in kurzer Zeit Kompetenzen zur Plattform aneignen, und erfahrene Nutzende können ihr Fachwissen über Produktionsabläufe skalieren. Zu den wichtigsten Funktionen gehören Unterstützung bei der Fehlerbehebung in natürlicher Sprache, die flexible Integration mit mehreren KI-Modellanbietern wie OpenAI, Azure OpenAI und IBM WatsonX sowie Funktionen für die Technologievorschau für Cluster-Interaktionen und die BYOK-Integration (Bring Your Own Knowledge). Die Lösung erweitert auch die intelligente Unterstützung für OpenShift Virtualization und vereinfacht VM-Migrationen und Modernisierungsmaßnahmen, indem sie leicht zugängliche Antworten auf virtualisierungsspezifische Fragen bereitstellt. Möchten Sie es selbst sehen? Schauen Sie sich die Demo an, die OpenShift Lightspeed in der Praxis zeigt.

Optimierte KI-Workloads mit dynamischem GPU-Slicing

Wir konzentrieren uns darauf, dass OpenShift und Red Hat OpenShift AI gemeinsam innovative Lösungen bereitstellen, die Sie bei der Beschleunigung Ihres KI-Prozesses unterstützen. Dazu zählen auch ein vollständiger durchgängiger MLOps-Lifecycle (Machine Learning Operations) mit Modellentwicklung, Training, Tuning, generativer KI und anderen KI-Workloads in privaten Rechenzentren, Cloud- und Edge-Umgebungen. Zwei interessante neue KI-bezogene Funktionen in diesem Release sind der Dynamic Accelerator Slicer und der Red Hat Build von Kueue.

Der Dynamic Accelerator Slicer, der als Technologievorschau verfügbar ist, weist GPU-Slices bedarfsgerecht, basierend auf den Workload-Anforderungen, dynamisch zu. So werden die GPU-Auslastung optimiert und die Kosten gesenkt. Der Dynamic Accelerator Slicer ersetzt die statische Pre-Slicing-Ressourcenzuweisung, die zu einer unzureichenden Auslastung der GPU führt, wenn die Workload-Anforderungen nicht mit der vorkonfigurierten GPU-Partitionsgröße übereinstimmen. Der Dynamic Accelerator Slicer wird in erster Linie für die Ausführung mehrerer LLM-Inferenzinstanzen verwendet, darunter Red Hat AI Inference Server auf einer einzigen GPU zur Unterstützung mandantenfähiger Umgebungen, in denen Teams GPU-Ressourcen gemeinsam nutzen und so eine kostengünstige KI-Entwicklung, Prüfung, und Bereitstellung von Workflows ermöglichen.

Optimierte KI-Operationen mit intelligentem Job Queuing

Der Red Hat Build von Kueue ist ein zentralisiertes, Kubernetes-natives Job Queueing-System, das Batch-Workloads durch intelligente Planung, Priorisierung und Zuweisung von Cluster-Ressourcen auf der Basis von Quotas und Verfügbarkeit verwaltet. Das System behebt Ressourcenkonflikte, indem Jobs in die Warteschlange gestellt werden, bis genügend Computing-, Speicher- oder GPU-Ressourcen verfügbar sind. Nach Fertigstellung werden sie automatisch wieder für den Pool freigegeben. Zu den Haupteinsatzbereichen des Red Hat Builds von Kueue gehören das Management von ML-Trainings-Pipelines, HPC-Workloads und Batch-Verarbeitungsjobs in mandantenfähigen Umgebungen, in denen Teams eine ausgeglichene, gemeinsame Nutzung von Ressourcen und prioritätsbasierte Planung benötigen. Weitere Informationen zu Kueue und anderen Open Source-Technologien finden Sie im Bericht von O'Reilly zum Thema Skalierbare Kubernetes-Infrastruktur für KI-Plattformen.

Sowohl der Dynamic Accelerator Slicer als auch der Red Hat Build von Kueue können mit KI-Plattformen wie OpenShift AI verwendet werden. Red Hat OpenShift AI bietet eine auf OpenShift aufsetzende KI-Plattform zur Verwaltung des Lifecycles prädiktiver und generativer KI-Modelle in großem Umfang in verschiedenen Hybrid Cloud-Umgebungen.

Angepasste Red Hat OpenShift Knoten zur Beschleunigung des Deployments von Agenten und Treibern

Der On-Cluster-Image-Modus von OpenShift bietet Unternehmen mehr Kontrolle über OpenShift-Cluster-Knoten. Er bietet eine eigenständige Lösung für die Erstellung und Verwaltung angepasster Betriebssystem-Images innerhalb eines Clusters, wobei Red Hat Enterprise Linux CoreOS (RHCOS) wie ein Container Image behandelt wird, das als Code gemanagt, als einheitliches Image erstellt und in ganzen OpenShift-Flotten konsistent bereitgestellt werden kann. Mit dieser Funktion können Unternehmen nicht containerisierte Agenten, spezielle Treiber für die Hardwarebeschleunigung oder Überwachungstools direkt zu RHCOS hinzufügen und gleichzeitig Anpassungen über Cluster-Updates beibehalten. Dadurch müssen Kunden nicht auf das nächste OpenShift-Release warten, um benutzerdefinierte Inhalts-Updates bereitzustellen. Noch wichtiger ist, dass der gesamte Build-Prozess direkt auf dem Cluster selbst stattfindet, wodurch externe CI/CD-Pipelines nicht mehr erforderlich sind und die Abläufe für Plattformteams, die umfangreiche Deployments managen, optimiert werden.

Erstellen von Routen mit extern gemanagten Zertifikaten

In OpenShift 4.19 können Routen jetzt so konfiguriert werden, dass sie TLS-Zertifikate von Zertifikatsmanagementlösungen von Drittanbietern verwenden, indem das Feld „.spec.tls.externalCertificate“ in der Routen-API verwendet wird. Dadurch kann die Route über Secrets-Ressourcen auf TLS-Zertifikate verweisen und so die Leistungsfähigkeit des cert-manager-Operators für Red Hat OpenShift nutzen, um Zertifikate in großem Umfang automatisch zu verwalten, zu erneuern und zu rotieren.

Mehr Sicherheit für Daten während der Nutzung mit Confidential Computing in Azure, Google Cloud und IBM Cloud

Sicherheit steht bei allem, was wir tun, an erster Stelle. Daher integrieren wir weiterhin Sicherheitsfunktionen in den gesamten Plattform- und Anwendungs-Lifecycle, einschließlich der Erweiterung unserer Confidential Computing-Lösungen in OpenShift. OpenShift unterstützt vertrauliche Cluster bei wichtigen Cloud-Anbietern und schützt so Daten während der Nutzung durch hardwarebasierte kryptografische Isolierung. So werden Daten nicht nur im Ruhezustand und bei der Übertragung, sondern auch während der aktiven Verarbeitung geschützt, und die Compliance-Anforderungen für regulierte Branchen und mandantenfähige Umgebungen, in denen herkömmliche Sicherheitsgrenzen nicht ausreichen, werden erfüllt.

In Google Cloud erweitert OpenShift seine Unterstützung für Confidential Nodes-Deployments auf vertraulichen VMs um VMs mit Intel TDX und AMD SEV-SNP. Mit OpenShift auf Confidential Nodes können Nutzende Daten während der Nutzung durch hardwarebasierte kryptografische Isolierung besser schützen – sogar vor dem Cloud-Anbieter selbst –, ohne dass Änderungen am Anwendungscode erforderlich sind. In ähnlicher Weise kann OpenShift 4.19 auf vertraulichen Azure-VMs mit AMD SEV-SNP-VMs bereitgestellt werden. Dies schafft robuste, hardwaregestützte Grenzen, die Workloads vor Bedrohungen auf Hypervisor-Ebene schützen und für Compliance in regulierten Branchen sorgen. Darüber hinaus integriert IBM vertrauliche Container in OpenShift für IBM Z über Hyper Protect Services und nutzt dabei OpenShift Sandbox-Container, um Container sowohl von der Infrastruktur als auch von Kubernetes-Admins zu isolieren.

Ausweitung von OpenShift Virtualization auf alle wichtigen Clouds mit vereinfachter Migration

Im Bereich der Virtualisierung können Kunden jetzt VMs innerhalb eines Clusters von einer Storage-Klasse auf eine andere Storage-Klasse migrieren, was die Massenmigration von VMs erleichtert. Unter Storage Live Migration for OpenShift Virtualization können Sie sich dieses Feature in Aktion ansehen. Kunden können Red Hat OpenShift Virtualization jetzt auch praktisch ortsunabhängig ausführen, einschließlich AWS, Azure, Google Cloud, IBM Cloud, Oracle Cloud Infrastructure und On-Premise auf Bare Metal. OpenShift Virtualization ist bereits in Red Hat OpenShift Service on AWS verfügbar. Außerdem ist es jetzt auch als Vorschau auf Microsoft Azure Red Hat OpenShift und ebenfalls als Vorschau auf Red Hat OpenShift Dedicated verfügbar. OpenShift 4.19 erleichtert unerfahrenen Nutzenden den Einstieg in OpenShift Virtualization mit einem vereinfachten OpenShift Virtualization-Installationsprogramm, das OpenShift, OpenShift Virtualization und die erforderlichen Operatoren bereitstellt, ohne dass der Kunde eine einzige YAML oder CLI verwenden muss.

Flottenmanagement in großem Umfang mit Red Hat OpenShift Platform Plus

Red Hat OpenShift Platform Plus umfasst Lösungen, die Unternehmen mit fortschrittlichen Sicherheitsfunktionen unterstützen, die bei der Entwicklung, beim Deployment und zur Laufzeit verfügbar sind. OpenShift Platform Plus unterstützt Kunden dabei, intelligente Anwendungen in großem Umfang zu verwalten und zu automatisieren. Zu den erwähnenswerten Highlights zählen das bevorstehende Erreichen der allgemeinen Verfügbarkeit von Compliance-Scans, Policy as Code sowie externen IPs für Red Hat Advanced Cluster Security for Kubernetes 4.8. Darüber hinaus wird der Schwachstellen-Scanner der nächsten Generation, der den Vex-Daten-Feed verwendet und Sprach-Scanning-Funktionen umfasst, zum Standard. Red Hat Advanced Cluster Management for Kubernetes ist jetzt On-Demand auf AWS Marketplace verfügbar und bietet On-Demand-Preise sowie eine vereinfachte, konsolidierte Abrechnungsoption für Kunden, die Red Hat Advanced Cluster Management auf Red Hat OpenShift Service on AWS ausführen. Datenschutz und Disaster Recovery sind weiterhin ein Hauptschwerpunkt von Red Hat OpenShift Data Foundation. Eine der wichtigsten Funktionen im Release ist die regionale Disaster Recovery-Unterstützung für mehrere ODF-Storage-Klassen.

Testen Sie Red Hat OpenShift 4.19 noch heute

Starten Sie noch heute mit Red Hat Hybrid Cloud Console, und profitieren Sie von den neuesten Funktionen und Verbesserungen in OpenShift. Sehen Sie sich die folgenden Ressourcen an, und finden Sie heraus, was Sie als Nächstes tun können:

- Neuerungen und nächste Schritte in Red Hat OpenShift

- What’s New in Red Hat OpenShift 4.19

- In the Clouds (ab 26. Juni 2025 verfügbar)

- YouTube-Kanal zu OpenShift

- OpenShift Blogs

- OpenShift Commons

- Red Hat Developer Blogs

- Red Hat Portfolio Architecture Center

- Validated Patterns

Eine vollständige Liste der Updates in Red Hat OpenShift 4.19 finden Sie in den Versionshinweisen zu OpenShift 4.19. Senden Sie uns Feedback über Ihre Kontakte bei Red Hat, oder erstellen Sie einen Eintrag auf GitHub.

product trial

Red Hat OpenShift Container Platform | Testversion

Über den Autor

Ju Lim works on the core Red Hat OpenShift Container Platform for hybrid and multi-cloud environments to enable customers to run Red Hat OpenShift anywhere. Ju leads the product management teams responsible for installation, updates, provider integration, and cloud infrastructure.

Mehr davon

Nach Thema durchsuchen

Automatisierung

Das Neueste zum Thema IT-Automatisierung für Technologien, Teams und Umgebungen

Künstliche Intelligenz

Erfahren Sie das Neueste von den Plattformen, die es Kunden ermöglichen, KI-Workloads beliebig auszuführen

Open Hybrid Cloud

Erfahren Sie, wie wir eine flexiblere Zukunft mit Hybrid Clouds schaffen.

Sicherheit

Erfahren Sie, wie wir Risiken in verschiedenen Umgebungen und Technologien reduzieren

Edge Computing

Erfahren Sie das Neueste von den Plattformen, die die Operations am Edge vereinfachen

Infrastruktur

Erfahren Sie das Neueste von der weltweit führenden Linux-Plattform für Unternehmen

Anwendungen

Entdecken Sie unsere Lösungen für komplexe Herausforderungen bei Anwendungen

Virtualisierung

Erfahren Sie das Neueste über die Virtualisierung von Workloads in Cloud- oder On-Premise-Umgebungen