Maximieren von KI-Innovationen mit Open Source-Modellen

Vereinfachen von generativer KI im gesamten Unternehmen

Generative künstliche Intelligenz (KI) transformiert auch weiterhin branchenübergreifend, wie Unternehmen ihre Abläufe managen, Entscheidungen treffen und innovative Lösungen bereitstellen.

Von personalisierten Kundenerlebnissen und dem automatisierten Erstellen von Inhalten bis hin zur besseren Unterstützung beim Treffen von Entscheidungen – mithilfe von generativer KI können Unternehmen Prozesse optimieren, die Produktivität steigern und neue Möglichkeiten erkunden. Wenn Unternehmen in innovative KI-Lösungen investieren, stärken sie ihre Fähigkeit, Komplexität zu bewältigen, auf Änderungen in der Nachfrage reagieren und ihre strategischen Ziele zu erreichen.

Viele sehen sich jedoch Herausforderungen gegenüber, wenn es darum geht, das Potenzial generativer KI-Technologien voll auszuschöpfen. Proprietäre Large Language Models (LLMs) bringen hohe Lizenzkosten mit sich und erfordern umfassende Hardwareressourcen für das Modelltraining und Inferenzen. Ihre Bereitstellung und Wartung in unternehmensgerechten IT-Umgebungen ist daher teuer. Das Training und Fine Tuning von LLMs für spezifische Use Cases bestimmter Kunden und Branchen kann schwierig sein, wenn es Entwicklungsteams und den Fachleuten im Unternehmen, die über ein umfassendes Verständnis der Anwendungs- und Geschäftsanforderungen verfügen, am notwendigen Spezialwissen im Bereich Data Science mangelt. Proprietäre, vertrauliche Daten, die in komplexen Hybrid Cloud-Umgebungen gespeichert sind – darunter private Rechenzentren, Public Cloud-Ressourcen und Edge Deployments –, können zudem ein effektives Trainieren generativer KI-Modelle erschweren. Dies gilt insbesondere, wenn behördliche Anforderungen Datenbewegungen zwischen Standorten einschränken.

Red Hat bietet einen vereinfachten Ansatz, mit dem generative KI für Entwicklungsteams und Domainfachkräfte sämtlicher Unternehmensbereiche zugänglicher wird. Mit Red Hat® AI können Sie generative KI-Modelle effizient auf Deployments von Produktionsservern trainieren und ausführen. Dadurch können Ihre Teams die KI-Einführung beschleunigen und unnötige Komplexitäten bei der Umsetzung verhindern.

80 %der Unternehmen glauben, dass generative KI ihre Geschäftsabläufe innerhalb der nächsten 18 Monate verändern wird.1

Beschleunigte Innovation mit aufgabenspezifischen Small Language Models

LLMs verfügen über Funktionen, durch die sie natürliche Sprache verstehen und generieren können. Der beachtliche Rechenaufwand für ressourcenintensive Trainings und Inferenzen kann LLMs jedoch für viele Geschäftsanwendungen als Option unbrauchbar machen. Für die meisten Unternehmen sind solche umfassenden Funktionen glücklicherweise nicht notwendig, da gezieltere, aufgabenspezifische Small Language Models (SLMs) ihren Anforderungen besser gerecht werden.

SLMs sind kleiner und erfordern bedeutend weniger Rechenressourcen, Daten und Strom. Das macht sie zu effizienten, kostengünstigen generativen KI-Modellen für viele Unternehmensanwendungen. Sie ermöglichen ein schnelleres Modelltraining und vereinfachtes Fine Tuning und bieten einen nachhaltigeren Ansatz für die KI-Entwicklung. SLMs optimieren das Deployment und verbessern die Performance von KI-basierten Anwendungen, was die Kosten reduzieren kann. Gleichzeitig liefern sie maßgeschneiderte, innovative Lösungen, damit Sie Ihre geschäftlichen Ziele erreichen.

SLMs bieten Unternehmen mehrere Vorteile. Dank der kompakten Größe und den geringeren Datenanforderungen lassen sich SLMs schnell und effizient für spezifische Aufgaben oder Domains anpassen. So ermöglichen sie genauere und kostengünstigere generative KI-Modelle. Wenn Sie organisatorische Informationen und Fachwissen während des Modelltrainings direkt in die SLM-Parameter einbetten, können Sie die Relevanz des Modells verbessern, die Anforderungen von Retrainings reduzieren und die Entwicklungszeit Ihrer wichtigen KI-basierten Anwendungen und Services verkürzen. Da Sie SLMs effizient in den Onsite- oder Private Cloud-Umgebungen Ihrer Unternehmens-IT bereitstellen können, vereinfacht ihr Einsatz den Schutz sensibler, proprietärer Trainingsdaten. SLMs bieten außerdem eine bessere Zugriffskontrolle, vereinfachen die Compliance mit gesetzlichen Vorschriften und reduzieren die Abhängigkeit von externen Anbietern. In ressourcenbeschränkten Umgebungen und Edge Deployments ermöglichen SLMs zudem, dass Echtzeitanwendungen direkt auf Nutzergeräten ausgeführt werden. Dies optimiert die Entwicklung und lässt die Notwendigkeit einer externen Cloud-Infrastruktur entfallen.

In diesem Video erfahren Sie mehr über die Vorteile von Small Language Models.

Mehr Kontrolle mit generativer KI und Open Source

Die Nutzung kommerzieller KI-Lösungen lässt oft Bedenken hinsichtlich Transparenz, Sicherheit und Datenschutz aufkommen. Gleichzeitig kann die Unsicherheit in Bezug auf die verwendeten Trainingsdaten und die Genauigkeit der Antworten das rechtliche Risiko der Unternehmen erhöhen. Um diesen Herausforderungen gerecht zu werden, setzen LLMs zunehmend auf Open Source und bieten dadurch mehr Freiheit, Auswahl und Transparenz. Das führt zu mehr Vertrauen und ermöglicht Ihnen, die genutzten Modelle besser zu verstehen und anzupassen.

Open Source-LLMs und -SLMs beinhalten sowohl – vorab durch einen bewährten Anbieter trainierte – Open Source-lizenzierte Softwarekomponenten als auch Modellgewichtungen. So können Sie Ihre Daten und Ihr Fachwissen auf transparente und zuverlässige Weise zu den Basismodellen und Trainingsdatensätzen beisteuern. Darüber hinaus können Sie damit einen Vendor Lock-in vermeiden: Sie behalten also die volle Kontrolle über Ihre KI-Lösungen, ohne an proprietäre Systeme gebunden zu sein. Da bewährte Anbieter den Ursprung der Daten offenlegen, mit denen die Open Source-Modelle trainiert wurden, können Sie die Modellqualität vorab bewerten. So können Sie sicherstellen, dass keine schädlichen oder verzerrten Daten enthalten sind, bevor Sie Ihre eigenen proprietären und vertraulichen Daten hinzufügen. Außerdem helfen offene Governance-Praktiken dabei, Verzerrungen während der Modellentwicklung zu identifizieren und abzuschwächen, was das Vertrauen in KI-Systeme und die Unvoreingenommenheit der Modelle fördert.

Die Open Source-LLMs, die unter der Apache 2.0-Lizenz vertrieben werden, geben Ihnen die Flexibilität, Ihre Modelle zu personalisieren und zu kontrollieren. So stellen Sie sicher, dass Sie Ihre innovativen KI-Lösungen an die jeweiligen geschäftlichen Anforderungen anpassen können.

Die leistungsstarke Kombination von Open Source und KI

Open Source- Ansätze entwickeln sich zu einem wichtigen Faktor, wenn es darum geht, Vertrauen

in generative KI-Technologien zu schaffen. In den folgenden Ressourcen erfahren Sie mehr über die Auswirkungen von Open Source im Bereich KI:

- In diesem Blog erfahren Sie, wie Open Source Communities KI-Technologien vorantreiben.

- Dieser Blog beleuchtet, warum das Vertrauen und die Zuversicht in Bezug auf Open Source-KI-Technologien

bei Unternehmen wächst. - In diesem Video sehen Sie, wie Sie selbst Ihren Beitrag zu Open Source-KI-Initiativen leisten können.

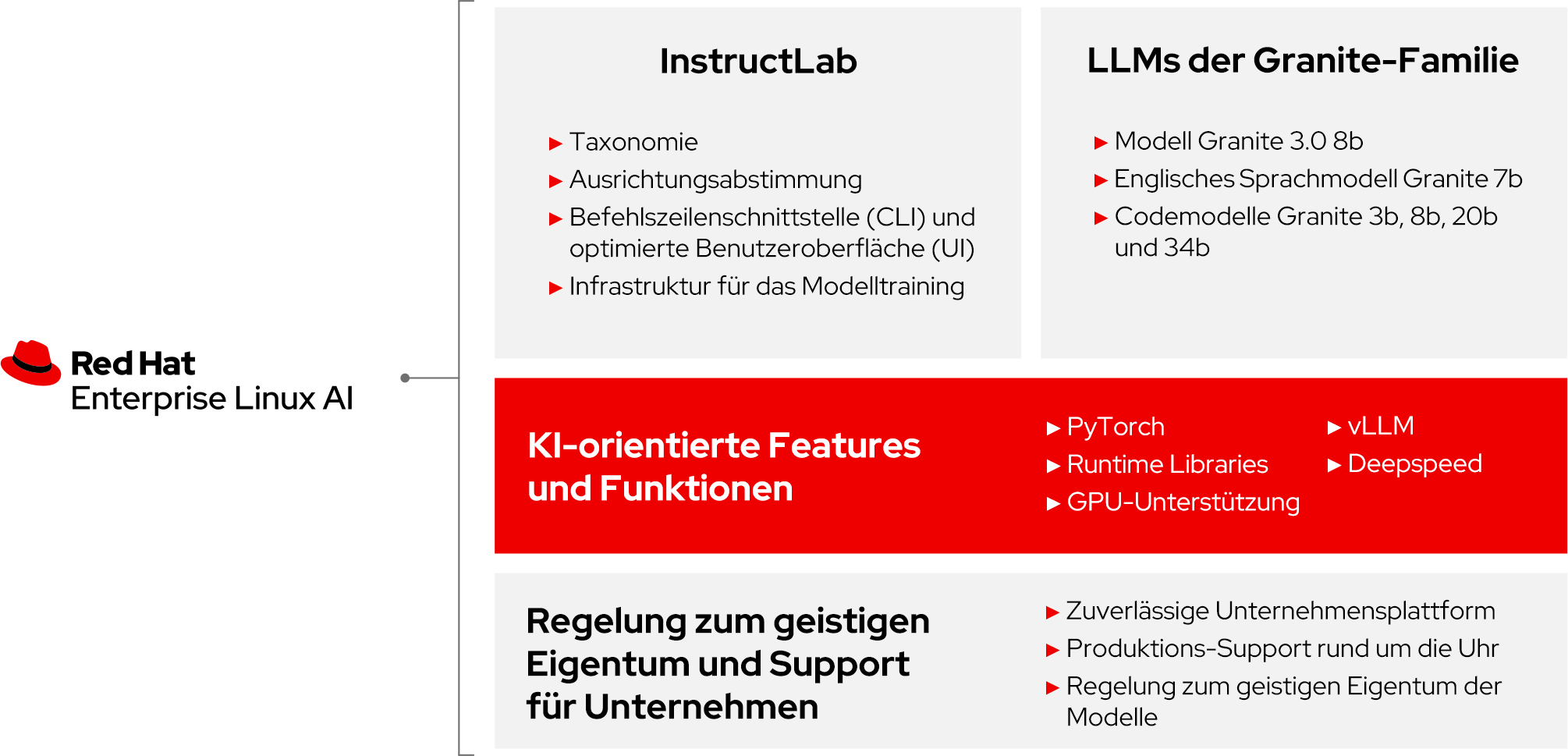

Optimierte KI-Entwicklung mit Red Hat Enterprise Linux AI

Die Bereitstellung von KI-Lösungen, die nicht nur kostengünstig, sondern auch auf die konkreten geschäftlichen Anforderungen zugeschnitten sind, kann für viele Unternehmen zu einer wahren Herausforderung werden.Red Hat Enterprise Linux® AI bietet eine konsistente, stabile Basismodell-Plattform, mit der Sie die Entwicklung und Bereitstellung innovativer, unternehmensgerechter generativer KI-Lösungen beschleunigen und vereinfachen.

Mit modernen Features und Funktionen für das Trainieren, Testen und Ausführen aufgabenspezifischer SLMs unterstützt Red Hat Enterprise Linux AI Sie dabei, kostengünstige, individuell angepasste KI-Anwendungen und -Services zu entwickeln. Zu den wichtigen Komponenten der Plattform gehört die Granite-Familie der generativen KI-Modelle mit Open Source-Lizenz, deren Distribution unter der Lizenz Apache 2.0 für Transparenz in den Trainingsdatensätzen sorgt. Die Granite-Familie erleichtert und beschleunigt den Einstieg in generative KI, da sie kleinere, effizientere Modelle verwendet und so die Betriebskosten reduziert, ohne die Performance zu beeinträchtigen. Weiterhin enthalten sind InstructLab-Modellanpassungstools, die das Fine Tuning erleichtern. Sie machen KI für Entwicklungs- und Domain-Fachkräfte einfacher zugänglich, indem sie die Modelle an organisationsbezogenen Daten ausrichten und den Zugriff auf generative KI-Modelle ausweiten, die von der Community entwickelt wurden.

Red Hat Enterprise Linux AI wird als bootfähiges Image mit beliebten KI-Libraries wie PyTorch und hardwareoptimierten Beschleunigern von NVIDIA, Intel und AMD geliefert. Dies vereinfacht die Integration wichtiger KI-Technologien und optimiert gleichzeitig das Modelltraining und Inferenzen auf Produktionsservern, damit Sie Ihre generativen KI-Projekte wirkungsvoll starten können. Durch technischen Support für die Produktion und Regelungen für das geistige Eigentum an den Modellen können Sie Risiken mindern und sich ganz auf das Entwickeln, Bereitstellen und Verwalten innovativer KI-Lösungen konzentrieren, die Vertrauen, Transparenz und Kosteneffizienz bieten.

Open Source-Granite-Modelle für Unternehmens-KI einführen

Für erfolgreiche KI-Anwendungen und -Services sind Modelle erforderlich, die Transparenz, Kosten und Performance im Gleichgewicht halten und dabei den Anforderungen von Unternehmensanwendungen gerecht werden. Die auf Open Source basierenden generativen KI-Modelle der Granite-Familie wurden von IBM für die Anforderungen von Unternehmensanwendungen und echten Geschäftsszenarien entwickelt. Diese auf Performance und Kosten optimierten Modelle unterstützen eine Bandbreite an Use Cases für generative KI, die sowohl Sprache als auch Code umfassen. Die Open Source-Modellserie der Granite-Familie umfasst das Modell Granite 3.0 8b, die englischen Sprachmodelle Granite 7b sowie die Codemodelle Granite 3b, 8b, 20b und 34b.

Granite-Modelle werden unter der Lizenz Apache 2.0 vertrieben und bieten so volle Open Source-Zugänglichkeit. Diese Basis-KI-Modelle werden unabhängig entwickelt und stammen nicht von proprietären oder von nicht quelloffenen Modellen. Außerdem legt IBM die Datensätze und Methoden offen, die für das Training verwendet werden, und bietet so mehr Transparenz und Vertrauen für Ihre wichtigen KI-Lösungen. Dieser Fachaufsatz zu den Granite 3.0-Sprachmodellen gewährt Ihnen detaillierte Einblicke in Trainingsdaten und -praktiken, die zeigen, wie sehr sich IBM für Transparenz und Verantwortlichkeit einsetzt.

Die Open Source-Sprach- und Codemodelle der Granite-Familie, deren geistiges Eigentum vollständig durch Red Hat geregelt ist, bieten eine unternehmensgerechte Lösung für das Entwickeln und Bereitstellen maßgeschneiderter KI-Anwendungen. Mit den innovativen Modellen von IBM in Kombination mit der Zuverlässigkeit und dem Support der Plattformen von Red Hat können Sie auf Open Source basierende generative KI-Lösungen zuversichtlich einführen, um damit Ihre geschäftlichen Herausforderungen zu meistern und die Risiken in Ihrem gesamten Unternehmen zu mindern.

In diesem Video erfahren Sie mehr über die Open Source-Modellreihen der Granite-Familie.

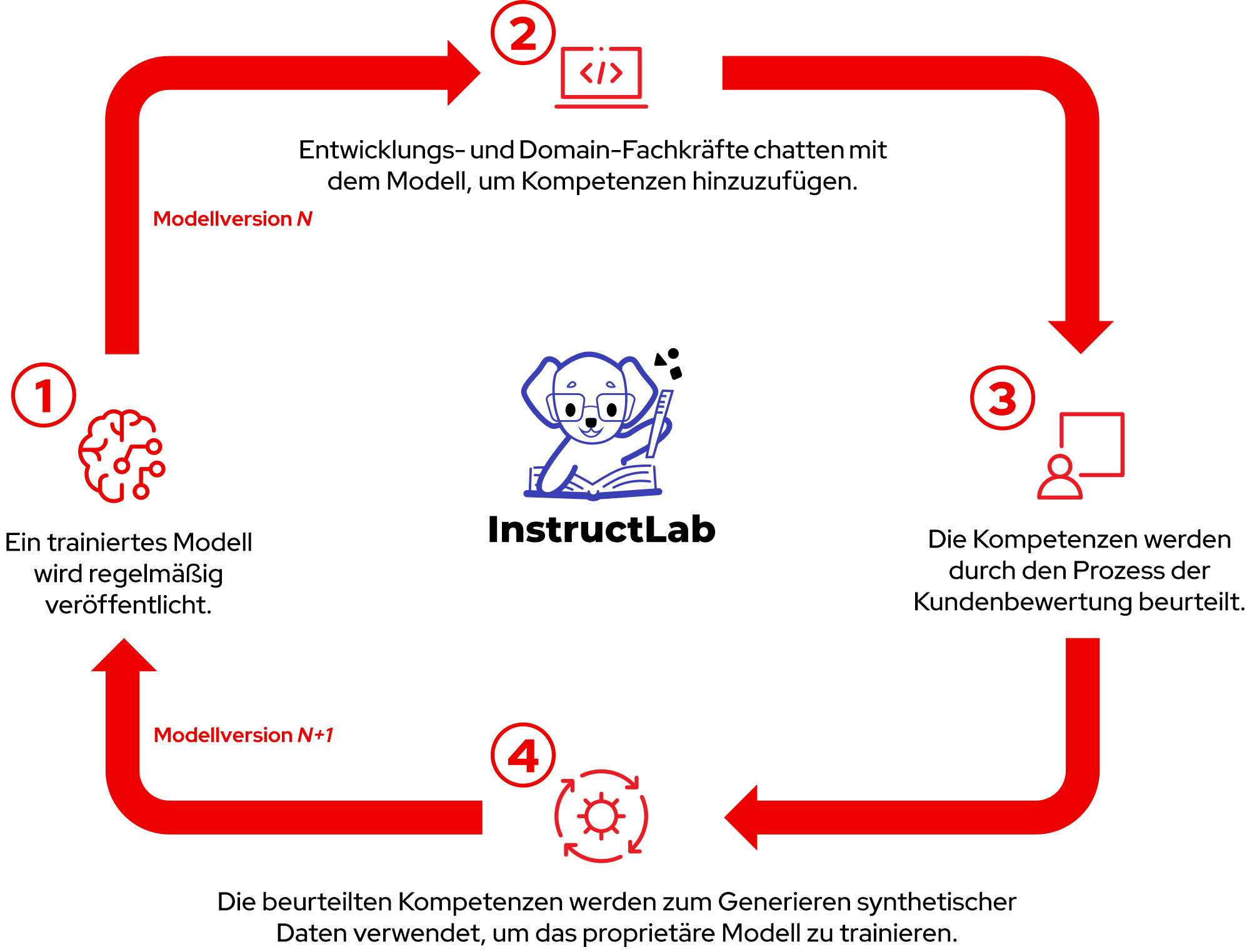

Die KI-Entwicklung mit InstructLab demokratisieren

Generative KI-Modelle an Ihren geschäftlichen Anforderungen auszurichten, kann sich als schwierige, zeitaufwendige Aufgabe herausstellen – insbesondere, wenn Ihr Unternehmen über begrenzte Kenntnisse und Ressourcen verfügt. Mithilfe der Modellabstimmungstools von InstructLab können Sie generative KI-Modelle mit Spezialwissen und besonderen Kompetenzen individuell anpassen. InstructLab basiert auf der Technologie Large-Scale Alignment for ChatBots (LAB) und verwendet einen taxonomieorientierten Ansatz, um Modelle mit synthetischen Daten von hoher Qualität zu generieren und zu trainieren. So können Sie KI-Modelle mit viel weniger von Menschen generierten Daten und reduzierten Rechenressourcen verbessern, als normalerweise für das Retraining eines Modells erforderlich sind.

InstructLab vereinfacht das Training und Fine Tuning, wodurch sich viele verschiedene Mitwirkende – auch Entwicklungs- und Domain-Fachkräfte ohne umfangreiche Erfahrung im Bereich Data Science – an der Entwicklung des generativen KI-Modells beteiligen können. Somit befähigt InstructLab auch Fachexpertinnen und -experten, direkt am Erstellen innovativer KI-Lösungen mitzuwirken. Dadurch wird die Zusammenarbeit zwischen technischen Teams und geschäftlichen Stakeholdern gefördert und gewährleistet, dass die KI-Anwendungen und -Services sich an tatsächlichen Anforderungen ausrichten. Durch diese Demokratisierung der KI-Modellanpassung wird die Wertschöpfung beschleunigt und Ihr gesamtes Unternehmen beim Weiterentwickeln und Optimieren Ihrer Modelle unterstützt, sodass Sie geschäftliche Ziele effektiver erreichen können. So lassen sich Ihre generativen KI-Modelle an Ihren operativen und strategischen Zielen ausrichten und die Genauigkeit und Relevanz wichtiger KI-Lösungen verbessern. Mit einer effizienten und kostengünstige Integration von geschäftlichem Fachwissen unterstützt InstructLab Sie dabei, Ergebnisse schneller zu erreichen und den ROI (Return on Investment) Ihrer KI-Investitionen zu erhöhen.

InstructLab unterstützt einen iterativen Ansatz für das Fine Tuning generativer KI-Modelle. Dies fördert die Zusammenarbeit, da Teammitglieder ihr Fachwissen beisteuern und Fachexpertinnen und -experten die Beiträge anschließend validieren und genehmigen können. Mit einem solchen Prozess sorgen Sie dafür, dass Ihre Modelle transparent, relevant und unverfälscht bleiben, wenn sie sich weiterentwickeln.

Sehen Sie sich dieses Video an, um mehr über das Training generativer KI-Modelle mit InstructLab zu erfahren.

Stellen Sie eine zuverlässige Basis für KI-Innovationen bereit.

Unabhängig davon, in welcher Phase der KI-Einführung Sie sich gerade befinden: Red Hat Enterprise Linux AI bietet die Konsistenz, Zuverlässigkeit und Innovationen, die Sie für Ihren KI-Erfolg brauchen. Ein bewährtes Open Source-Betriebssystem und integrierte KI-Technologien erleichtern Ihnen den Einstieg bei Ihren ersten KI-Projekten, sodass Sie Ihre Ideen schneller vom Konzept bis in die Produktion bringen können.

Erfahren Sie mehr über Red Hat Enterprise Linux AI.

Kostenlose 60-tägige Testversion von Red Hat Enterprise Linux AI

Nutzen Sie den Zugriff auf eine kostenlose 60-tägige Self Support-Subskription mit nützlichen Ressourcen, in deren Rahmen Ihr Unternehmen die generativen KI-Modelle der Granite-Familie für Unternehmensanwendungen entwickeln, trainieren, testen und ausführen kann.

Beschleunigter Einstieg mit fachkundiger Anleitung

Planen und entwickeln Sie gemeinsam mit unseren Expertinnen und Experten KI-Lösungen, die echte geschäftliche Ergebnisse liefern. Unabhängig davon, ob Sie gerade erst mit generativer KI beginnen oder Ihre KI-Funktionen ausweiten wollen – Red Hat Services kann Sie unterstützen.

E-Book von IDC: „Are You Ready for AI Everywhere?“, 2024.