-

Documentación del producto Red Hat AI

Cartera de productos y servicios destinados al desarrollo y a la implementación de la inteligencia artificial en toda la nube híbrida

Red Hat AI Inference Server

Optimiza el rendimiento del modelo con vLLM para realizar inferencias rápidas y rentables según la necesidad.

Red Hat Enterprise Linux AI

Desarrolla, prueba y ejecuta modelos de inteligencia artificial generativa para aplicaciones empresariales.

Red Hat OpenShift AI

Diseña e implementa aplicaciones y modelos basados en inteligencia artificial en entornos híbridos según sea necesario.

-

Capacitación Conceptos básicos

Casos prácticos de los productos

-

Partners de IA

Red Hat OpenShift AI

Red Hat® OpenShift® AI es una plataforma que permite administrar el ciclo de vida de los modelos de inteligencia artificial predictiva y generativa en los distintos entornos de nube híbrida según sea necesario.

Red Hat OpenShift AI

Está diseñada con tecnologías de open source y proporciona funciones confiables y uniformes en términos operativos para que los equipos realicen pruebas, pongan los modelos a disposición de los usuarios y distribuyan aplicaciones innovadoras.

OpenShift AI permite la recopilación y preparación de los datos; el entrenamiento, el ajuste, la distribución y la supervisión de los modelos; y la aceleración del hardware. Gracias al ecosistema abierto de partners de hardware y software, la plataforma brinda la flexibilidad necesaria para tu caso práctico específico.

Agiliza el paso de las aplicaciones con inteligencia artificial a la etapa de producción

Combina las funciones probadas de Red Hat OpenShift AI y Red Hat OpenShift en una única plataforma de aplicaciones de inteligencia artificial lista para las empresas que reúne a todos los equipos. De esta forma, los analistas de datos, los ingenieros y los desarrolladores de aplicaciones pueden colaborar en una única ubicación y, así, fomentar la uniformidad, la seguridad y la capacidad de ajuste.

El lanzamiento más reciente de OpenShift AI incluye un conjunto seleccionado de modelos de terceros optimizados, listos para utilizar en la etapa de producción y validados para Red Hat OpenShift AI. Al acceder a este catálogo de modelos de terceros, tu equipo puede controlar mejor la accesibilidad y la supervisión de los modelos para así facilitar el cumplimiento de los requisitos de seguridad y de las políticas.

Además, OpenShift AI permite gestionar los costos de la inferencia con el servicio distribuido a través de un marco de vLLM optimizado. Para reducir aún más la complejidad operativa, ofrece una serie de herramientas avanzadas que permiten automatizar las implementaciones y el acceso de autoservicio a los modelos, las herramientas y los recursos.

Características y ventajas de Red Hat OpenShift AI

Menos tiempo para la gestión de la infraestructura de la inteligencia artificial

Ofrece a tus equipos acceso según se solicite a los recursos, para que puedan gestionar sus entornos de entrenamiento y distribución de modelos de forma autónoma y adaptarlos a sus necesidades. Además, reduce la complejidad operativa con la gestión de aceleradores de inteligencia artificial (GPU) y recursos de carga de trabajo en un entorno de clúster ajustable.

Herramientas de inteligencia artificial/machine learning probadas y compatibles

Red Hat prueba, integra y respalda las herramientas de inteligencia artificial/machine learning (aprendizaje automático) y la distribución de modelos para que tú no tengas que hacerlo. OpenShift AI es el fruto de varios años de preparación en nuestro proyecto comunitario Open Data Hub y proyectos open source, como Kubeflow.

Nuestra experiencia y conocimientos en el área de la tecnología de open source nos permiten ofrecer una base lista para la aplicación de la inteligencia artificial generativa, de manera que los clientes puedan disponer de más opciones a la hora de decidir sus estrategias sobre esta tecnología y puedan hacerlo con mayor confianza.

Flexibilidad en la nube híbrida

Red Hat OpenShift AI está disponible como software autogestionado o como servicio de nube totalmente gestionado en OpenShift, y proporciona una plataforma segura y flexible que te permite elegir el entorno para desarrollar e implementar tus modelos, ya sea en las instalaciones, la nube pública o el extremo de la red.

Utiliza nuestras prácticas recomendadas

Red Hat Services proporciona conocimientos, capacitación y soporte que te permiten superar los desafíos de la inteligencia artificial sin importar la etapa del proceso de adopción en la que te encuentres.

Ya sea que quieras crear un prototipo de una solución de inteligencia artificial, optimizar la implementación de tu plataforma de esta tecnología o mejorar tus estrategias de MLOps, Red Hat Consulting te brindará soporte y asesoría.

Optimiza los modelos con vLLM para realizar inferencias rápidas y rentables según se requiera

Red Hat AI Inference Server forma parte de la plataforma de Red Hat AI. Se encuentra disponible como producto independiente y viene incluido en Red Hat Enterprise Linux® AI y Red Hat OpenShift® AI.

Partners de inteligencia artificial

Utiliza Red Hat OpenShift AI con otros servicios y productos integrados para obtener un mayor rendimiento de la plataforma.

NVIDIA y Red Hat brindan a sus clientes una plataforma con capacidad de ajuste que acelera una amplia variedad de casos prácticos de la inteligencia artificial con una flexibilidad incomparable.

Intel® y Red Hat ayudan a las empresas a agilizar la adopción de la inteligencia artificial y el uso de los modelos de inteligencia artificial/machine learning.

IBM y Red Hat facilitan innovaciones open source para acelerar el desarrollo de la inteligencia artificial, como IBM watsonx.aiTM, un estudio de inteligencia artificial listo para las empresas y destinado a los desarrolladores de esa tecnología.

Starburst Enterprise y Red Hat permiten obtener información más precisa y actualizada mediante el análisis rápido de los datos en varias plataformas distribuidas y dispares.

Kubernetes con capacidad de ajuste para plataformas de inteligencia artificial

Descubre el modo de aplicar los principios y prácticas de las operaciones de machine learning (MLOPs) para crear aplicaciones basadas en la inteligencia artificial.

Colaboración mediante entornos de trabajo modelos

Brinda imágenes de clústeres personalizados o desarrollados previamente a tus analistas de datos para que trabajen con modelos que utilicen su IDE preferido, como JupyterLab. Red Hat OpenShift AI realiza un seguimiento de los cambios en Jupyter, TensorFlow, PyTorch y otras tecnologías de open source de inteligencia artificial.

Adaptación de la puesta a disposición de los modelos con Red Hat OpenShift AI

Los modelos pueden utilizarse con una versión optimizada de vLLM (u otros servidores de modelos que elijas) para integrarlos a las aplicaciones con inteligencia artificial en las instalaciones, la nube pública o el extremo de la red. Además, pueden volver a diseñarse e implementarse y se controlan según los cambios en el notebook fuente.

El sesgo y la deriva pueden comprometer la integridad de tus modelos y dificultar su ajuste. Para mantener la imparcialidad, la seguridad y la capacidad de ajuste, OpenShift AI permite que los especialistas en datos supervisen la adecuación entre los resultados del modelo y los datos de su entrenamiento.

Las herramientas de detección de deriva pueden supervisar las inferencias efectuadas por los modelos y determinar cuándo los datos en vivo que se utilizan para el proceso de inferencia se desvían de los datos de entrenamiento originales. Los sistemas de seguridad de la inteligencia artificial también se incluyen para proteger las entradas y los resultados de tu modelo de la información dañina, como el lenguaje abusivo y vulgar, los datos personales o las restricciones específicas del área.

Patrón de la solución

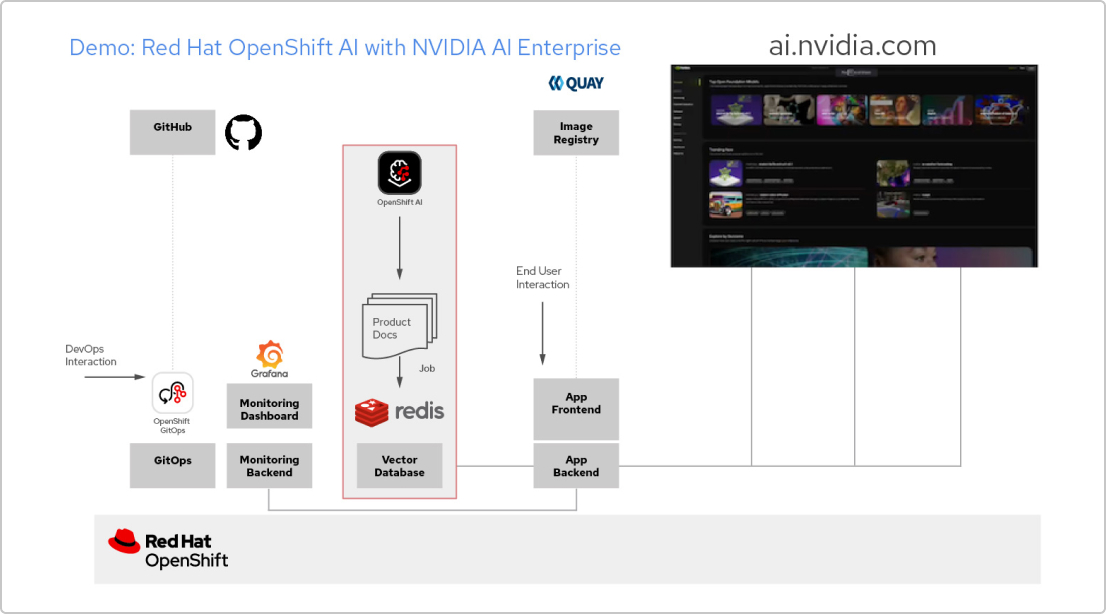

Aplicaciones de inteligencia artificial con NVIDIA AI Enterprise y Red Hat

Cree una aplicación RAG

Red Hat OpenShift AI es una plataforma para diseñar proyectos de análisis de datos y distribuir aplicaciones que utilizan la inteligencia artificial. Con ella puede integrar todas las herramientas que necesita para respaldar la generación aumentada por recuperación (RAG), un método para obtener respuestas de la inteligencia artificial desde sus documentos de referencia. Cuando conecta OpenShift AI con NVIDIA AI Enterprise, puede experimentar con los modelos de lenguaje de gran tamaño (LLM) para encontrar el más adecuado para su aplicación.

Diseñe un canal para los documentos

Para usar la RAG, primero debe incorporar los documentos en una base de datos vectorial. En nuestra aplicación de ejemplo, integramos un conjunto de documentos de productos en una base de datos de Redis. Ya que estos cambian con frecuencia, podemos crear un canal para este proceso que ejecutaremos de forma regular y, de esta forma, siempre tendremos las versiones más recientes de ellos.

Consulte el catálogo de LLM

NVIDIA AI Enterprise brinda acceso a un catálogo de distintos LLM, por lo que puede probar diferentes opciones y elegir el modelo que ofrezca los mejores resultados. Estos modelos se alojan en el catálogo de NVIDIA API. Una vez que haya configurado un token de interfaz de programación de aplicaciones (API), puede implementar un modelo utilizando la plataforma de distribución de NVIDIA NIM directamente desde OpenShift AI.

Seleccione el modelo adecuado

A medida que prueba distintos LLM, los usuarios tienen la posibilidad de calificar cada respuesta que se genera. Puede configurar un panel de control de Grafana para comparar las calificaciones, además de la latencia y los tiempos de respuesta de cada modelo. Luego, puede usar esos datos para elegir el mejor LLM para implementar en la producción.

Prueba Red Hat OpenShift AI

Developer Sandbox

Está destinado a desarrolladores y analistas de datos que deseen realizar pruebas del diseño de aplicaciones con inteligencia artificial en un entorno flexible y configurado previamente.

Versión de prueba de 60 días

Cuando tu empresa esté lista para evaluar todas las funciones de OpenShift AI, accede a la versión de prueba del producto de 60 días. Debes poseer un clúster de Red Hat OpenShift para hacerlo.