-

Produits et documentation Red Hat AI

Plateforme de produits et de services pour le développement et le déploiement de l'IA dans le cloud hybride.

Red Hat AI Inference Server

Optimisez les performances des modèles avec un vLLM pour des inférences rapides et rentables à grande échelle.

Red Hat Enterprise Linux AI

Développez, testez et exécutez des modèles d'IA générative pour alimenter les applications d'entreprise.

Red Hat OpenShift AI

Assemblez et déployez des modèles et applications basés sur l'IA à grande échelle dans des environnements hybrides.

-

Ressources Bases

-

Partenaires pour l'IA

Red Hat OpenShift AI

La plateforme Red Hat® OpenShift® AI permet de gérer le cycle de vie des modèles d'IA générative et prédictive, à grande échelle, dans les environnements de cloud hybride.

Présentation de Red Hat OpenShift AI

Conçue autour de technologies Open Source, la plateforme Red Hat OpenShift AI offre aux équipes des fonctionnalités fiables et cohérentes pour faire des expériences, déployer des modèles et distribuer des applications innovantes.

En plus de l'accélération du matériel, cette solution permet l'acquisition et la préparation des données ainsi que l'entraînement, la surveillance, l'ajustement et le déploiement des modèles. En association avec les solutions Open Source de nos partenaires fournisseurs de matériel et de logiciels, OpenShift AI offre la flexibilité nécessaire pour traiter les cas d'utilisation spécifiques.

Accélération de la mise en production des applications basées sur l'IA

Réunissez vos équipes autour d'une seule et même plateforme d'applications d'IA pour les entreprises, qui associe les capacités éprouvées de Red Hat OpenShift AI et de Red Hat OpenShift. Les équipes de science des données, d'ingénierie et de développement d'applications peuvent collaborer au sein d'un espace unique qui favorise la cohérence, la sécurité et l'évolutivité.

La dernière version d'OpenShift AI inclut une sélection de modèles tiers optimisés et prêts pour la production, validés pour Red Hat OpenShift AI. L'accès à ce catalogue de modèles tiers offre à votre équipe un meilleur contrôle de l'accessibilité et de la visibilité des modèles, afin de répondre aux exigences de sécurité et de conformité.

De plus, OpenShift AI réduit les coûts liés aux inférences grâce à l'intégration du framework vLLM optimisé pour un déploiement distribué. Et pour simplifier l'exploitation, la solution inclut des outils avancés qui permettent d'automatiser les déploiements et l'accès en libre-service aux modèles, aux outils et aux ressources.

Fonctions et avantages

Réduction du temps consacré à la gestion de l'infrastructure d'IA

Donnez à vos équipes la possibilité d'accéder aux ressources à la demande, pour qu'elles puissent intervenir elles-mêmes dans l'entraînement des modèles et leur déploiement dans les environnements, en fonction des besoins. Simplifiez par ailleurs vos processus d'exploitation en gérant les accélérateurs d'IA (GPU) et les ressources des charges de travail dans un environnement évolutif en cluster.

Outils d'IA/AA testés et pris en charge

Nos équipes s'occupent à votre place de l'intégration, des tests et de la prise en charge des outils et du déploiement de modèles d'IA/AA. La solution OpenShift AI s'appuie sur notre projet communautaire Open Data Hub développé depuis plusieurs années ainsi que sur d'autres projets Open Source, notamment Kubeflow.

Grâce à notre expérience et à notre expertise en matière d'Open Source, nous pouvons proposer une base optimisée pour l'IA générative afin que les clients bénéficient de davantage de choix et d'une plus grande confiance dans leurs stratégies d'IA générative.

Flexibilité dans le cloud hybride

Disponible sous forme de logiciel autogéré ou de service cloud entièrement géré et exécuté sur OpenShift, Red Hat OpenShift AI offre une plateforme sûre et flexible qui vous permet de développer et déployer vos modèles dans l'environnement de votre choix : sur site, dans le cloud public ou en périphérie du réseau.

Mise en œuvre de nos meilleures pratiques

Les services Red Hat fournissent une expertise, des formations et une assistance qui vous aident à relever les défis posés par l'IA, quelle que soit votre situation dans le parcours d'adoption.

Que vous souhaitiez mettre au point une solution d'IA, rationaliser le déploiement de votre plateforme d'IA ou optimiser vos stratégies MLOps, l'équipe de consulting Red Hat vous apportera son soutien et vous accompagnera tout au long de votre projet.

Optimisation avec un vLLM pour des inférences rapides et rentables, à grande échelle

Red Hat AI Inference Server fait partie de la plateforme Red Hat AI. La solution est disponible sous forme de produit autonome et est également incluse dans Red Hat Enterprise Linux® AI et Red Hat OpenShift® AI.

Partenariats

Tirez le meilleur parti de la plateforme Red Hat OpenShift AI en l'associant à d'autres produits et services.

NVIDIA et Red Hat offrent aux clients une plateforme évolutive qui accélère divers cas d'utilisation de l'IA avec une flexibilité inégalée.

Intel® et Red Hat aident les entreprises à accélérer l'adoption de l'IA et l'exploitation des modèles d'IA/AA.

IBM et Red Hat proposent des innovations Open Source pour accélérer le développement de l'IA, notamment grâce à IBM watsonx.aiTM, un studio d'IA prêt à l'emploi pour les créateurs d'IA.

Starburst Enterprise et Red Hat contribuent à améliorer la précision et la pertinence des informations grâce à une analyse rapide des données sur plusieurs plateformes de données disparates et distribuées.

Une infrastructure Kubernetes évolutive pour les plateformes d'IA

Découvrez comment appliquer les principes et pratiques MLOps (Machine Learning Operations) pour créer des applications basées sur l'IA.

Collaboration via des ensembles d'outils pour les modèles

Fournissez à vos équipes de science des données des images de cluster précréées ou personnalisées pour travailler sur des modèles dans l'environnement de développement intégré de leur choix, comme JupyterLab. La solution Red Hat OpenShift AI suit les changements apportés à de nombreuses technologies Open Source d'IA, notamment Jupyter, TensorFlow et PyTorch.

Déploiement évolutif des modèles avec Red Hat OpenShift AI

Il est possible de déployer les modèles à l'aide d'une version optimisée du vLLM (ou d'autres serveurs de modèles de votre choix) afin de les intégrer à des applications basées sur l'IA dans le cloud public, sur site ou à la périphérie du réseau. Il est possible de les récréer, de les redéployer et de les surveiller en fonction des modifications apportées au notebook source.

Les biais et dérives peuvent compromettre l'intégrité de vos modèles et compliquer leur mise à l'échelle. Afin de préserver l'objectivité, la sécurité et l'évolutivité, OpenShift AI permet aux spécialistes des données de surveiller l'alignement entre les résultats des modèles et l'entraînement des données.

Les outils de détection des dérives peuvent repérer tout écart entre les données utilisées lors des opérations d'inférence du modèle et les données d'entraînement d'origine. Des garde-fous de l'IA sont également inclus afin de protéger les entrées et sorties de votre modèle contre les informations nuisibles, comme les propos indignes et vulgaires, les données à caractère personnel ou les restrictions propres à un domaine.

Modèle de solution

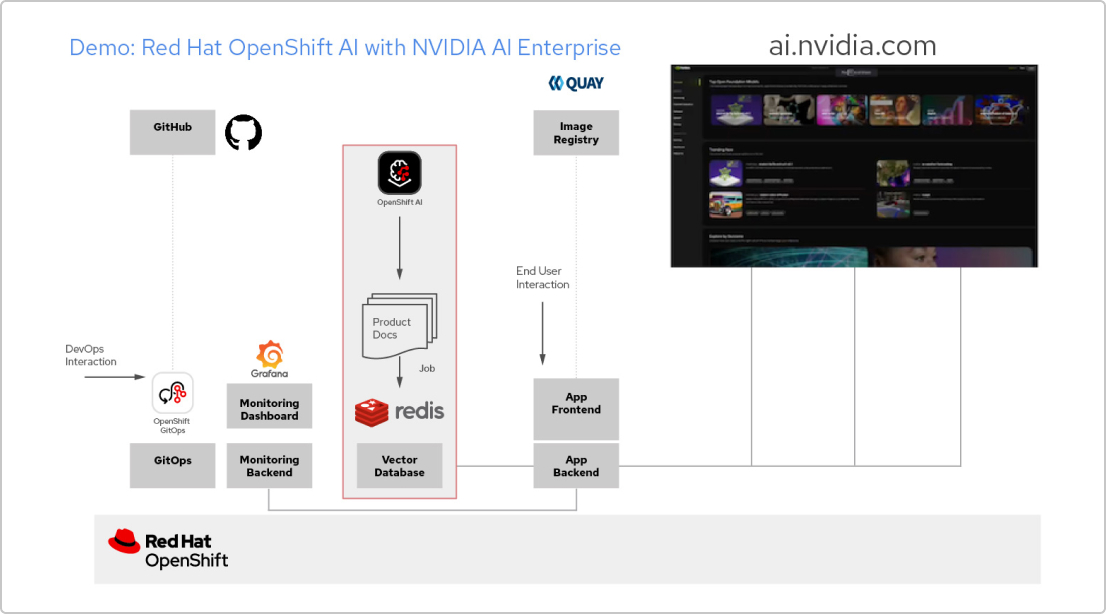

Applications d'IA avec Red Hat et NVIDIA AI Enterprise

Créer une application RAG

Red Hat OpenShift AI est une plateforme qui sert à réaliser des projets de science des données et à servir des applications basées sur l'IA. Vous pouvez intégrer tous les outils dont vous avez besoin pour prendre en charge la génération augmentée de récupération (RAG), un moyen d'obtenir des réponses d'une IA basées sur vos propres documents de référence. L'association d'OpenShift AI à NVIDIA AI Enterprise vous permet d'utiliser des grands modèles de langage (LLM) afin de trouver le modèle optimal pour votre application.

Concevoir un pipeline pour les documents

Pour tirer parti de la RAG, vous devez, dans un premier temps, ajouter vos documents dans une base de données vectorielle. Dans notre exemple d'application, nous intégrons un ensemble de documents relatifs à des produits dans une base de données Redis. Puisque ces documents changent fréquemment, nous avons créé un pipeline pour ce processus que nous exécuterons régulièrement afin de nous assurer que l'IA dispose toujours des dernières versions des documents.

Parcourir le catalogue de LLM

NVIDIA AI Enterprise vous donne accès à un catalogue varié de LLM. Vous pouvez ainsi tester plusieurs modèles et sélectionner celui qui vous offre les meilleurs résultats. Les modèles sont hébergés dans le catalogue d'API de NVIDIA. Une fois que vous avez configuré un token API, vous pouvez déployer un modèle directement à partir d'OpenShift AI, en utilisant la plateforme de service de modèles NVIDIA NIM.

Choisir le modèle le plus adapté

Lorsque vous testez différents LLM, vos utilisateurs peuvent noter chaque réponse générée. Vous avez la possibilité de configurer un tableau de bord de surveillance Grafana pour comparer les notes ainsi que la latence et le temps de réponse pour chaque modèle. Ensuite, vous pouvez utiliser ces données pour choisir le meilleur LLM à utiliser en production.

Essayez Red Hat OpenShift AI

Sandbox de développement

Pour les équipes de développement et de science des données qui souhaitent expérimenter la création d'applications basées sur l'IA dans un environnement préconfiguré et flexible.

Essai de 60 jours

Pour les équipes qui sont prêtes à évaluer toutes les capacités d'OpenShift AI. Un cluster Red Hat OpenShift existant est nécessaire.