Une plateforme ouverte pour les modèles d'IA dans le cloud hybride

Passez aux applications intelligentes et à l'IA générative

Les technologies d'intelligence artificielle (IA), d'apprentissage automatique (AA) et d'apprentissage profond influent de façon considérable sur la stratégie de modernisation des applications dans une grande variété de secteurs d'activité et d'entreprises. La nécessité d'innover et d'exploiter les données pour obtenir une valeur stratégique et de nouvelles informations favorise la hausse de l'utilisation des applications cloud-native basées sur l'IA et des méthodes MLOps. Dans le même temps, cette situation inédite peut faire émerger de nombreuses difficultés dans tous les domaines, notamment le développement, l'exploitation et la science des données. La mise en œuvre de l'IA/AA n'est pas un processus secondaire. Elle nécessite souvent de longs mois, alors que l'IA générative progresse chaque jour. Ce décalage peut faire échouer des projets et mettre les entreprises en danger en les exposant à de nombreux défis :

- Le rythme d'évolution de l'IA peut faire peur, car il implique d'utiliser des services d'applications et des outils cohérents et toujours à jour, de provisionner des ressources matérielles comme des processeurs graphiques (GPU) et de mettre à l'échelle les applications basées sur l'IA.

- Lorsqu'elles investissent dans l'IA, les entreprises doivent à la fois atténuer les risques et continuer de créer de la valeur en particulier quand elles utilisent des données sensibles pour alimenter leurs modèles et applications.

- L'utilisation de plateformes différentes pour le travail des développeurs et des data scientists freine la collaboration et le développement.

- Les applications basées sur l'IA doivent être déployées à grande échelle et à proximité des points de génération de données.

Reposant sur la plateforme d'applications Red Hat® OpenShift® pour le cloud hybride et intégrée à la gamme Red Hat AI, la solution Red Hat OpenShift AI offre aux équipes de développement et de science des données une plateforme d'IA/AA puissante pour créer et déployer des applications intelligentes. Elle permet aux entreprises d'expérimenter des modèles avec un vaste choix d'outils, de collaborer plus facilement et d'écourter le délai de mise sur le marché en utilisant une plateforme unique. Red Hat OpenShift AI associe l'environnement en libre-service dont ont besoin les data scientists et les développeurs à la fiabilité indispensable à l'équipe informatique.

La mise en place de bases solides permet de limiter les problèmes tout au long du cycle de vie. Red Hat OpenShift AI est une plateforme fiable qui donne accès à de nombreux outils certifiés et couramment utilisés, ainsi qu'à des workflows que les équipes connaissent déjà pour le déploiement des modèles en production. Grâce à tous ces avantages, les équipes peuvent collaborer de façon plus fluide et distribuer plus efficacement les applications basées sur l'IA, avec à la clé davantage de valeur pour l'entreprise.

Points clés

Réduisez les coûts, du développement à la production, grâce à la mise à l'échelle et à l'automatisation de votre infrastructure.

Améliorez l'efficacité opérationnelle de l'IA/AA grâce à une expérience utilisateur cohérente qui donne de l'autonomie aux équipes de science des données, d'ingénierie des données, de développement d'applications et DevOps.

Gagnez en flexibilité dans le cloud hybride en créant, entraînant, déployant et surveillant les charges de travail d'IA/AA sur site, dans le cloud ou à la périphérie du réseau.

Accélérez le développement, l'entraînement, les tests et le déploiement

Plateforme d'IA flexible et évolutive, la solution Red Hat OpenShift AI inclut des outils de création, de déploiement et de gestion d'applications basées sur l'IA. Conçue autour de technologies Open Source, cette solution offre aux équipes des fonctionnalités fiables et cohérentes pour faire des expériences, déployer des modèles et distribuer des applications novatrices. Sur la base de cette plateforme partagée et cohérente, les équipes peuvent accélérer la distribution des applications intelligentes en facilitant le déploiement des modèles d'AA, depuis le projet pilote jusqu'à la mise en production.

Red Hat OpenShift AI propose une interface utilisateur intégrée ainsi que des outils de création, d'entraînement, de réglage, de déploiement et de surveillance pour les modèles d'IA prédictive et générative. Vous pouvez déployer des modèles sur site ou dans tous les grands clouds publics et exécuter vos charges de travail dans l'environnement qui vous convient, sans jamais dépendre d'une solution cloud propriétaire. Red Hat OpenShift AI repose sur le projet communautaire Open Data Hub ainsi que sur d'autres projets Open Source tels que Jupyter, Pytorch, vLLM et Kubeflow.

Réduction des coûts de la mise en production

Solution complémentaire de Red Hat OpenShift, la solution OpenShift AI propose une plateforme conçue pour gérer les volumes de travail les plus exigeants. Elle permet de réduire les coûts courants liés à l'entraînement, à la distribution et l'infrastructure des projets d'IA générative et prédictive entre le développement et la production grâce à la simplification du provisionnement des ressources et à l'automatisation des tâches dans le cadre des pipelines de données. La plateforme permet aussi de limiter les coûts des opérations d'inférence des modèles grâce à l'utilisation de moteurs de distribution et d'environnements d'exécution optimisés (tels que le vLLM) ainsi qu'à la mise à l'échelle de l'infrastructure sous-jacente en fonction des exigences des charges de travail.

En plus des outils et frameworks qu'elles maîtrisent déjà, les équipes de science des données ont accès à un écosystème de solutions de partenaires technologiques toujours plus riche pour l'IA/AA, sans la contrainte d'utiliser une chaîne d'outils normative. Elles n'ont plus besoin d'envoyer une demande au service informatique et d'attendre le provisionnement des ressources requises : l'infrastructure est disponible à la demande, d'un simple clic.

Simplification de l'exploitation

Red Hat OpenShift AI offre une expérience utilisateur cohérente qui favorise la collaboration entre les équipes de science des données, d'ingénierie des données, de développement d'applications et DevOps pour proposer des solutions d'IA efficacement et dans les temps. La plateforme permet d'accéder en libre-service aux workflows collaboratifs, d'accélérer les processus grâce aux GPU et de rationaliser l'exploitation. Les entreprises peuvent proposer des solutions d'IA cohérentes à grande échelle dans tous les environnements de cloud hybride et d'edge computing.

Parce qu'OpenShift AI est une solution complémentaire de Red Hat OpenShift, les équipes d'exploitation peuvent fournir des configurations plus directes aux équipes de science des données et de développement d'applications sur la base d'une plateforme stable à l'efficacité prouvée et qui peut être mise à l'échelle facilement. La gouvernance et la sécurité ne posent plus de problème au service informatique, qui n'a pas besoin de surveiller les comptes non autorisés sur la plateforme cloud.

Hausse de la flexibilité dans le cloud hybride

Red Hat OpenShift AI offre la possibilité d'entraîner, de déployer et de surveiller les charges de travail d'IA/AA dans un environnement cloud, dans des datacenters sur site ou à la périphérie du réseau, à proximité des sites de production ou de stockage des données. Cette flexibilité permet d'adapter les stratégies d'IA, notamment avec le déplacement des processus d'exploitation vers le cloud ou la périphérie du réseau en fonction des besoins de l'entreprise. Les entreprises peuvent entraîner et déployer des modèles et des applications basées sur l'IA là où elles le souhaitent pour satisfaire les exigences en matière de réglementation, de sécurité et de données, y compris dans des environnements déconnectés ou air-gap.

Dans le cadre d'un sondage sur les domaines technologiques pour lesquels les investissements devraient augmenter en 2025, 84 % des participants ont indiqué l'IA, contre 73 % l'année précédente1.

Red Hat OpenShift AI

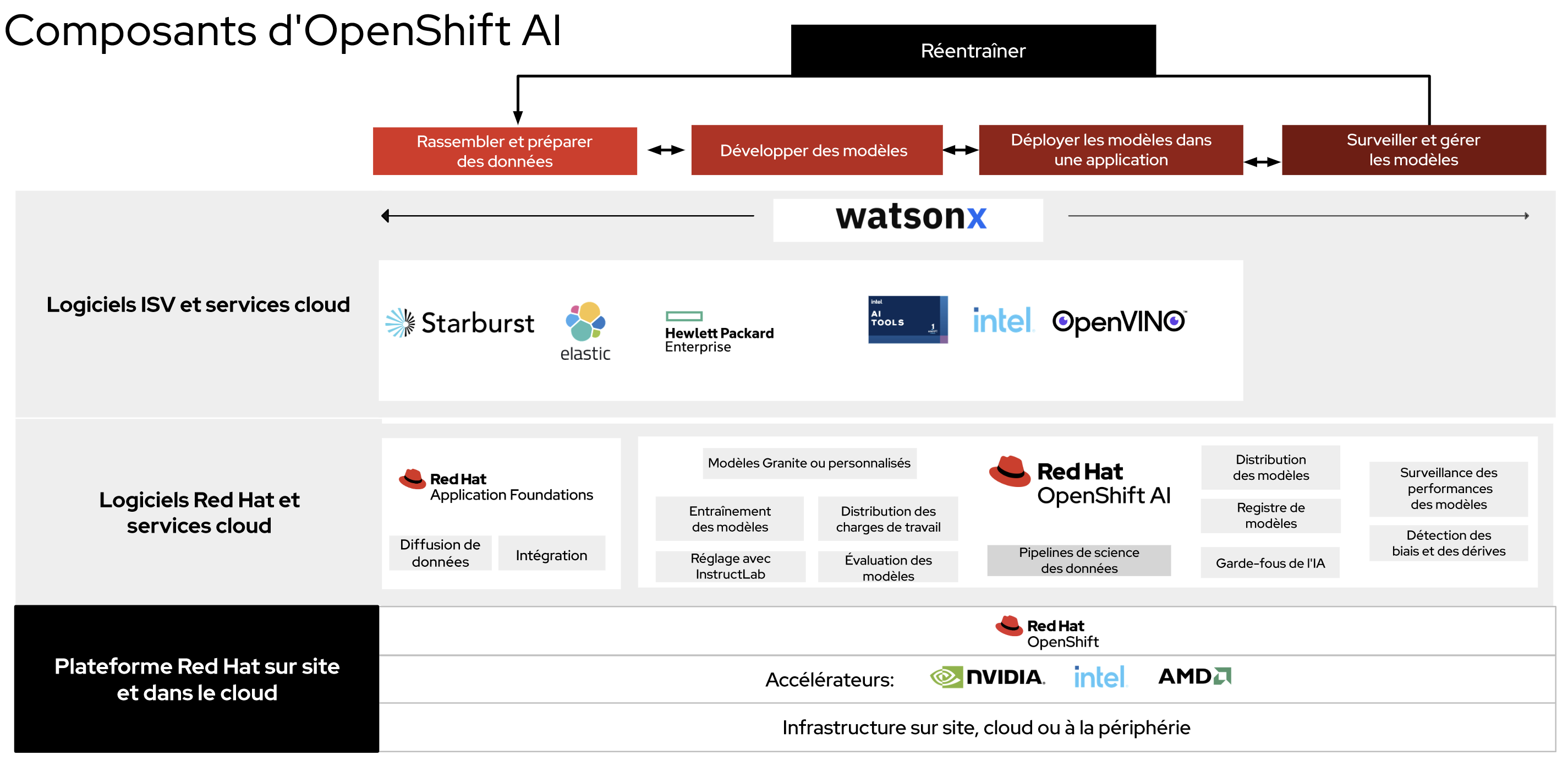

La figure 1 montre comment la solution OpenShift AI s'intègre dans le cycle de vie d'exploitation d'un modèle et comment elle complète les capacités de la plateforme d'applications Red Hat OpenShift. L'utilisation d'une plateforme de cloud hybride à l'efficacité prouvée, disponible sous forme de version autogérée avec un logiciel traditionnel ou de service cloud géré, offre aux entreprises un haut niveau de flexibilité. La version autogérée peut être déployée dans tous les environnements où Red Hat OpenShift s'exécute : sur site ou sur l'une des trois grandes plateformes de cloud public. Le service cloud géré est disponible via Red Hat OpenShift Service on AWS et Red Hat OpenShift Dedicated (sur AWS ou Google Cloud Platform).

Les capacités d'IA de nos solutions peuvent également être complétées par les logiciels d'IA et SaaS (Software-as-a-Service) que proposent nos partenaires au sein de notre vaste écosystème.Parce qu'elle est flexible et modulable, la solution Red Hat OpenShift AI offre aux entreprises la possibilité d'assembler une plateforme d'IA/AA complète qui répond à leurs besoins individuels.

Pour les entreprises qui découvrent les modèles d'IA générative, OpenShift AI inclut les composants de Red Hat® Enterprise Linux® AI, une plateforme de modèles de fondation conçue pour développer, tester et exécuter des grands modèles de langage (LLM) de la famille Granite permettant de faire fonctionner les applications d'entreprise. En plus des modèles Granite fournis, Red Hat OpenShift AI prend en charge les modèles de HuggingFace, Stability AI et d'autres référentiels de modèles.

Red Hat OpenShift AI est un composant fondamental du service IBM watsonx.ai qui fournit des outils et services d'IA essentiels pour les charges de travail d'IA générative. Watsonx propose un studio professionnel pour créer des applications d'IA générative en rédigeant peu ou pas de code. Il offre également des workflows faciles à utiliser pour le développement de modèles, ainsi qu'un accès à une bibliothèque de modèles de fondation IBM et de modèles Open Source. Red Hat OpenShift et Red Hat OpenShift AI sont des prérequis techniques intégrés pour le logiciel watsonx.

Les outils et fonctionnalités essentiels compris dans Red Hat OpenShift AI forment une base solide :

- Création et réglage de modèles : les data scientists peuvent réaliser des tests dans une interface utilisateur JupyterLab qui propose des images de notebooks sécurisées et prédéfinies avec des bibliothèques et des paquets Pythons communs, tels que TensorFlow, PyTorch et CUDA. Les entreprises peuvent également fournir leurs propres images personnalisées afin de créer des notebooks et de collaborer tout en organisant le travail dans des projets et des espaces réservés.

- Distribution de modèles : Red Hat OpenShift AI propose différents frameworks pour gérer la distribution des modèles afin de simplifier le déploiement de l'apprentissage automatique prédictif ou des modèles de fondation dans les environnements de production, indépendamment de leurs besoins en ressources de calcul. Pour les charges de travail d'IA générative, OpenShift AI fournit un framework pour les opérations d'inférence des modèles basé sur le vLLM, offrant ainsi de hautes performances et une efficacité élevée pour les grands modèles de langage Open Source les plus couramment utilisés. La solution offre également un haut niveau de flexibilité et de contrôle en permettant aux entreprises d'importer et utiliser leurs environnements d'exécution préférés.

- Pipelines de science des données : Red Hat OpenShift AI inclut un composant de pipelines de science de données. Il permet d'organiser les tâches de science des données sous forme de pipelines et de construire des pipelines à l'aide d'une interface graphique. Les entreprises peuvent combiner des processus tels que la préparation des données, la création et la distribution des modèles.

- Surveillance des modèles : Red Hat OpenShift AI aide les spécialistes de l'exploitation à surveiller les indicateurs d'exploitation et des performances des serveurs de modèles et des modèles déployés. Les data scientists peuvent visualiser les indicateurs des performances et d'exploitation dans des formats prédéfinis ou intégrer les données à d'autres services d'observabilité.

- Distribution des charges de travail : grâce à la distribution des charges de travail, les équipes peuvent accélérer le traitement des données ainsi que l'entraînement, le réglage et le déploiement des modèles. Cette fonctionnalité aide à définir les priorités et la répartition du travail ainsi qu'à utiliser les nœuds de manière optimale. Le haut niveau de compatibilité des GPU permet de gérer les exigences des charges de travail liées aux modèles de fondation.

- Détection des biais et des dérives : Red Hat OpenShift AI fournit des outils qui permettent aux data scientists d'évaluer si les modèles sont justes et objectifs en fonction des données d'entraînement et lors de leur déploiement pour un cas d'utilisation concret. Les outils de détection des dérives incluent des distributions de données saisies pour les modèles d'AA déployés. Ils repèrent tout écart significatif entre les données utilisées lors des opérations d'inférence du modèle et les données utilisées pendant l'entraînement.

- Garde-fous de l'IA (version préliminaire) : ce composant inclut des détecteurs d'entrée afin de sécuriser le type d'interactions disponibles pour les utilisateurs, ainsi que des détecteurs de sortie qui aident à vérifier les résultats du modèle. Ces garde-fous facilitent le filtrage des propos haineux, abusifs ou indignes, des données à caractère personnel, des renseignements concurrentiels et d'autres contraintes spécifiques de domaines. Les entreprises ont également la possibilité d'ajouter leurs propres garde-fous.

- Évaluation des modèles : lors de la phase d'exploration et de développement des modèles, le composant LM Evaluation (LM-Eval) fournit des informations importantes sur la qualité des modèles. Il permet aux data scientists d'analyser les performances des LLM pour différentes tâches, notamment le raisonnement logique ou mathématique et le langage naturel contradictoire. Les évaluations se basent sur les normes du secteur.

- Registre de modèles : Red Hat OpenShift AI offre un espace centralisé pour suivre et gérer les modèles enregistrés, permettant aux data scientists de partager, modifier, déployer et suivre les modèles d'IA prédictive et générative, les métadonnées et les artéfacts des modèles.

En plus des images de notebooks et du spawner de Jupyter pour déployer les images prédéfinies ou personnalisées par l'entreprise au sein de l'équipe de science des données, OpenShift AI inclut un plug-in Git pour JupyterLab qui accélère l'intégration à Git directement depuis l'interface utilisateur. D'autres outils sont également inclus dans ce composant, tels que des paquets d'analyse courants pour simplifier l'exploitation et lancer les projets plus rapidement, notamment Pandas, scikit-learn et NumPy. Les data scientists peuvent aussi choisir un autre environnement de développement intégré à la place de JupyterLab, tel que RStudio Server (testé et vérifié) ou VS Code Server. Les interfaces utilisateur du projet permettent aux data scientists de créer leur propre espace de travail pour organiser et partager leurs images de notebooks et leurs artéfacts (tels que des projets), ainsi que collaborer avec d'autres utilisateurs.

Pour les projets d'IA générative, OpenShift AI offre une fonction d'entraînement distribué avec InstructLab (version préliminaire). Composant clé de Red Hat Enterprise Linux AI, InstructLab fournit des outils d'alignement des modèles pour aider les entreprises à régler plus efficacement les modèles de langage plus petits avec leurs données privées et remédier au manque d'expérience de leurs équipes dans le domaine de l'IA. Red Hat OpenShift AI permet également un réglage fin et efficace des grands modèles de langage avec les techniques LoRa/QLoRA, pour réduire la charge de calcul et l'empreinte mémoire ainsi que faciliter l'intégration d'informations au format texte aux bases de données vectorielles nécessaires pour la RAG.

Pour distribuer des modèles d'IA prédictive et générative, il est nécessaire d'adopter une approche flexible. Red Hat OpenShift AI est compatible avec plusieurs frameworks de distribution de modèles. Les entreprises peuvent choisir l'un des serveurs d'inférence pour un ou plusieurs modèles proposés, ou utiliser leur propre serveur d'inférence. L'interface utilisateur de distribution des modèles est directement intégrée au tableau de bord de Red Hat OpenShift AI ainsi qu'à l'espace de travail des projets. Les ressources des clusters sous-jacents peuvent être mises à l'échelle en fonction des charges de travail. Pour les LLM qui nécessitent une évolutivité maximale, Red Hat OpenShift AI permet la distribution des modèles en parallèle sur plusieurs nœuds avec des environnements d'exécution vLLM offrant la possibilité de gérer plusieurs demandes en temps réel.

Outils pour le cycle de vie complet de l'IA

Red Hat OpenShift fournit aux entreprises les services et logiciels nécessaires pour l'entraînement, le déploiement et la mise en production de leurs modèles (Figure 2). En plus d'OpenShift AI, ce processus est intégré à la suite Red Hat Application Foundations, qui inclut les flux pour Apache Kafka pour la diffusion en temps réel des données et événements, Red Hat 3scale API Management pour la gestion des API et la version Red Hat d'Apache Camel pour l'intégration de données.

Le tableau de bord de Red Hat OpenShift AI centralise l'accès à l'ensemble des applications et supports de documentation pour faciliter la prise en main. Des guides de démarrage, directement disponibles via le tableau de bord, délivrent les meilleures pratiques concernant les composants et les logiciels partenaires intégrés les plus utilisés. Les data scientists peuvent ainsi se former et commencer à travailler plus vite. Les sections suivantes décrivent les outils des partenaires technologiques intégrés à Red Hat OpenShift AI. Certains de ces outils nécessitent une licence supplémentaire à obtenir auprès du partenaire concerné.

Starburst

Starburst accélère les analyses grâce à une solution simple et rapide qui permet de tirer parti des données pour améliorer le fonctionnement de l'entreprise. Disponible en tant que logiciel autogéré ou service entièrement géré, Starburst facilite l'accès aux données et fournit des informations plus complètes aux utilisateurs des données. Cette plateforme est basée sur l'outil Open Source Trino (anciennement PrestoSQL), le premier moteur SQL de traitement massivement parallèle. Cette offre conçue et gérée par les spécialistes de Trino et les créateurs de Presto permet d'interroger des ensembles de données très variés, dans tous types d'environnements, sans les déplacer.

Compatible avec les services évolutifs de calcul et de stockage dans le cloud de Red Hat OpenShift, Starburst offre des performances supérieures en matière de stabilité, de sécurité, d'efficacité et de rentabilité. Cet outil offre notamment les avantages suivants :

- Automatisation : avec Starburst et les opérateurs Red Hat OpenShift, les clusters sont capables de s'autoconfigurer, s'autorégler et s'autogérer.

- Disponibilité élevée et réduction d'échelle optimisée : l'équilibreur de charge de Red Hat OpenShift peut maintenir actifs des services comme le coordinateur Trino.

- Évolutivité élastique : Red Hat OpenShift met automatiquement à l'échelle le cluster de calcul Trino en fonction du nombre de demandes.

Les entreprises ont besoin de solutions de gestion des données qui facilitent l'ensemble du processus, des expérimentations menées individuellement aux déploiements majeurs dans l'entreprise. Grâce au logiciel de gestion des données d'apprentissage automatique HPE (anciennement Pachyderm), les data scientists peuvent créer des pipelines d'AA basés sur des données et conteneurisés. De plus, un système de gestion automatique des versions garantit la traçabilité des données. Spécialement conçu pour résoudre les problèmes concrets liés à la science des données, Pachyderm offre les bases nécessaires pour l'automatisation et la mise à l'échelle du cycle de vie de l'AA, avec une reproductibilité garantie. Le logiciel de gestion des données d'apprentissage automatique HPE convient pour de nombreux cas d'utilisation, tels que les données non structurées, les entrepôts de données, le traitement du langage naturel, les processus ETL (extraction, transformation et chargement) pour les vidéos et les images, les services financiers et les sciences de la vie. Il offre les capacités suivantes :

- Gestion automatisée des versions pour un suivi performant de toutes les modifications apportées aux données

- Pipelines conteneurisés basés sur des données qui accélèrent le traitement des données et réduisent les coûts de calcul

- Processus de traçabilité des données immuable permettant l'enregistrement fixe de toutes les activités et ressources du cycle d'AA

- Console avec une interface intuitive de visualisation des graphes orientés acycliques qui simplifie le débogage et assure la reproductibilité

- Prise en charge des notebooks Jupyter via le module JupyterLab Mount Extension qui permet d'accéder en quelques clics aux versions de données.

- Outils robustes pour le déploiement et l'administration du logiciel de gestion des données d'apprentissage automatique HPE au sein de différentes équipes dans l'entreprise

Les plateformes matérielles et logicielles de calcul accéléré NVIDIA révolutionnent le calcul

Parce que les applications d'IA/AA jouent un rôle de plus en plus important dans leur réussite, les entreprises ont besoin de plateformes qui peuvent gérer des charges de travail complexes, optimiser l'utilisation du matériel et garantir une bonne évolutivité. Le traitement évolutif des données, l'analyse des données, l'entraînement des modèles d'apprentissage automatique et l'inférence sont des tâches de calcul qui consomment énormément de ressources et pour lesquelles le calcul accéléré est adapté.Le logiciel NVIDIA AI Enterprise rationalise le déploiement et la mise en œuvre de solutions d'IA prêtes pour la production. Composant de NVIDIA AI Enterprise, NVDIA NIM rassemble des microservices faciles à utiliser, pour un déploiement sûr et fiable des opérations d'inférence des modèles d'IA hautes performances. Cette solution améliore la gestion et les performances des modèles d'IA dans l'environnement Red Hat OpenShift, en permettant aux applications intelligentes d'exploiter tout le potentiel de la plateforme de calcul accéléré NVIDIA et du logiciel NVIDIA AI Enterprise. L'utilisation de la plateforme de calcul accéléré NVIDIA, du logiciel NVIDIA AI Enterprise et de Red Hat OpenShift AI permet d'améliorer l'allocation des ressources, l'efficacité et la vitesse d'exécution des charges de travail d'IA.

Kit d'outils OpenVINO d'Intel

La distribution Intel du kit d'outils OpenVINO accélère le développement et le déploiement des applications d'inférence d'apprentissage profond hautes performances sur les plateformes Intel. Ce kit d'outils permet de choisir, d'optimiser et de régler presque tous les modèles de réseaux de neurones ainsi que d'exécuter des opérations d'inférence d'IA complètes grâce à l'écosystème OpenVINO d'outils de développement.

- Modélisation : les équipes de développement peuvent utiliser leurs propres modèles d'apprentissage profond. Pour une mise sur le marché plus rapide, elles peuvent également utiliser des modèles préentraînés et préoptimisés, disponibles dans le kit d'outils OpenVINO de Hugging Face et Intel.

- Optimisation : le kit d'outils OpenVINO propose plusieurs manières de convertir des modèles pour plus de facilité et d'efficacité, permettant aux équipes de développement d'exécuter des modèles d'IA plus rapidement et efficacement. Les modèles aux formats TensorFlow, TensorFlow Lite, ONNX ou PaddlePaddle n'ont pas besoin d'être convertis et peuvent directement être utilisés pour l'inférence. La conversion au format OpenVINO IR permet d'obtenir des performances optimales, avec un temps d'exécution réduit pour la première inférence et une économie d'espace de stockage. Le framework NNCF (Neural Network Compression Framework) apporte d'autres améliorations.

- Déploiement : l'API OpenVINO Runtime Inference Engine est conçue pour être intégrée aux applications afin d'accélérer le processus d'inférence. Elle suit une approche de type « coder une fois, déployer partout » qui permet d'exécuter efficacement les tâches d'inférence sur du matériel Intel varié, notamment des processeurs, des GPU et des accélérateurs.

AI Tools d'Intel®

Avec le kit AI Tools d'Intel (précédemment Intel AI Analytics Toolkit), les data scientists, les développeurs d'IA et les chercheurs disposent des outils et frameworks Python qu'ils maîtrisent pour accélérer de bout en bout les pipelines d'analyse et de science des données sur les architectures Intel. Les composants utilisent les bibliothèques oneAPI d'Intel pour l'optimisation des calculs de base. Ce kit maximise les performances, du prétraitement jusqu'à l'AA, et offre une interopérabilité élevée pour un développement efficace des modèles.

Le kit AI Tools d'Intel offre les possibilités suivantes :

- Réaliser des entraînements d'apprentissage profond hautes performances sur les XPU Intel et intégrer une inférence rapide au workflow de développement d'IA grâce aux frameworks optimisés pour TensorFlow et PyTorch, y compris les modèles préentraînés et les outils de faible précision

- Obtenir une accélération immédiate des workflows de prétraitement des données et d'AA grâce aux paquets Python demandant une grande puissance de calcul, à Modin, à scikit-learn et à XGBoost, optimisés pour Intel

- Accéder directement aux analyses et aux fonctions d'optimisation de l'IA d'Intel qui garantissent l'interopérabilité continue des logiciels

Elastic

La solution Elastic Search AI Platform (basée sur ELK Stack) associe la précision de la recherche et l'intelligence de l'IA pour permettre aux utilisateurs de prototyper et d'intégrer plus rapidement des LLM, ainsi que d'utiliser l'IA générative pour créer des applications évolutives et rentables. Grâce à cette solution, les utilisateurs peuvent créer des applications de RAG (génération augmentée de récupération) novatrices, résoudre proactivement des problèmes d'observabilité et éliminer les menaces complexes de sécurité. Le moteur Elasticsearch peut être déployé dans les environnements où se trouvent les applications : sur site, sur une plateforme de cloud public ou même dans un environnement air-gap.

Elastic s'intègre aux modèles de l'écosystème, tels que Red Hat OpenShift AI, Hugging Face, Cohere et OpenAI, via un simple appel d'API. Cette approche garantit un code propre pour gérer l'inférence hybride des charges de travail de RAG, avec les fonctions suivantes :

- Découpage, connecteurs et indexeurs pour ingérer différents ensembles de données dans la couche de recherche

- Recherche sémantique avec Elastic Learned Sparse EncodeR (ELSER), le modèle d'AA intégré, et le modèle d'intégration E5, pour une recherche vectorielle multilingue

- Documentation et sécurité sur le terrain, avec mise en œuvre des autorisations et des droits qui correspondent au contrôle d'accès basé sur les rôles de l'entreprise

Avec la solution Elastic Search AI Platform, vous entrez dans une communauté internationale de développeurs qui aiment chercher des solutions et apporter leur aide. Retrouvez la communauté Elastic sur Slack, sur nos réseaux sociaux ou dans nos forums de discussion.

Conclusion

Grâce à Red Hat OpenShift AI, les entreprises peuvent expérimenter des modèles plus facilement, collaborer davantage et, en fin de compte, accélérer le déploiement de leurs applications basées sur l'IA. Disponible sous forme de service cloud complémentaire géré par Red Hat ou de logiciel autogéré, Red Hat OpenShift AI offre davantage de flexibilité aux data scientists qui peuvent créer leurs modèles dans tout environnement en toute simplicité. Les équipes d'exploitation informatique profitent des capacités MLOps qui permettent de déployer les modèles plus rapidement en production. Grâce à l'accès en libre-service, notamment aux GPU, les équipes de développement et de science des données peuvent innover sur une plateforme d'applications que le service informatique utilise déjà en toute confiance. Contrairement à d'autres approches, les data scientists ont ici la possibilité d'utiliser la chaîne d'outils de leur choix et d'exploiter les données sans aucune limite arbitraire.