Una piattaforma open per i modelli di IA nel cloud ibrido

Adotta applicazioni intelligenti e IA generativa

Oggi, tecnologie quali intelligenza artificiale (IA), machine learning (ML) e deep learning (DL) influenzano profondamente le iniziative di modernizzazione delle applicazioni in moltissimi settori e attività. Spinte dal bisogno di creare soluzioni innovative e di ricavare un valore strategico e nuove informazioni dai dati, le aziende moderne puntano su applicazioni cloud native basate sull'IA e metodologie MLOps. Queste novità tecnologiche pongono però anche numerose sfide e hanno un impatto significativo su tutti i team aziendali, dagli sviluppatori ai data scientist, fino allo staff dedicato alla gestione delle operazioni. L'implementazione dell'AI/ML è un'attività complessa e molto spesso richiede mesi mentre i progressi dell'IA generativa (IA gen) sono quotidiani. Questa discrepanza può portare al fallimento dei progetti e generare innumerevoli sfide che mettono a rischio il business:

- Tenere il passo con i progressi dell'IA non è un compito da poco. Bisogna assicurarsi di utilizzare sempre strumenti e servizi applicativi aggiornati, effettuare il provisioning delle risorse hardware come le GPU e garantire la scalabilità delle applicazioni basate sull'IA.

- Le organizzazioni devono sfruttare l'IA per ottenere valore e al contempo ridurre i rischi legati all'utilizzo di questa tecnologia, in particolare quando impiegano dati sensibili nei modelli e nelle applicazioni.

- L'utilizzo di piattaforme diverse da parte dei data scientist e degli sviluppatori di applicazioni può ostacolare la collaborazione e rallentare lo sviluppo.

- Il deployment delle applicazioni basate sull'IA deve essere scalabile e avvenire in prossimità dei luoghi in cui vengono generati i dati.

Sviluppata a partire da Red Hat® OpenShift®, una piattaforma applicativa per il cloud ibrido leader di settore e uno dei prodotti di punta del portafoglio Red Hat AI, Red Hat OpenShift AI offre a data scientist e sviluppatori un'efficace piattaforma di AI/ML per lo sviluppo e il deployment di applicazioni intelligenti. Adottando un'unica piattaforma condivisa, le aziende possono sperimentare nuovi strumenti, migliorare la collaborazione e accelerare i tempi di rilascio. Red Hat OpenShift AI offre un approccio self service ideale per snellire il lavoro di data scientist e sviluppatori e livelli di sicurezza in linea con le esigenze degli ambienti IT di livello enterprise.

Disporre di una base affidabile assicura un'esperienza lineare durante tutto il ciclo di vita. Red Hat OpenShift AI offre una piattaforma consolidata, un ampio ecosistema di strumenti certificati e flussi di lavoro già noti ai team per il deployment dei modelli in produzione. La piattaforma favorisce la collaborazione e semplifica il rilascio di applicazioni basate sull'IA, con un conseguente aumento del valore per le organizzazioni.

Vantaggi principali

La scalabilità e l'automazione dell'infrastruttura permettono di ridurre i costi legati al passaggio dalla fase di sperimentazione a quella di produzione.

Maggiore efficienza operativa dell'AI/ML grazie a un'esperienza utente omogenea che semplifica la collaborazione tra data scientist, data engineer, sviluppatori di applicazioni e team DevOps.

Maggiore flessibilità perché la piattaforma permette di creare, addestrare, distribuire e monitorare i carichi di lavoro dell'AI/ML on premise, nel cloud e all'edge.

Accelera sviluppo, addestramento, test e deployment

Red Hat OpenShift AI è una piattaforma di IA flessibile e scalabile che fornisce tutti gli strumenti per creare, distribuire e gestire le applicazioni basate sull'IA. Sviluppata grazie a tecnologie open source, offre ai team funzionalità affidabili e coerenti a livello operativo per mettere alla prova le proprie competenze, fornire modelli ed erogare app innovative. Red Hat OpenShift AI è una piattaforma coerente che aiuta le aziende ad accelerare il rilascio di applicazioni intelligenti perché semplifica il passaggio dai progetti pilota dei modelli di ML alle applicazioni intelligenti.

Red Hat OpenShift AI offre un'interfaccia utente integrata con strumenti per la creazione, l'addestramento, l'ottimizzazione, la distribuzione e il monitoraggio dei modelli di IA generativa e predittiva. È possibile distribuire i modelli on premise o negli ambienti cloud pubblici dei principali provider. In questo modo le aziende possono eseguire i carichi di lavoro ovunque sia necessario e non sono vincolate alle soluzioni di un singolo provider. Red Hat OpenShift AI è una soluzione basata sul progetto sviluppato dalla community Open Data Hub e altri noti progetti open source, come Jupyter, Pytorch, vLLM e Kubeflow.

Abbatti i costi della scalabilità in produzione

Componente aggiuntivo di Red Hat OpenShift, OpenShift AI è una piattaforma progettata per gestire anche i carichi di lavoro più complessi. Riduce i costi per l'infrastruttura, l'addestramento continuo e il model serving associati ai progetti di IA generativa e predittiva e semplifica il passaggio dalla fase di sperimentazione a quella di produzione grazie al provisioning rapido delle risorse e all'automazione delle attività tramite pipeline di dati. Riduce i costi legati all'inferenza dei modelli impiegando runtime e motori ottimizzati per il model serving, come vLLM, e ridimensionando l'infrastruttura alla base secondo le esigenze dei carichi di lavoro.

I data scientist possono utilizzare gli strumenti che già conoscono oppure accedere a un vasto ecosistema di partner tecnologici per approfondire le proprie competenze in materia di AI/ML, senza essere vincolati a una toolchain prescrittiva. Inoltre, possono distribuire l'infrastruttura on demand con un semplice clic e non devono più aspettare che il team IT effettui il provisioning delle risorse.

Riduci la complessità operativa

Red Hat OpenShift AI assicura un'esperienza utente coerente che semplifica la collaborazione fra data scientist, data engineer, application engineer e team DevOps e accelera il rilascio di soluzioni di IA. Offre accesso self service a flussi di lavoro collaborativi, accelerazione tramite l'accesso alle GPU e operazioni semplificate. In questo modo le organizzazioni possono distribuire le soluzioni di IA in maniera coerente e scalabile in tutto il cloud ibrido fino all'edge delle rete.

OpenShift AI è un componente aggiuntivo di Red Hat OpenShift. Questo significa che i team operativi hanno a disposizione tutte le funzionalità di una piattaforma stabile, collaudata e con rapida scalabilità e possono quindi fornire a data scientist e sviluppatori di applicazioni configurazioni semplificate. Inoltre, i team IT beneficiano di misure di governance e sicurezza efficaci e non devono più monitorare gli account non autorizzati sulla piattaforma cloud.

Migliora la flessibilità nel cloud ibrido

Red Hat OpenShift AI permette di addestrare, distribuire e monitorare i carichi di lavoro dell'AI/ML in qualunque ambiente (cloud, datacenter on premise o all'edge della rete) e in prossimità del luogo in cui vengono generati o conservati i dati. Grazie a questa flessibilità è possibile far evolvere le strategie di IA trasferendo agevolmente le operazioni nel cloud o all'edge a seconda delle esigenze aziendali. Le organizzazioni possono addestrare e distribuire i modelli e le applicazioni basate sull'IA nell'ambiente più idoneo a soddisfare i requisiti normativi, di sicurezza e relativi ai dati, compresi gli ambienti isolati e disconnessi.

Abbiamo chiesto quali aree riceveranno maggiori investimenti nel 2025 e l'84% degli intervistati ha risposto l'IA. Un incremento rispetto al 73% dello scorso anno.1

Red Hat OpenShift AI

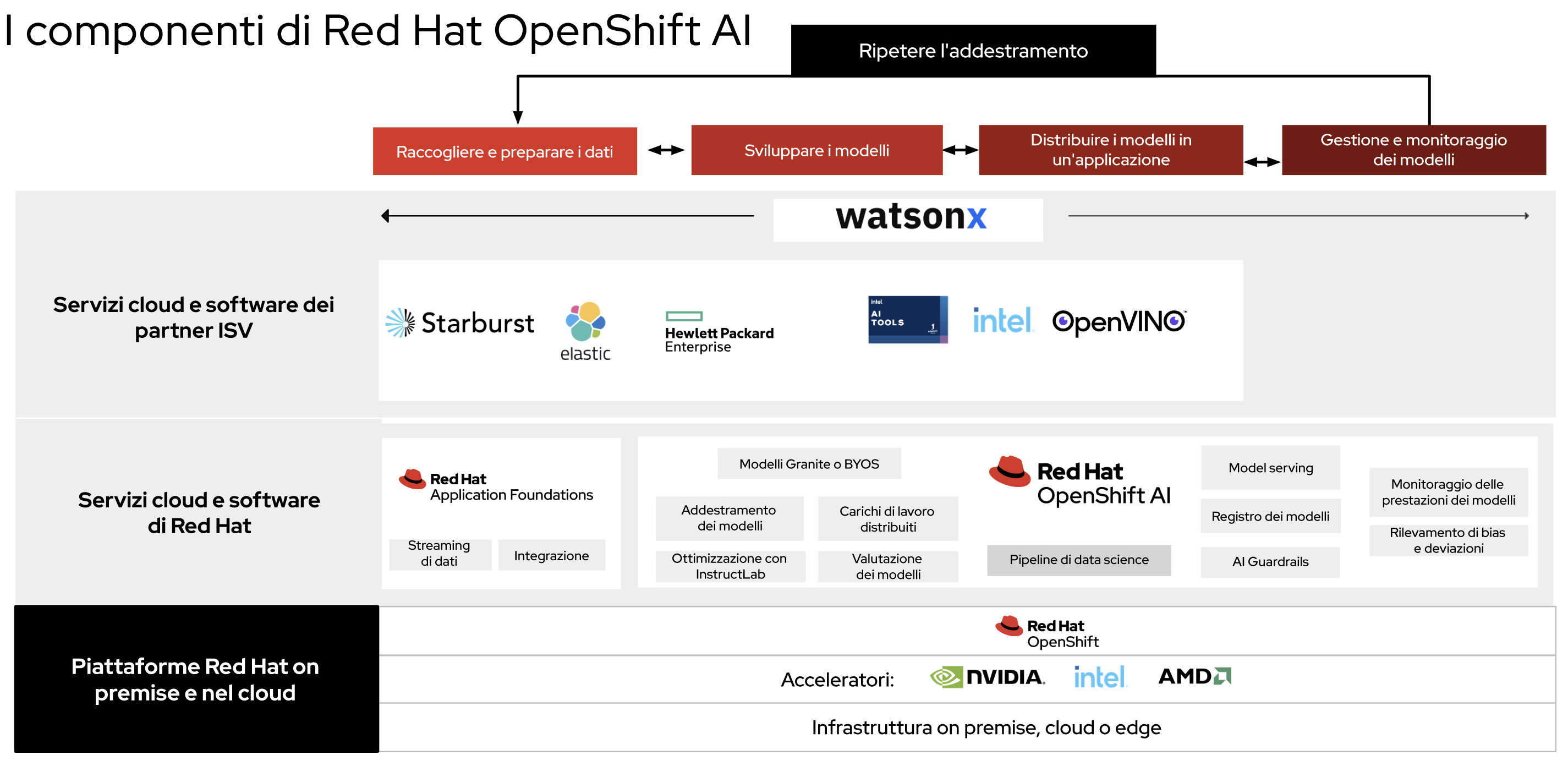

Nella Figura 1 possiamo vedere in che modo il ciclo di vita operativo dei modelli si integra in OpenShift AI che viene utilizzata come unica piattaforma per tutti i team e permette di estendere le funzionalità di Red Hat OpenShift. Le organizzazioni hanno l'occasione di lavorare su una piattaforma di cloud ibrido collaudata, che possono distribuire come software tradizionale autogestito o come servizio cloud gestito. La versione autogestita si può eseguire in tutti gli ambienti in cui si esegue Red Hat OpenShift: on premise o su uno dei tre principali cloud pubblici. Il servizio cloud gestito è disponibile con Red Hat OpenShift Service on AWS e Red Hat OpenShift Dedicated (su AWS o Google Cloud Platform).

Red Hat mette poi a disposizione un ampio ecosistema di partner che offrono soluzioni software e Software-as-a-Service (SaaS) per l'IA con cui è possibile integrare la piattaforma.Red Hat OpenShift AI è una soluzione flessibile e componibile che i clienti possono personalizzare per ottenere una piattaforma di AI/ML end to end adatta alle loro esigenze specifiche.

Per chi si sta avvicinando al mondo dell'IA gen, OpenShift AI include i componenti di Red Hat Enterprise Linux® AI, una piattaforma per modelli fondativi con cui sviluppare, testare ed eseguire i modelli linguistici di grandi dimensioni (LLM) della famiglia Granite per applicazioni aziendali. Oltre ai modelli Granite presenti in Red Hat OpenShift AI, il framework supporta anche i modelli di HuggingFace, Stability AI e altri repository.

Red Hat OpenShift AI è un componente fondamentale di IBM watsonx.ai e fornisce strumenti e servizi di IA fondamentali per i carichi di lavoro dell'IA gen. Watsonx.ai offre uno studio di livello enterprise ai compilatori di IA per la distribuzione di applicazioni di IA gen con requisiti low-code o privi di codice, flussi di lavoro di facile utilizzo per lo sviluppo dei modelli e accesso a una libreria di modelli fondativi IBM e di modelli open source selezionati. Red Hat OpenShift e Red Hat OpenShift AI sono prerequisiti tecnici integrati per il software watsonx.ai.

Red Hat OpenShift AI offre una base solida grazie a strumenti e funzionalità chiave:

- Creazione e fine tuning dei modelli. I data scientist possono condurre analisi esplorative in JupyterLab UI, che offre immagini dei notebook sicure e pronte all'uso con i pacchetti e le librerie Python più conosciute, come TensorFlow, PyTorch e CUDA. Inoltre, le organizzazioni possono inserire le proprie immagini dei notebook personalizzate, creare e collaborare sui notebook e organizzare il lavoro in progetti e ambienti di lavoro.

- Model serving. Red Hat OpenShift AI fornisce un'ampia gamma di framework per il routing del model serving. In questo modo semplifica il deployment dei modelli fondativi o dei modelli di ML predittivo negli ambienti di produzione, indipendentemente dalle risorse di elaborazione richieste. Per i carichi di lavoro dell'IA gen, OpenShift AI fornisce capacità di inferenza dei modelli basate su vLLM che assicurano prestazioni ed efficienza elevate sui più diffusi modelli linguistici di grandi dimensioni (LLM) open source. Inoltre, la piattaforma migliora flessibilità e controllo perché permette ai clienti di utilizzare i runtime che preferiscono.

- Pipeline di data science. Red Hat OpenShift AI include capacità per l'orchestrazione delle attività di data science in pipeline e per la creazione di pipeline tramite front end grafico. Le organizzazioni possono concatenare i processi come la preparazione dei dati, la creazione dei modelli e la distribuzione dei modelli in produzione.

- Monitoraggio dei modelli. Red Hat OpenShift AI permette ai team operativi di monitorare le attività e le metriche prestazionali relative ai server dei modelli e ai modelli distribuiti.I data scientist possono visualizzare in maniera agevole le metriche riguardanti prestazioni e operazioni e integrare i dati con altri servizi di osservabilità.

- Carichi di lavoro distribuiti.I carichi di lavoro distribuiti permettono di accelerare l'elaborazione dei dati, l'addestramento, il fine tuning e il model serving. Questa funzionalità consente anche di gerarchizzare e distribuire l'esecuzione dei processi e assicurare il funzionamento ottimale dei nodi. Il supporto avanzato per le GPU aiuta a gestire le esigenze dei carichi di lavoro relativi ai modelli fondativi.

- Rilevamento di bias e deviazioni. Red Hat OpenShift AI include strumenti per il monitoraggio dei modelli volti a garantire l'equità e l'imparzialità dei modelli non solo rispetto ai dati per l'addestramento ma anche nei deployment in contesti reali. Gli strumenti per il rilevamento delle deviazioni includono distribuzioni di dati di input per i modelli di ML distribuiti. In questo modo permettono di individuare il momento in cui i dati in tempo reale utilizzati per l'inferenza iniziano a discostarsi in modo significativo dai dati su cui è stato addestrato il modello.

- AI Guardrails (anteprima tecnica). Questa funzionalità include rilevatori di input per proteggere le interazioni che l'utente può richiedere e rilevatori di output per verificare la sicurezza dei risultati prodotti dal modello. AI Guardrails aiuta a eliminare linguaggio d'odio, offensivo o volgare, informazioni personali, concorrenziali o altre informazioni che deviano dai requisiti specifici del dominio. La piattaforma fornisce un set predefinito di rilevatori che i clienti possono integrare con i propri.

- Valutazione dei modelli. Durante la fase di esplorazione e sviluppo del modello, lo strumento di valutazione LM-Eval fornisce informazioni importanti sulla qualità del modello. LM-Eval consente ai data scientist di confrontare le prestazioni degli LLM nello svolgere una serie di attività, come ragionamento logico, ragionamento matematico, linguaggio naturale antagonistico, ecc. I parametri di riferimento che forniamo si basano sugli standard del settore.

- Registro dei modelli. Red Hat OpenShift AI offre uno spazio centralizzato dove visualizzare e gestire i modelli registrati. Qui i data scientist possono condividere, gestire le versioni, distribuire e tenere traccia dei modelli di IA generativa e predittiva, dei metadati e dei componenti dei modelli.

Oltre alle immagini dei notebook Jupyter e allo spawner Jupyter con cui distribuire immagini predefinite o personalizzate ai team di data science, OpenShift AI include il plugin Git per JupyterLab, il che permette di accelerare l'integrazione con Git operando direttamente dall'interfaccia utente. La piattaforma include altri validi pacchetti di analisi, come Pandas, scikit-learn e NumPy per semplificare le operazioni e l'avvio dei progetti. Include anche RStudio Server (testato e verificato) e VS Code Server che i data scientist possono utilizzare come IDE in alternativa a JupyterLab; questo per garantire sempre la massima libertà di scelta. Inoltre, l'interfaccia utente del progetto consente ai data scientist di creare i propri spazi di lavoro dove organizzare e condividere i componenti e le immagini dei notebook in forma di progetti e collaborare con gli altri utenti.

Per i progetti di IA gen, OpenShift AI introduce in anteprima l'addestramento distribuito con InstructLab. InstructLab è uno elemento chiave di Red Hat Enterprise Linux AI. Offre strumenti per l'allineamento dei modelli che aiutano le organizzazioni a ottimizzare in modo efficiente modelli linguistici più piccoli con i dati propri dell'azienda, anche se i team non dispongono di competenze specialistiche in materia di IA. Red Hat OpenShift AI supporta anche il fine tuning efficiente degli LLM grazie a tecniche quali LoRa/QLoRA al fine di ridurre il sovraccarico computazionale e l'ingombro di memoria. Supporta inoltre gli embedding per l'integrazione agevole delle informazioni di testo nei database vettoriali necessari per la RAG.

Per distribuire sia modelli di IA gen che modelli di IA predittiva occorre adottare un approccio flessibile al model serving. Red Hat OpenShift AI supporta diversi framework di model serving e permette di scegliere i server di inferenza a modello singolo o multimodello predefiniti oppure di utilizzare il proprio server di inferenza personalizzato. L'interfaccia utente per il model serving è direttamente integrata nella dashboard di Red Hat OpenShift AI e nello spazio di lavoro dei progetti. La piattaforma garantisce anche la scalabilità rapida delle risorse del cluster alla base, che si possono aumentare o diminuire secondo le esigenze dei carichi di lavoro. Per gli LLM che necessitano di elevata scalabilità, Red Hat OpenShift AI offre il model serving parallelo su più nodi con runtime vLLM e permette così di gestire più richieste in tempo reale.

Strumenti per l'intero ciclo di vita dell'IA

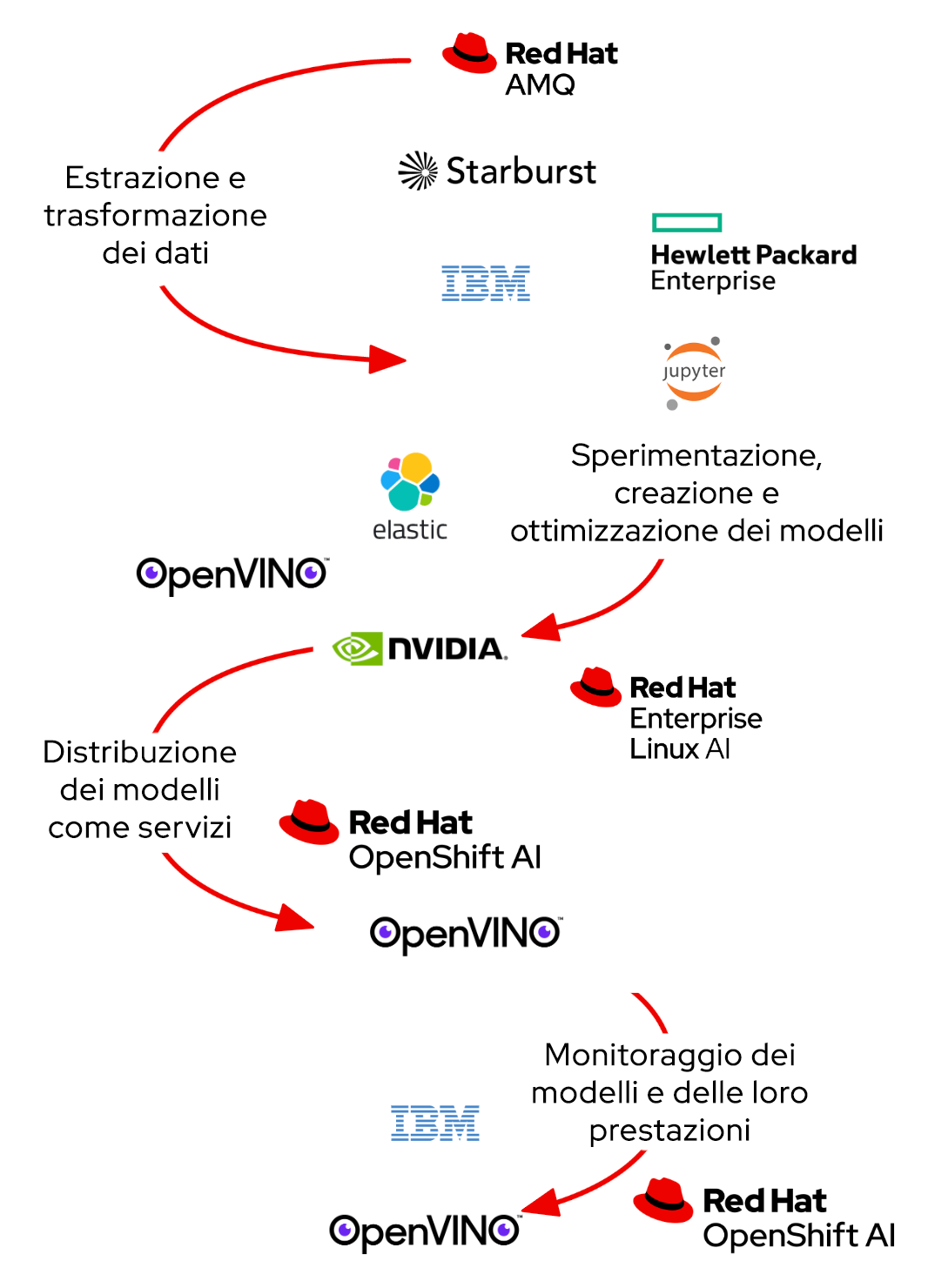

Red Hat OpenShift fornisce tutti i servizi e i software necessari per l'addestramento e il deployment dei modelli e il loro trasferimento alla fase di produzione (Figura 2). Oltre a OpenShift AI, il processo integra anche Red Hat Application Foundations, che include Streams for Apache Kafka per lo streaming di dati ed eventi in tempo reale, Red Hat 3scale API Management e la versione Red Hat di Apache Camel per l'integrazione dei dati.

La dashboard di Red Hat OpenShift AI facilita l'implementazione e consente di scoprire tutte le applicazioni e la documentazione e di accedervi da un'unica posizione. I tutorial Smart Start suggeriscono le procedure consigliate per i componenti e i principali software dei partner integrati nella piattaforma. È possibile accedervi direttamente dalla dashboard affinché i data scientist possano trovare agevolmente il supporto di cui hanno bisogno durante le fasi iniziali. Le sezioni seguenti descrivono gli strumenti dei partner tecnologici integrati in Red Hat OpenShift AI. Per utilizzare alcuni di questi strumenti occorre acquistare una licenza aggiuntiva tramite i canali del partner tecnologico.

Starburst

Starburst accelera le attività di analisi perché consente ai team di utilizzare i dati in modo rapido e veloce per migliorare le operazioni aziendali. Fornito come prodotto autogestito o servizio completamente gestito, permette di estendere l'accesso ai dati e di fornire dati più completi agli utenti. Starburst è sviluppato a partire da Trino (noto in precedenza come PrestoSQL), un motore SQL open source per l'elaborazione a elevato parallelismo (MPP). Realizzato e gestito dagli esperti Trino e dai creatori di Presto, consente di interrogare diversi set di dati a prescindere dalla loro posizione, senza doverli spostare.

Starburst si integra con i servizi di elaborazione e storage su cloud ad elevata scalabilità forniti da Red Hat OpenShift e consente di interrogare tutti i dati aziendali in modo più affidabile, sicuro, efficiente e conveniente. I vantaggi includono:

- Automazione. Gli operatori Starburst e Red Hat OpenShift consentono di automatizzare la configurazione, l'ottimizzazione e la gestione dei cluster.

- Alta disponibilità e ridimensionamento semplice. Lo strumento di bilanciamento del carico di Red Hat OpenShift garantisce la disponibilità continua dei servizi, come il coordinatore Trino.

- Scalabilità flessibile. Red Hat OpenShift può ridimensionare automaticamente i cluster di lavoro Trino in base al carico di query.

Le imprese hanno bisogno di soluzioni di gestione dei dati capaci di semplificare tutte le attività, dagli esperimenti individuali ai deployment aziendali di importanza critica. HPE Machine Learning Data Management Software (noto in precedenza come Pachyderm) consente ai team di data science di creare pipeline di ML containerizzate, basate sui dati e scalabili, con un data lineage garantito dal versioning automatico dei dati. Progettata per risolvere problemi di data science reali, questa soluzione fornisce le risorse necessarie per automatizzare il ciclo di vita del machine learning e al contempo garantire scalabilità e riproducibilità. Gli scenari di utilizzo includono dati non strutturati, data warehouse, elaborazione del linguaggio naturale, estrazione, trasformazione e caricamento di video e immagini, servizi finanziari e bioscienze. HPE Machine Learning Data Management Software offre:

- Versioning automatico dei dati che consente il monitoraggio efficace di tutte le modifiche ai dati.

- Pipeline containerizzate e basate sui dati che accelerano l'elaborazione dei dati e riducono i costi.

- Data lineage immutabile che fornisce un registro fisso di tutte le attività e le risorse del ciclo di vita del machine learning.

- Una console che offre una visualizzazione intuitiva del grafo aciclico diretto (DAG) e un supporto per il debug e la riproducibilità.

- Supporto per i notebook Jupyter grazie a JupyterLab Mount Extension. L'estensione offre un'interfaccia intuitiva con cui accedere alle versioni dei dati.

- Strumenti affidabili per la gestione e il deployment scalabile di HPE Machine Learning Data Management Software nei diversi team aziendali.

Le piattaforme hardware e software per il computing accelerato di NVIDIA segnano un svolta epocale per l'elaborazione

Oggi che le applicazioni di AI/ML hanno un ruolo decisivo per il successo aziendale, le organizzazioni necessitano di piattaforme in grado di gestire carichi di lavoro complessi, ottimizzare l'utilizzo delle risorse hardware e garantire la scalabilità. Le attività computazionali a elevato utilizzo di risorse che possono trarre giovamento dal computing accelerato sono l'inferenza, l'addestramento dei modelli di ML, l'analisi dei dati e la loro elaborazione scalabile.NVIDIA AI Enterprise agevola lo sviluppo e il deployment di soluzioni di IA pronte per la produzione. Il software comprende NVIDIA NIM, un set di microservizi di facile utilizzo progettati per semplificare le attività di inferenza ad alte prestazioni dei modelli di IA. NVIDIA NIM migliora la gestione e le prestazioni dei modelli di IA nell'ambiente Red Hat OpenShift perché consente alle applicazioni di IA di sfruttare a pieno le funzionalità di computing accelerato di NVIDIA AI Enterprise. Insieme, il computing accelerato di NVIDIA, NVIDIA AI Enterprise e Red Hat OpenShift AI permettono di ottimizzare l'allocazione delle risorse, migliorano l'efficienza e accelerano l'esecuzione dei carichi di lavoro dell'IA.

Toolkit OpenVINO di Intel

La distribuzione Intel del toolkit OpenVINO accelera lo sviluppo e il deployment delle applicazioni di inferenza per il DL ad alte prestazioni sulle piattaforme Intel. Il toolkit consente di adottare, ottimizzare e eseguire il fine tuning su pressoché qualunque modello di rete neurale ed eseguire attività di inferenza complete utilizzando l'ecosistema di strumenti di sviluppo OpenVINO.

- Modello. Gli sviluppatori di software possono utilizzare i propri modelli di DL. Per accelerare i tempi di rilascio, possono anche servirsi dei modelli preaddestrati e preottimizzati presenti nel toolkit OpenVINO grazie alla collaborazione tra Intel e Hugging Face.

- Ottimizzazione.Il toolkit OpenVINO offre diverse modalità per convertire i modelli e aiutare gli sviluppatori di software a ottenere modelli di IA più veloci ed efficienti. Gli sviluppatori possono comunque saltare la conversione dei modelli ed eseguire l'inferenza direttamente nei formati TensorFlow, TensorFlow Lite, ONNX o PaddlePaddle. La conversione in OpenVINO IR garantisce però prestazioni ottimali, riduce i tempi per l'esecuzione della prima inferenza e richiede meno spazio di archiviazione. Il Neural Network Compression Framework può portare ulteriori vantaggi.

- Deployment. OpenVINO Runtime Inference Engine è un'API progettata per essere integrata nelle applicazioni e accelerare i processi di inferenza. Il suo approccio "scrivi un volta, distribuisci ovunque" consente di eseguire in modo efficiente attività di inferenza sui diversi hardware Intel, tra cui le CPU, le GPU e gli acceleratori.

Intel® AI Tools

Intel AI Tools (noto in precedenza come Intel AI Analytics Toolkit) offre a data scientist, sviluppatori di IA e ricercatori gli strumenti e i framework Python che già conoscono al fine di accelerare le attività di data science end to end e le pipeline per l'analisi delle architetture Intel. I componenti utilizzano le librerie oneAPI per l'ottimizzazione dei calcoli di base. Il toolkit massimizza le prestazioni dalla fase di pre-elaborazione al machine learning, migliora l'interoperabilità e assicura processi di sviluppo dei modelli più efficienti.

Intel AI Tools permette di:

- Eseguire l'addestramento del DL ad alte prestazioni sulle XPU Intel e integrare l'inferenza rapida nei flussi di lavoro dello sviluppo dell'IA grazie a framework di DL ottimizzati da Intel per TensorFlow e PyTorch, compresi modelli preaddestrati e strumenti a bassa precisione.

- Ottenere l'accelerazione immediata delle pre-elaborazione dei dati e dei flussi di lavoro di ML grazie a pacchetti Python a utilizzo intensivo di risorse di calcolo, Modin, scikit-learn e XGBoost ottimizzati per Intel.

- Ottenere l'accesso diretto agli strumenti di analisi e ottimizzazione dell'IA offerti da Intel per garantire il funzionamento dei software in contemporanea e senza interruzioni.

Elastic

Elastic Search AI Platform (sviluppata a partire da ELK Stack) combina la precisione della ricerca e l'intelligenza dell'IA per consentire agli utenti di creare prototipi e integrarli negli LLM più velocemente e di utilizzare l'IA gen per la creazione a costi ridotti di applicazioni scalabili. Elastic Search AI Platform permette di creare applicazioni RAG, di risolvere in modo proattivo i problemi di osservabilità e di affrontare anche le più complesse minacce alla sicurezza. Inoltre, si può distribuire in qualunque ambiente: on premise, nel cloud e in ambienti isolati.

Elastic si integra con i modelli di embedding dell'ecosistema, che comprende Red Hat OpenShift AI, Hugging Face, Cohere, OpenAI, tramite un'unica chiamata API intuitiva. Questo approccio permette di ottenere un codice adatto alla gestione dell'inferenza ibrida dei carichi di lavoro RAG, con funzionalità che includono:

- Suddivisione, connettori e web crawler per l'inserimento di diversi set di dati nel livello di ricerca.

- Ricerca semantica grazie a Elastic Learned Sparse EncodeR (ELSER), il modello di ML integrato, e il modello di embedding E5 al fine di permettere la ricerca vettoriale multilingue.

- Sicurezza a livello di documento e ambito grazie ad autorizzazioni in linea con i criteri di controllo degli accessi basato sui ruoli dell'organizzazione.

Chi adotta Elastic Search AI Platform entra a far parte di una community mondiale di sviluppatori esperti con offrono ispirazione e supporto. Scopri la community Elastic su Slack, i forum di discussione e gli account social.

Conclusioni

Con Red Hat OpenShift AI, le imprese possono sperimentare, collaborare e accelerare il percorso verso lo sviluppo di applicazioni basate sull'IA. Red Hat offre ai data scientist la massima flessibilità proponendo Red Hat OpenShift AI come servizio aggiuntivo basato sul cloud e gestito da Red Hat oppure come offerta software autogestita. I team operativi possono beneficiare delle funzionalità MLOps e distribuire così i modelli in produzione più agevolmente. Inoltre, l'approccio self service, compreso l'accesso alle GPU, e l'utilizzo di una piattaforma applicativa leader di settore che i team già conoscono aiuta ad accelerare l'innovazione. E, a differenza di quanto avviene con altre soluzioni, i data scientist possono scegliere i propri strumenti senza toolchain restrittive e ricavare nuove informazioni dai dati senza l'applicazione di limiti arbitrari.