-

Soluções e documentação Red Hat AI

Uma plataforma de soluções e serviços para desenvolvimento e implantação da IA na nuvem híbrida.

Red Hat AI Inference Server

Otimize o desempenho de modelo com vLLM para uma inferência em escala rápida e com bom custo-benefício.

Red Hat Enterprise Linux AI

Desenvolva, teste e execute modelos de IA generativa para impulsionar as soluções empresariais.

- Documentação do

- Teste

- Como adquirir

Red Hat OpenShift AI

Crie e implante aplicações com IA e modelos em escala em ambientes híbridos.

- Documentação do

- Testar

-

Treinamento Conceitos básicos

-

Parceiros de IA

Red Hat OpenShift AI

O Red Hat® OpenShift® AI é uma plataforma para gerenciar o ciclo de vida de modelos de IA generativa (gen IA) e preditiva em escala, em ambientes de nuvem híbrida.

O que é o Red Hat OpenShift AI?

Desenvolvido com tecnologias open source, o OpenShift AI oferece recursos confiáveis e operacionalmente consistentes para capacitar as equipes a experimentar, disponibilizar modelos e entregar aplicações inovadoras.

O OpenShift AI viabiliza a preparação e a aquisição de dados, além do treinamento, ajuste fino, disponibilização e monitoramento dos modelos. Ele também facilita a aceleração de hardware. Com um ecossistema aberto de parceiros de software e hardware, o OpenShift AI oferece a flexibilidade necessária para atender aos seus casos de uso específicos.

Acelere a entrega de aplicações de IA

Combine os recursos testados do Red Hat OpenShift AI e do Red Hat OpenShift em uma plataforma de aplicações de IA empresarial que estimula a colaboração entre equipes. Cientistas de dados, engenheiros e desenvolvedores de aplicações podem colaborar em um único ambiente com consistência, segurança e escalabilidade.

O último release do OpenShift AI inclui uma coleção selecionada de modelos de terceiros otimizados e prontos para produção. Todos compatíveis com o Red Hat OpenShift AI. Com o acesso a esse catálogo de modelos de terceiros, sua equipe tem mais controle sobre a acessibilidade e visibilidade do modelo, ajudando a atender aos requisitos de política e segurança.

Além disso, o OpenShift AI ajuda a gerenciar os custos de inferência com a disponibilização distribuída de modelos por meio de um framework de vLLM otimizado. E para reduzir ainda mais a complexidade operacional, ele oferece ferramentas avançadas para automatizar as implantações e acesso self-service a modelos, ferramentas e recursos.

Funcionalidades e benefícios

Economize tempo gerenciando a infraestrutura de IA

Disponibilize acesso sob demanda aos recursos, para que as equipes possam escalar o treinamento de modelos e a disponibilização de ambientes por self-service, conforme a necessidade. Reduza também a complexidade operacional gerenciando aceleradores de IA (GPUs) e recursos de cargas de trabalho em um ambiente clusterizado escalável.

Ferramentas de IA e machine learning testadas

A Red Hat testa, integra e oferece suporte às ferramentas de IA/machine learning e model serving, liberando sua equipe dessa responsabilidade. O OpenShift AI é resultado de anos de desenvolvimento no projeto Open Data Hub e de projetos open source como o Kubeflow.

Com nossa experiência e expertise em open source, oferecemos uma base pronta para a IA generativa. Assim, os clientes têm mais opções e confiança em suas estratégias de gen IA.

Flexibilidade em toda a nuvem híbrida

Oferecido como software autogerenciado ou como um serviço de nuvem totalmente gerenciado sobre o OpenShift, o Red Hat OpenShift AI fornece uma plataforma segura e flexível que lhe dá a opção de escolher onde desenvolver e implantar seus modelos: no local, na nuvem pública ou até mesmo na borda.

Utilize nossas práticas recomendadas

O Red Hat Services oferece expertise, treinamento e suporte, que ajudam você a superar os desafios da IA, não importa o momento em que você está na sua jornada de adoção da tecnologia.

Se você gostaria de fazer o protótipo de uma solução de IA, simplificar a implantação da sua plataforma de IA ou aprimorar suas estratégias de MLOps, a Red Hat Consulting ajuda você nisso com suporte e mentoria.

Otimize com vLLM para uma inferência em escala rápida e com bom custo-benefício.

O Red Hat AI Inference Server é parte da plataforma Red Hat AI. Ele está disponível como solução independente e vem incluso no Red Hat Enterprise Linux® AI e no Red Hat OpenShift® AI.

Parcerias

Amplie os benefícios da plataforma Red Hat OpenShift AI com outros serviços e soluções integradas.

A NVIDIA e a Red Hat oferecem aos clientes uma plataforma escalável que impulsiona diversos casos de uso de IA com flexibilidade incomparável.

A Intel® e a Red Hat ajudam as organizações a estimular a adoção da IA e a operacionalizar os modelos de inteligência artificial e machine learning.

A IBM e a Red Hat oferecem inovação open source para acelerar o desenvolvimento de IA, inclusive utilizando o IBM watsonx.aiTM, um estúdio de IA empresarial para desenvolvedores.

Starburst Enterprise e Red Hat viabilizam insights mais ágeis e precisos por meio da análise rápida dos dados em diversas plataformas de dados distribuídas e desconectadas.

Aproveite a IA com a Red Hat

Conheça o portfólio exclusivo de soluções de inteligência artificial da Red Hat. Expertise, treinamento e suporte em todos os estágios da jornada de IA.

Colaboração por meio de workbenches de modelos

Disponibilize imagens de cluster prontas e personalizadas para seus cientistas de dados trabalharem com modelos usando a IDE que preferirem, como o JupyterLab. O Red Hat OpenShift AI monitora as alterações no Jupyter, no TensorFlow, no PyTorch e em outras tecnologias de IA open source.

Disponibilize modelos em escala com o Red Hat OpenShift AI

É possível disponibilizar modelos por meio de uma versão otimizada do vLLM (ou qualquer outro servidor de sua escolha) para fazer integrações em aplicações com tecnologia de IA on-premise, na nuvem pública ou na edge. Eles podem ser recriados, reimplantados e monitorados com base nas alterações feitas no notebook de origem.

Vieses e desvios podem comprometer a integridade dos seus modelos e dificultar ainda mais a escalabilidade. Para ajudar a manter a imparcialidade, segurança e escalabilidade, o OpenShift AI permite que os profissionais de dados monitorem o alinhamento entre os resultados do modelo e os dados de treinamento.

As ferramentas de detecção de desvios podem monitorar quando os dados usados para inferência de modelos se desviam dos dados de treinamento original. As medidas de segurança de IA também estão inclusas para proteger suas entradas e saídas de modelo contra informações nocivas, como discurso abusivo e de ódio, dados pessoais ou restrições de domínio específicas.

Padrão da solução

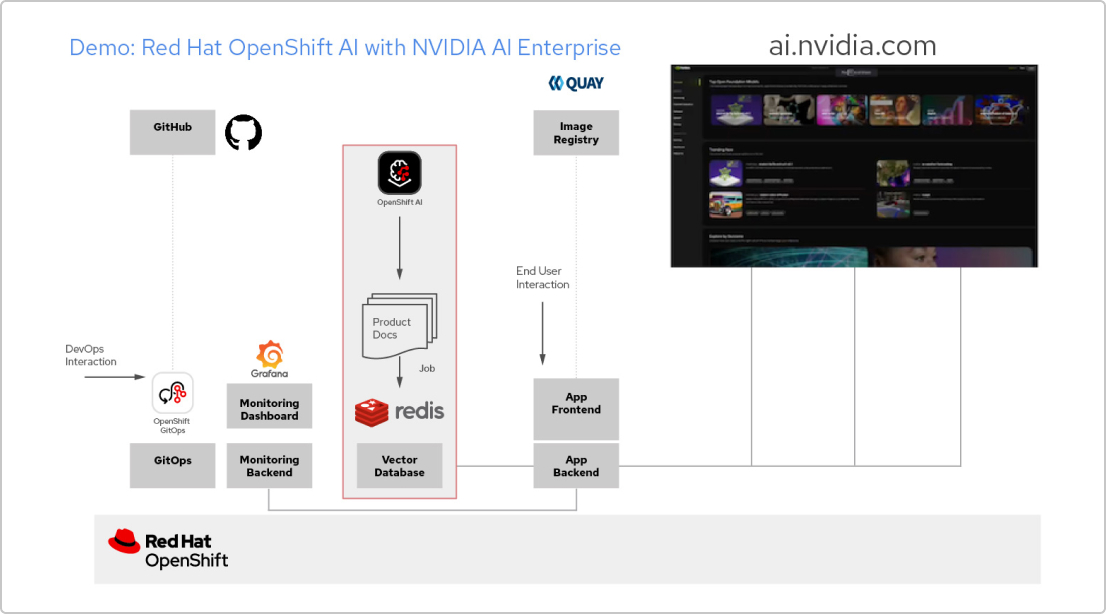

Aplicações de IA com a Red Hat e o NVIDIA AI Enterprise

Crie uma aplicação com RAG

O Red Hat OpenShift AI é uma plataforma para criar projetos de ciência de dados e disponibilizar aplicações com IA. Você pode integrar todas as ferramentas para dar suporte à Geração Aumentada de Recuperação (RAG), um método para receber respostas da IA a partir dos seus próprios documentos de referência. Quando você conecta o OpenShift AI ao NVIDIA AI Enterprise, é possível testar large language models (LLMs) para encontrar o melhor modelo para sua aplicação.

Crie um pipeline de documentos

Para usar a RAG, primeiro você precisa ingerir seus documentos em um banco de dados vetorial. Na nossa app de exemplo, inserimos um conjunto de documentos da solução em um banco de dados do Redis. Como esses documentos mudam com frequência, criamos um pipeline para esse processo que executaremos periodicamente. Dessa forma, sempre teremos as versões mais recentes dos documentos.

Confira o catálogo de LLM

O NVIDIA AI Enterprise oferece um acesso a um catálogo de diferentes LLMs para que você tenha opções diversas e selecione o modelo com os melhores resultados. Os modelos são hospedados no catálogo da API da NVIDIA. Após configurar um token de API, é possível implantar modelos usando a plataforma de model serving NVIDIA NIM diretamente a partir do OpenShift AI.

Como escolher o modelo ideal

Conforme você testa LLMs diferentes, seus usuários podem avaliar cada resposta gerada. Você pode configurar um dashboard de monitoramento do Grafana para comparar as avaliações e o tempo de resposta e latência de cada modelo. Depois, use esses dados para escolher o melhor LLM para a produção.

Como testar o Red Hat OpenShift AI

Sandbox do desenvolvedor

Para desenvolvedores e cientistas de dados experimentarem criar aplicações com IA em um ambiente flexível e pré-configurado.

Teste de 60 dias

Quando sua organização estiver pronta para avaliar todos os recursos do OpenShift AI, faça um teste de solução de 60 dias. É necessário ter um cluster do Red Hat OpenShift.