Warum können nicht alle GPUs im Rechenzentrum integriert sein?

Traditionell wurde ein zentraler Ansatz für die IT-Architektur bevorzugt, um Skalierbarkeits-, Management- und Umgebungsprobleme anzugehen. Es gibt sicherlich Use Cases für diesen Ansatz:

- Die Rechenzentren, in denen die Hardware untergebracht ist, sind sehr groß

- Es ist fast immer mehr Platz für zusätzliche Knoten oder Hardware, die allesamt lokal verwaltet werden können (manchmal sogar im selben Subnetz).

- Stromversorgung, Kühlung und Konnektivität sind konstant und redundant

Warum eine Lösung reparieren, die nicht defekt ist? Nun, es ist nicht so, dass die Lösung korrigiert werden muss... aber eine Einheitslösung ist selten für alle geeignet. Sehen wir uns ein Beispiel mit Qualitätskontrolle in der Fertigung an.

Qualitätskontrolle in der Herstellung

Eine Fabrik oder ein Fließband kann Hunderte, manchmal Tausende von Bereichen haben, in denen bestimmte Aufgaben an Fließbändern ausgeführt werden. Bei der Verwendung eines herkömmlichen Modells müsste jeder digitale Schritt oder jedes reale Tool nicht nur seine Aufgabe ausführen, sondern das Arbeitsergebnis an eine zentrale Anwendung in einer weit, weit entfernten Cloud weiterleiten. Dies kann Fragen aufwerfen, beispielsweise:

- Geschwindigkeit: Wie lange dauert es, bis ein Foto aufgenommen, in eine Cloud hochgeladen, von der zentralen Anwendung analysiert, eine Antwort gesendet und eine Maßnahme ergriffen wird? Arbeiten Sie langsam und reduzieren den Umsatz oder schnell und riskieren Sie Fehler oder Unfälle? Werden Entscheidungen in Echtzeit oder nahezu in Echtzeit getroffen?

- Menge: Wie viel Netzwerkbandbreite wird benötigt, damit jeder einzelne Sensor kontinuierlich einen Stream mit Rohdaten hoch- oder herunterlädt? Ist das überhaupt möglich? Ist das Projekt zu teuer?

- Zuverlässigkeit: Was passiert, wenn die Netzwerkkonnektivität abfällt; bleibt die ganze Fabrik stehen?

- Skalierung: Kann ein zentrales Rechenzentrum bei laufender Geschäftstätigkeit skaliert werden, um sämtliche Rohdaten von jedem Gerät ortsunabhängig zu verarbeiten? Wenn ja, zu welchen Kosten?

- Sicherheit: Werden Rohdaten als sensibel angesehen? Ist das Verlassen des Bereichs erlaubt? Ort der Speicherung? Müssen die Daten vor dem Streamen und Analysieren verschlüsselt werden?

Wechsel zum Edge

Wenn Sie eine dieser Antworten zum Nachdenken gebracht hat, ist Edge Computing eine Überlegung wert. Einfach ausgedrückt, werden beim Edge Computing kleinere, latenzempfindliche oder private Anwendungsfunktionen aus dem Rechenzentrum an den Ort verlagert, an dem die eigentliche Arbeit erledigt wird. Edge Computing ist bereits alltäglich. es ist in den Autos, die wir fahren und in den Handys in der Taschen. Mit Edge Computing wird die Skalierung von einem Problem zum Vorteil.

Sehen Sie sich unser Fertigungsbeispiel noch einmal an. Wenn sich in der Nähe jeder Fertigungslinie ein kleiner Cluster befinden würde, könnten alle oben genannten Probleme gemildert werden.

- Geschwindigkeit: Fotos der abgeschlossenen Aufgaben werden vor Ort überprüft, wobei die lokale Hardware mit weniger Verzögerungen arbeiten kann.

- Menge: Bandbreite zu externen Standorten wird stark reduziert, wodurch wiederkehrende Kosten eingespart werden.

- Zuverlässigkeit: Selbst bei einem Ausfall der Wide-Area-Netzwerkkonnektivität kann die Arbeit lokal fortgesetzt und eine Synchronisierung mit einer zentralen Cloud vorgenommen werden, wenn die Konnektivität wiederhergestellt ist.

- Skalierung: Ob Sie nun 2 oder 200 Fabriken betreiben, die benötigten Ressourcen sind an den jeweiligen Standorten vorhanden. Dadurch wird die Notwendigkeit reduziert, zentrale Rechenzentren nur für den Betrieb in Spitzenzeiten überbauen zu müssen.

- Sicherheit: Es werden keine Rohdaten verwendet, wodurch die potenzielle Angriffsfläche reduziert wird.

Wie sieht Edge mit Public Cloud aus?

Red Hat OpenShift, die führende Kubernetes -Plattform für Unternehmen, bietet eine flexible Umgebung, mit der Anwendungen und Infrastruktur dort platziert werden können, wo sie am dringendsten benötigt werden. In diesem Fall kann es nicht nur in einer zentralisierten Public Cloud ausgeführt werden, sondern die Anwendungen können auch selbst ans Fließband gebracht werden. Sie können die Daten direkt vor Ort schnell erfassen, verarbeiten und darauf reagieren. Es ist Machine Learning (ML) – am Edge. Schauen wir uns drei Beispiele an, die Edge Computing mit Private und Public Clouds kombinieren. Die erste kombiniert Edge Computing und eine Public Cloud.

- Die Datenerfassung erfolgt Onsite, wo die Rohdaten erfasst werden. Sensoren und IoT-Geräte (Internet of Things), die Messungen vornehmen oder Aufgaben durchführen, können über Red Hat AMQ Streams oder die AMQ Broker-Komponente eine Verbindung zu lokalisierten Edge-Servern herstellen. Diese können je nach Anwendungsanforderungen von kleinen einzelnen Knoten bis hin zu größeren Hochverfügbarkeits-Clustern reichen. Und das Beste ist, dass diese beliebig kombiniert werden können – mit kleinen Knoten in abgelegenen Gebieten und größeren Clustern, wo mehr Platz zur Verfügung steht.

- Datenvorbereitung, Modellierung, Anwendungsentwicklung und -bereitstellung sind die Bereiche, in denen die eigentliche Arbeit erledigt wird. Die Daten werden aufgenommen, gespeichert und analysiert. Am Beispiel des Fließbands werden Bilder von Widgets auf Muster analysiert (wie etwa Fehler in Materialien oder Prozessen). Hier findet das eigentliche Lernen statt. Die neu gewonnenen Erkenntnisse werden dann wieder in die cloudnativen Anwendungen am Edge integriert. Allerdings findet all dies nicht mehr am Edge statt, denn die Ausführung intensiver CPUs und GPUs (Central and GPU) auf lückenlosen, zentralisierten Clustern beschleunigt den Prozess um Tage oder Wochen, verglichen mit der Ausführung auf schlanken Edge-Geräten.

- Mit Red Hat OpenShift Pipelines und GitOps können Entwickler ihre Anwendungen mithilfe von Continuous Integration und Continuous Delivery (CI/CD) kontinuierlich verbessern, um den Prozess so schnell wie möglich zu gestalten. Je schneller erlangtes Wissen genutzt werden kann, desto effizienter können Zeit und Ressourcen für die Umsatzgenerierung eingesetzt werden. Das bringt uns wieder an den Edge, an dem die neuen (aktualisierten) Apps, die auf künstlicher Intelligenz basieren, ihre gewonnenen Erkenntnisse analysieren und Daten aufnehmen, bevor sie mit aktuellen Modellen verglichen werden. Der Zyklus wiederholt sich als Teil der kontinuierlichen Verbesserung.

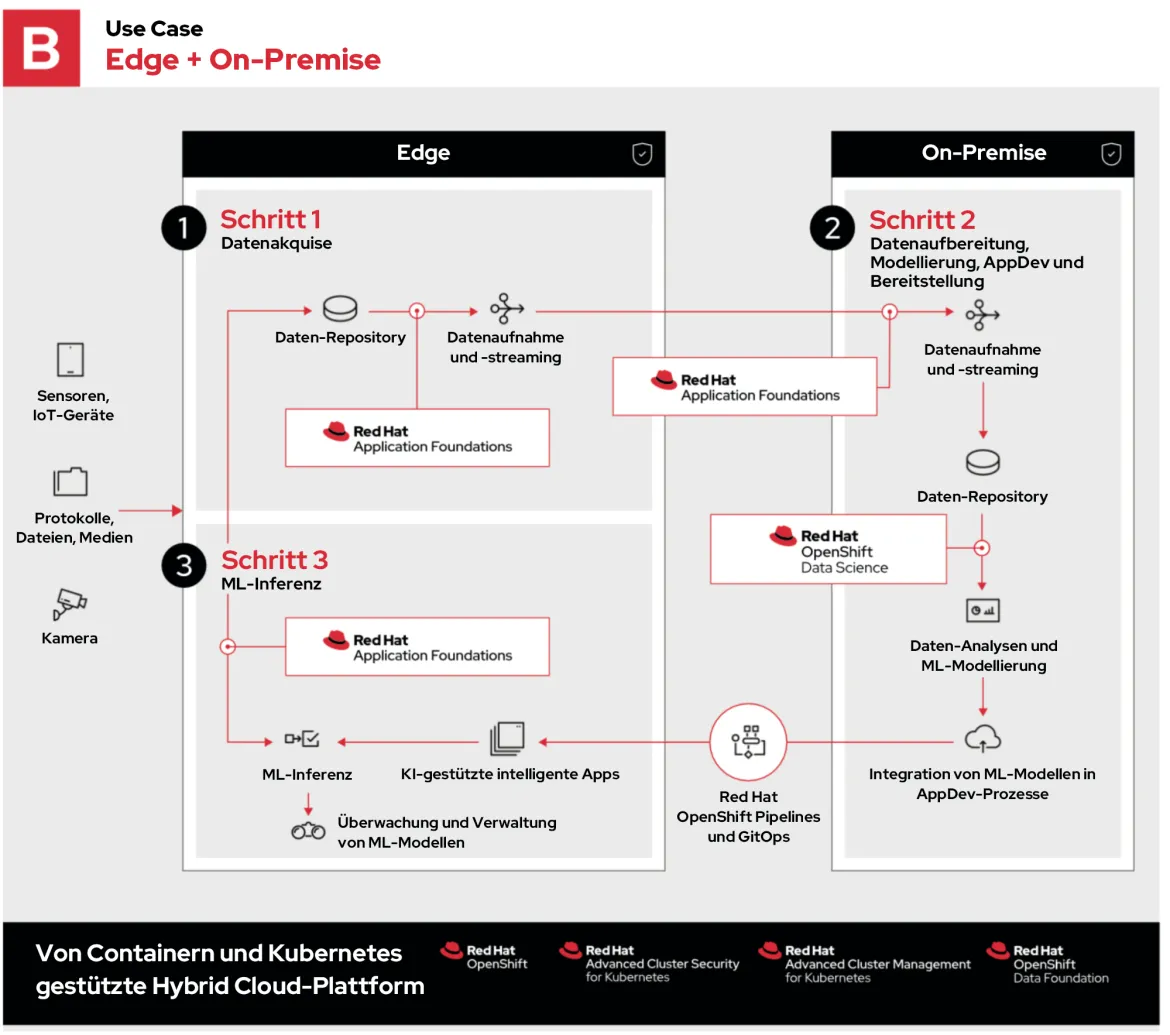

Wie sieht Edge mit Private Cloud aus?

Im zweiten Beispiel ist der gesamte Prozess derselbe, mit Ausnahme von Schritt 2, der jetzt lokal in einer Private Cloud stattfindet .

Unternehmen entscheiden sich möglicherweise aus folgenden Gründen für eine Private Cloud:

- Sie sind bereits im Besitz der Hardware und können das vorhandene Kapital nutzen.

- Sie müssen strenge Vorschriften über Daten Locale und Datensicherheit einhalten. Vertrauliche Daten können nicht in einer Public Cloud gespeichert oder durch diese weitergeleitet werden.

- Sie erfordern kundenspezifische Hardware wie vor Ort programmierbare Gate-Arrays, GPUs oder eine Konfiguration, die nicht bei einem Public Cloud-Anbieter gemietet werden kann.

- Sie führen spezifische Workloads in einer Public Cloud aus, die mehr kosten als auf lokaler Hardware.

Dies sind nur einige Beispiele für die Flexibilität, die OpenShift bietet. Sie kann so einfach sein wie die Ausführung von OpenShift auf einer Red Hat OpenStack Platform Private Cloud.

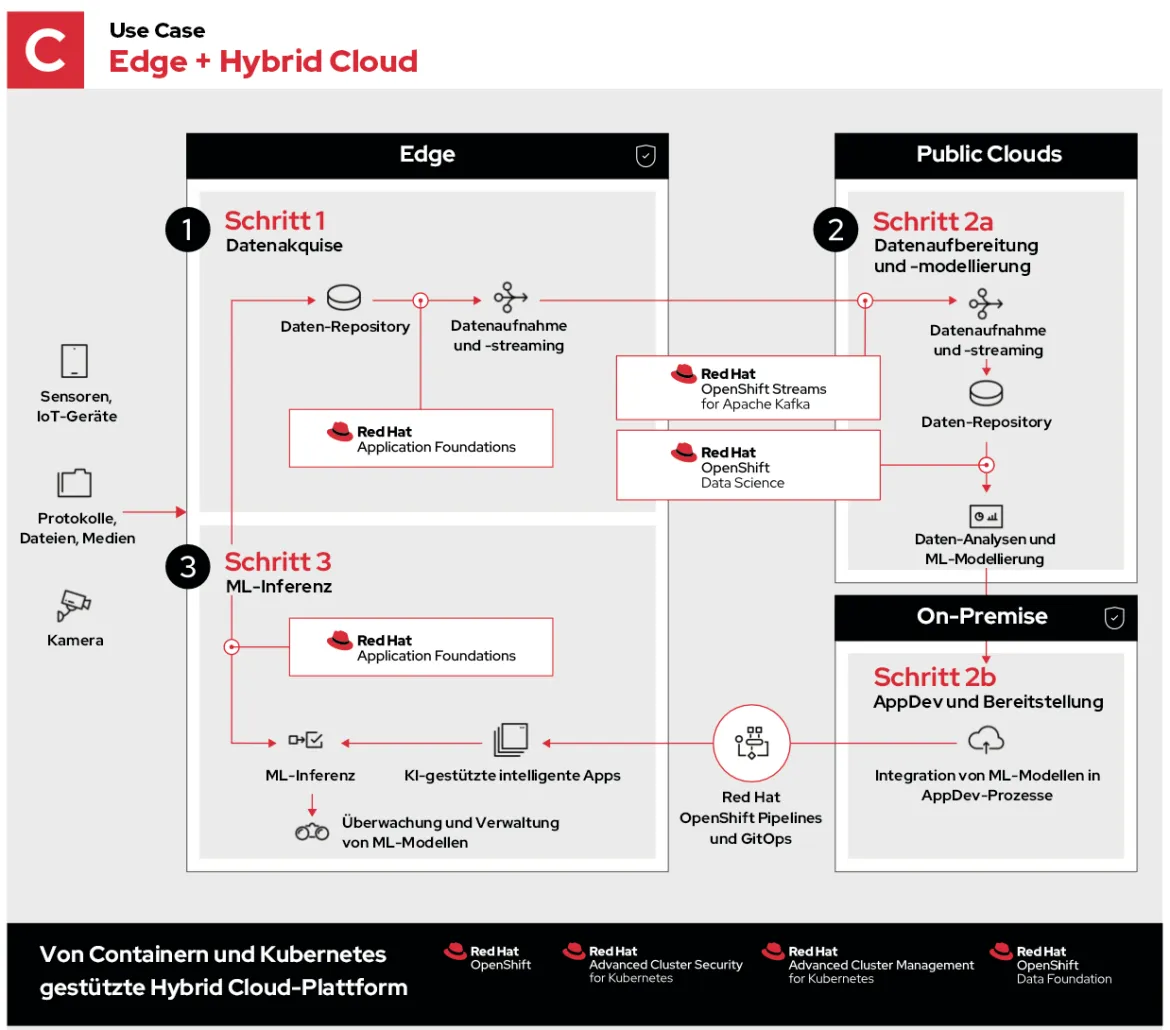

Wie sieht Edge mit Hybrid Cloud aus?

Im letzten Beispiel wird eine Hybrid Cloud verwendet, die aus Public und Private Clouds besteht.

In diesem Fall sind die Schritte 1 und 3 identisch, und sogar Schritt 2 umfasst die gleichen Prozesse. Sie sind jedoch so verteilt, dass sie in optimalen Umgebungen ausgeführt werden können.

- In Schritt 2a geht es um das Aufnehmen, Speichern und Analysieren von Daten am Edge. Dabei werden die umfangreichen Ressourcen, die geografische Vielfalt und die Konnektivität der Public Cloud zur Erfassung und Entschlüsselung von Daten genutzt.

- Schritt 2b ermöglicht die lokale Anwendungsentwicklung, die bestimmte Entwicklungs-Workflows beschleunigen, sichern oder auf andere Weise anpassen kann, bevor diese Updates wieder an den Edge gesendet werden.

Was bietet Red Hat?

Angesichts der zahlreichen Variablen und Überlegungen, die berücksichtigt werden müssen, muss eine erfolgreiche Edge-Computing-Umgebung flexibel sein. Ob es um den Umgang mit langsamen, unzuverlässigen oder gar keinen Netzwerkverbindungen, strikte Compliance oder extreme Performanceanforderungen geht – Red Hat gibt unseren Kunden die Tools, die sie brauchen, um flexible Lösungen zu entwickeln – abgestimmt auf die Ausführung der richtigen Anwendungen am richtigen Ort.

Unabhängig davon, ob die Daten am Edge, in einer bekannten Public Cloud oder lokal in einer Private Cloud (oder an verschiedenen Orten gleichzeitig) ermittelt werden, können Entwicklerinnen und Entwickler vertraute Tools verwenden, um ihre cloudnativen Anwendungen (auf OpenShift) kontinuierlich zu erneuern und sie so ausführen, wie und wo es am besten ist.

Über den Autor

Ben has been at Red Hat since 2019, where he has focused on edge computing with Red Hat OpenShift as well as private clouds based on Red Hat OpenStack Platform. Before this he spent a decade doing a mix of sales and product marking across telecommunications, enterprise storage and hyperconverged infrastructure.

Nach Thema durchsuchen

Automatisierung

Das Neueste zum Thema IT-Automatisierung für Technologien, Teams und Umgebungen

Künstliche Intelligenz

Erfahren Sie das Neueste von den Plattformen, die es Kunden ermöglichen, KI-Workloads beliebig auszuführen

Open Hybrid Cloud

Erfahren Sie, wie wir eine flexiblere Zukunft mit Hybrid Clouds schaffen.

Sicherheit

Erfahren Sie, wie wir Risiken in verschiedenen Umgebungen und Technologien reduzieren

Edge Computing

Erfahren Sie das Neueste von den Plattformen, die die Operations am Edge vereinfachen

Infrastruktur

Erfahren Sie das Neueste von der weltweit führenden Linux-Plattform für Unternehmen

Anwendungen

Entdecken Sie unsere Lösungen für komplexe Herausforderungen bei Anwendungen

Virtualisierung

Erfahren Sie das Neueste über die Virtualisierung von Workloads in Cloud- oder On-Premise-Umgebungen