Red Hat은 오늘 Red Hat Enterprise Linux AI(RHEL AI)의 개발자 프리뷰를 발표했습니다. RHEL AI는 기업 애플리케이션을 구동하기 위해 최고의 오픈소스 Granite 생성형 AI 모델을 원활하게 개발, 테스트 및 실행할 수 있는 기반 모델 플랫폼입니다. RHEL AI는 InstructLab 오픈소스 프로젝트을 기반으로 하며, LAB (Large-scale Alignment for ChatBots ) 방법론을 사용하여 최적화된 부팅 가능한 RHEL 이미지에서 서버 배포를 간소화합니다.

RHEL AI 및 InstructLab 프로젝트의 주요 목표는 도메인 전문가가 지식 및 기술로 대규모 언어 모델에 직접 기여할 수 있도록 지원하는 것입니다. 이를 통해 도메인 전문가는 AI 기반 애플리케이션(예: 챗봇)을 더 효율적으로 구축할 수 있습니다. RHEL AI는 다음과 같이 필요한 모든 것을 포함합니다:

- 오픈소스 모델과 오픈소스 기술 및 지식을 통한 커뮤니티 혁신 활용

- 데이터 사이언스 경험이 없는 도메인 전문가를 대상으로 사용자 친화적인 소프트웨어 툴 및 워크플로우 세트를 제공하여 교육 및 미세 조정을 수행할 수 있도록 합니다.

- 최적화된 AI 하드웨어 지원으로 소프트웨어 및 운영 체제 패키징

- 엔터프라이즈 지원 및 지적 재산권 면책

배경

대규모 언어 모델(Large Language Model, LLM)과 이를 기반으로 하는 서비스(예: GPT 및 ChatGPT)는 잘 알려져 있으며 엔터프라이즈 조직에서 점점 더 많이 채택하고 있습니다. 이러한 모델은 대부분 폐쇄형 소스(closed source)이거나 사용자 정의 라이센스가 있는 모델입니다. 최근에는 Mistral, Llama, OpenELM과 같은 다양한 오픈 모델이 등장하기 시작했습니다. 그러나 이러한 모델 중 일부의 개방성은 제한적입니다(예: 상업적 사용에 대한 제한 및/또는 교육 데이터 및 트랜스포머 가중치 및 재현성과 관련된 기타 요인에 관한 개방성 부족). 가장 중요한 요인은 커뮤니티가 모델을 개선하기 위해 협업하고 기여할 수 있는 방법이 없다는 것입니다.

오늘날 LLM은 대규모의 범용입니다. Red Hat은 데이터 프라이버시, 주권, 기밀성을 최우선으로 하는 세계적 수준의 MLOps 툴링으로 둘러싸여 목적에 맞게 구축되고 비용 및 성능이 최적화된 모델의 세계를 구상합니다.

LLM을 미세 조정하기 위한 교육 파이프라인에는 데이터 사이언스 전문 지식이 필요하며, 교육을 위한 리소스 사용량 측면과 고품질 교육 데이터 비용 측면에서 많은 비용이 들 수 있습니다.

Red Hat은 (IBM은 물론 오픈소스 커뮤니티와 협력하여) 이러한 변화를 제안합니다. 익숙한 오픈소스 기여자 워크플로우와 퍼미시브(permissive) 라이센싱(예: Apache2)과 같은 관련 개념을 오픈 협업을 위한 모델 및 툴에 도입하여 사용자 커뮤니티가 LLM에 기여를 생성하고 추가할 수 있도록 제안합니다. 이를 통해 파트너 에코시스템은 기업이 보호 정보를 확장하고 통합할 수 있도록 오퍼링과 가치를 제공할 수 있습니다.

Introducing Red Hat Enterprise Linux AI!

Red Hat Enterprise Linux AI는 다음과 같은 4가지 기본 구성 요소로 구성됩니다.

1. Open Granite(오픈 그래니트) 모델

RHEL AI에는 고성능 오픈소스 라이센스가 포함된 협업을 통해 개발된 그래니트 언어 및 InstructLab 커뮤니티의 코드 모델이 포함되어 있으며, Red Hat이 전체적으로 지원하고 면책합니다. 이러한 Granite 모델 은 Apache 2 라이센스가 있으며 데이터 소스 및 모델 가중치에 대한 투명한 액세스를 제공합니다.

사용자는 자신의 기술과 지식으로 기본 모델을 교육하여 고유한 사용자 지정 LLM을 만들 수 있습니다. 훈련된 모델과 추가된 기술 및 지식을 커뮤니티와 공유하거나 비공개로 유지할 수 있습니다. 자세한 내용은 다음 섹션에서 확인하세요.

개발자 프리뷰의 경우 사용자는 Granite 7b 영어(기본) 모델 및 해당 Granite 7b LAB 모델에 액세스할 수 있습니다(LAB에 대한 자세한 내용은 아래 참조).

향후 Red Hat Enterprise Linux AI에는 Granite 코드 모델 제품군을 비롯한 추가 Granite 모델도 포함될 예정입니다. 앞으로도 계속 지켜봐 주시기 바랍니다.

2. InstructLab 모델 정렬

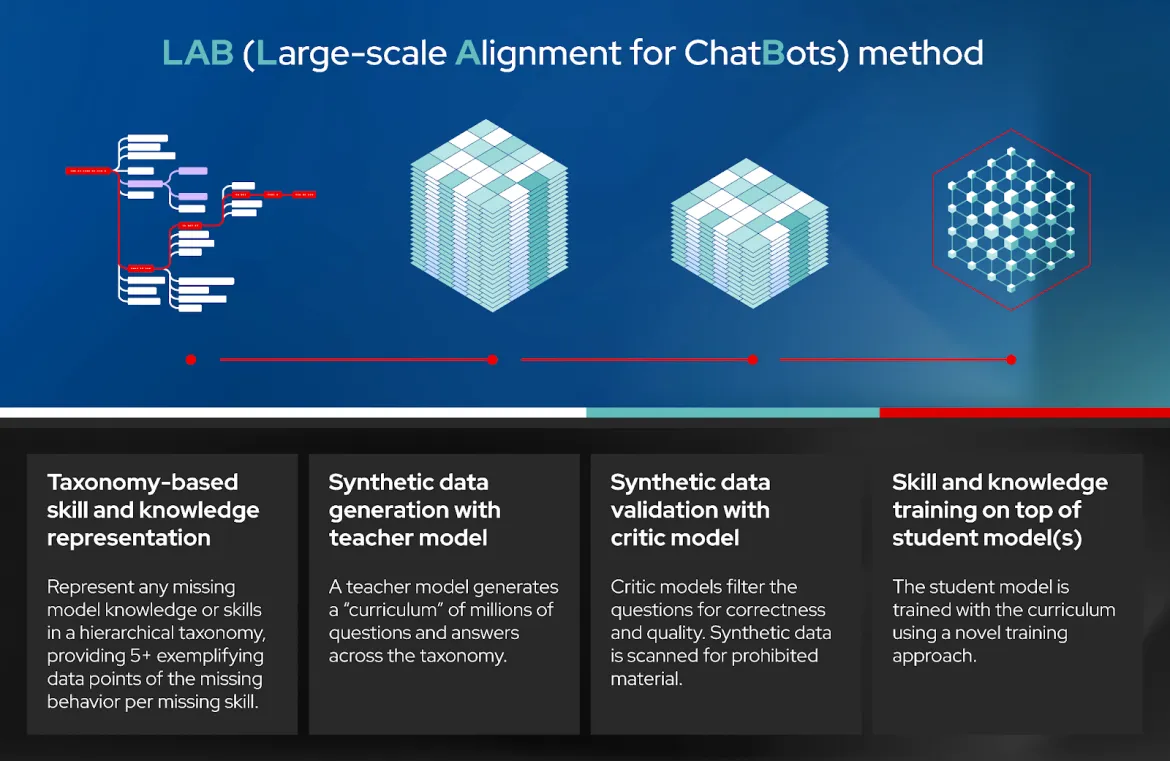

LAB: Large-Scale Alignment for ChatBots(대규모 챗봇 정렬)는 고품질 합성 데이터 생성을 활용하는 분류 기반 접근 방식으로 대규모 언어 모델의 명령 정렬 및 미세 튜닝에 대한 새로운 접근 방식입니다. 간단히 말해 사용자가 도메인별 지식과 기술로 LLM을 사용자 지정할 수 있습니다. 그런 다음 InstructLab은 LLM을 훈련하는 데 사용되는 고품질 합성 데이터(synthetic data)를 생성합니다. 재생 버퍼(replay buffer)는 잊는 것을 방지하는 데 사용됩니다. 자세한 내용은 학술 문서의 섹션 3.3 을 참조하세요.

LAB 기술에는 4개의 개별 단계가 포함됩니다(다이어그램 참조).

- 분류 기반 기술 및 지식 표현

- 교사 모델(teacher model)을 사용한 합성 데이터 생성(SDG)

- 비판 모델(critic model)을 사용한 종합 데이터 검증

- 수강생 모델(student model)을 기반으로 한 기술 및 지식 교육

InstructLab은 LAB 기술을 구현하는 소프트웨어의 이름입니다. 사용자가 추가한 새로운 기술 및 지식을 포함하여 기술 및 지식의 로컬 Git 리포지토리와 상호 작용하여 합성 데이터를 생성하고, LLM의 훈련을 실행하고, 훈련된 모델을 제공하고, 이 모델과 채팅하는 커맨드라인 인터페이스로 구성됩니다. .

개발자 프리뷰에서 InstructLab은 다음을 사용합니다. a) 기술 및 지식을 추가하기 위한 git 워크플로우, b) 합성 데이터를 생성하기 위한 교사 모델로 혼합(Mixtral), c) 단계별 교육을 위한 deepspeed, d) 추론 서버로 vllm을 사용합니다. 그 외에도 툴링은 수동 검토 및 피드백을 허용하는 게이트를 제공합니다. Red Hat은 향후 더 쉽고 확장 가능한 툴링을 추가하기 위해 노력하고 있습니다. 다른 오픈소스 프로젝트와 마찬가지로, 여러분도 오픈소스 프로젝트의 방향을 정하는 데 도움을 줄 수 있습니다!

InstructLab은 Red Hat과 IBM이 협력하여 시작한 오픈소스 커뮤니티 프로젝트이기도 합니다. 커뮤니티 프로젝트는 커뮤니티 구성원이 유지 관리하는 공용 Apache 2.0 라이센스 분류 체계로 기여를 통합합니다. LAB 학습 모델은 모델에 대한 커뮤니티 분류 기여를 포함하여 커뮤니티에 주기적으로 릴리스됩니다.

3. 최적화된 부팅 가능 Red Hat Enterprise Linux for Granite 모델 및 InstructLab

앞서 언급한 Granite 모델 및 InstructLab 툴링은 AMD, Intel, NVIDIA와 같은 벤더의 널리 사용되는 하드웨어 가속기에 최적화된 소프트웨어 스택과 함께 부팅 가능 RHEL 이미지 에 다운로드되어 배포됩니다. 또한 이러한 RHEL AI 이미지는 퍼블릭 클라우드(개발자 프리뷰에서 검증된 IBM 클라우드)와 Dell, Cisco, HPE, Lenovo, SuperMicro의 AI 최적화 서버를 포함한 Red Hat 인증 에코시스템 전반에서 부팅되고 실행됩니다. 초기 테스트 결과, 합리적인 시간 내에 엔드 투 엔드 InstructLab 실행을 완료하려면 320GB VRAM(NVIDIA H100 GPU 4개) 또는 이에 상응하는 용량이 필요한 것으로 나타났습니다.

4. 엔터프라이즈 지원, 라이프사이클 및 면책(indemnification)

GA(General Availability) 시점에 Red Hat Enterprise Linux AI 서브스크립션에는 엔터프라이즈 지원, granite 7B 모델 및 소프트웨어로 시작하는 전체 제품 라이프사이클, Red Hat의 IP 면책이 포함됩니다.

개발자 프리뷰의 경우 Red Hat Enterprise Linux AI는 Red Hat 지원 및 면책 없이 커뮤니티에서 지원합니다.

실험에서 프로덕션까지

첫 번째 프로덕션 배포를 시작하여 스케일에 따라 프로덕션에 이르는 3단계 접근 방식은 다음과 같습니다.

- 1단계: 오픈소스 InstructLab CLI를 사용하여 노트북(또는 데스크탑)을 시작할 수 있습니다. 이를 통해 InstructLab에 익숙해지고 기술과 지식이 추가된 저충실도 모델(qlora)이 생성됩니다.

- 2단계: Red Hat Enterprise LInux AI를 베어 메탈 서버, 온프레미스 또는 클라우드의 가상 머신으로 부팅할 수 있습니다. 이제 InstructLab을 사용하여 충실도가 높은 훈련 및 튜닝된 모델을 얻기 위해 기술과 지식 코퍼스를 추가하고 교육할 수 있습니다. 그런 다음 애플리케이션과 채팅하고 통합할 수 있습니다.

- 3단계: 대규모 프로덕션의 경우 위와 동일한 방법론(RHEL AI 사용)을 사용할 수 있지만, OpenShift로 더 빠르게 완료하고 처리량을 높이기 위해 여러 노드에 교육을 분산할 수 있다는 추가 이점이 있습니다. AI. 또한 OpenShiftAI를 사용하면 훈련된 모델을 프로덕션 환경에서 클라우드 네이티브 애플리케이션과 훨씬 쉽게 통합할 수 있습니다.

결론

Red Hat은 IBM과 함께 오픈소스 커뮤니티 및 파트너와 함께 오픈소스 혁신과 협업의 힘을 대규모 언어 모델(Large Language Models) 및 오픈 엔터프라이즈 소프트웨어에 제공하는 놀라운 여정을 시작했습니다. Red Hat은 이것이 시작에 불과하며 앞으로 많은 기회가 있다고 믿습니다.

그 여정에 여러분을 초대합니다. Red Hat의 오픈소스 커뮤니티에 참여하여 기여해 주세요!

노트북/데스크탑에서 InstructLab cli를 다운로드하여 오픈소스 granite 모델 교육을 시작하거나 RHEL AI developer preview로 바로 이동할 수 있습니다. 개발자 프리뷰와 관련하여 도움이 필요한 경우 [email protected]으로 문의하시기 바랍니다.

참고 자료

저자 소개

A 20+ year tech industry veteran, Jeremy is a Distinguished Engineer within the Red Hat OpenShift AI product group, building Red Hat's AI/ML and open source strategy. His role involves working with engineering and product leaders across the company to devise a strategy that will deliver a sustainable open source, enterprise software business around artificial intelligence and machine learning.

유사한 검색 결과

채널별 검색

오토메이션

기술, 팀, 인프라를 위한 IT 자동화 최신 동향

인공지능

고객이 어디서나 AI 워크로드를 실행할 수 있도록 지원하는 플랫폼 업데이트

오픈 하이브리드 클라우드

하이브리드 클라우드로 더욱 유연한 미래를 구축하는 방법을 알아보세요

보안

환경과 기술 전반에 걸쳐 리스크를 감소하는 방법에 대한 최신 정보

엣지 컴퓨팅

엣지에서의 운영을 단순화하는 플랫폼 업데이트

인프라

세계적으로 인정받은 기업용 Linux 플랫폼에 대한 최신 정보

애플리케이션

복잡한 애플리케이션에 대한 솔루션 더 보기

가상화

온프레미스와 클라우드 환경에서 워크로드를 유연하게 운영하기 위한 엔터프라이즈 가상화의 미래