Oggi, Red Hat ha annunciato un'anteprima di Red Hat Enterprise Linux AI (RHEL AI) per gli sviluppatori. La piattaforma per modelli fondativi è pensata per sviluppare, testare ed eseguire in modo efficiente modelli di IA generativa Granite open source e all'avanguardia, migliorando le applicazioni enterprise. RHEL AI si basa sul progetto open source InstructLab e unisce i modelli linguistici di grandi dimensioni con licenza open source Granite di IBM Research agli strumenti di allineamento dei modelli di InstructLab, basati sulla metodologia LAB (Large-scale Alignment for chatBots ) Questo consente di ottenere in un'immagine RHEL ottimizzata e avviabile al fine di semplificare i deployment dei server.

L'obiettivo principale di RHEL AI e del progetto InstructLab è consentire agli esperti di contribuire direttamente ai modelli linguistici di grandi dimensioni apportando conoscenze e competenze, oltre a creare applicazioni basate sull'intelligenza artificiale (come i chatbot) in modo più efficiente. RHEL AI include tutto ciò di cui hai bisogno perché:

- consente di trarre vantaggio dalle innovazioni della community, tramite modelli open source, competenze e conoscenze open source per l'addestramento dei modelli

- fornisce un strumenti software e flussi di lavoro intuitivi rivolti agli addetti senza esperienza in data science e consente loro di svolgere attività di addestramento e fine tuning

- offre la pacchettizzazione di software e sistema operativo con abilitazione hardware IA ottimizzata

- fornisce supporto agli account aziendali e indennizzo per la proprietà intellettuale

Informazioni generali

I Large Language Model (LLM) e i servizi basati su di essi (come GPT e chatGPT) sono noti e adottati sempre più spesso dalle organizzazioni aziendali. Nella maggior parte dei casi, questi modelli sono closed source o offrono una licenza personalizzata. Più recentemente, sono comparsi diversi modelli open source, tra cui Mistral, Llama e OpenELM. Tuttavia, l'apertura di alcuni di questi modelli è limitata. Possiamo pensare alle limitazioni all'uso commerciale o all'assenza di approcci open source per quanto riguarda l'addestramento dei dati o open weight nel caso dei trasformatori, oppure ad altri fattori legati alla riproducibilità. Il fattore più importante è forse l'assenza di modi in cui le comunità possano collaborare e contribuire ai modelli per migliorarli.

Oggi gli LLM sono di grandi dimensioni e generici. Red Hat immagina un mondo di modelli specifici, ottimizzati in termini di costi e prestazioni, circondati da strumenti MLOps di prim'ordine che mettono in primo piano la privacy, la sovranità e la riservatezza dei dati.

La pipeline di formazione per ottimizzare gli LLM richiede competenze in data science e può essere costosa, sia in termini di utilizzo delle risorse per la formazione, sia a causa del costo di dati di alta qualità destinati all'addestramento.

Red Hat, insieme a IBM e alla community open source, ha in mente dei cambiamenti. Per i contributor, proponiamo di introdurre nei modelli e negli strumenti per la collaborazione open source i flussi di lavoro open source e altri concetti, come le licenze permissive (es. Apache2), per consentire alle community di utenti di creare e aggiungere contributi agli LLM. Ciò consentirà anche a un ecosistema di partner di offrire soluzioni e valore, permettendo alle aziende di estendere obiettivi e incorporare informazioni protette.

Introduzione a Red Hat Enterprise Linux AI

Red Hat Enterprise Linux AI comprende quattro componenti fondamentali distinti:

1. Modelli Open Granite

RHEL AI include modelli di codice e linguaggio Granite ad alte prestazioni, con licenza open source, sviluppati attraverso la collaborazione dalla community InstructLab, e completamente supportati e indennizzati da Red Hat. Questi modelli Granite sono concessi in licenza Apache 2 e forniscono un accesso trasparente alle sorgenti dei dati e ai pesi associati ai modelli.

Gli utenti possono creare il proprio LLM personalizzato addestrando i modelli di base con le proprie competenze e conoscenze. Possono scegliere di condividere il modello addestrato, le competenze e le conoscenze aggiuntive con la community oppure di mantenerle private. Scopri di più nei paragrafi successivi.

Nell'anteprima per gli sviluppatori, gli utenti possono accedere al modello Granite 7b in lingua inglese (base)e al corrispondente modello Granite 7b LAB (vedi di seguito per ulteriori informazioni su LAB).

In futuro, Red Hat Enterprise Linux AI includerà anche altri modelli Granite, tra cui la famiglia di modelli di Granite code. Non perderti le novità su questo argomento.

2. Allineamento del modello InstructLab

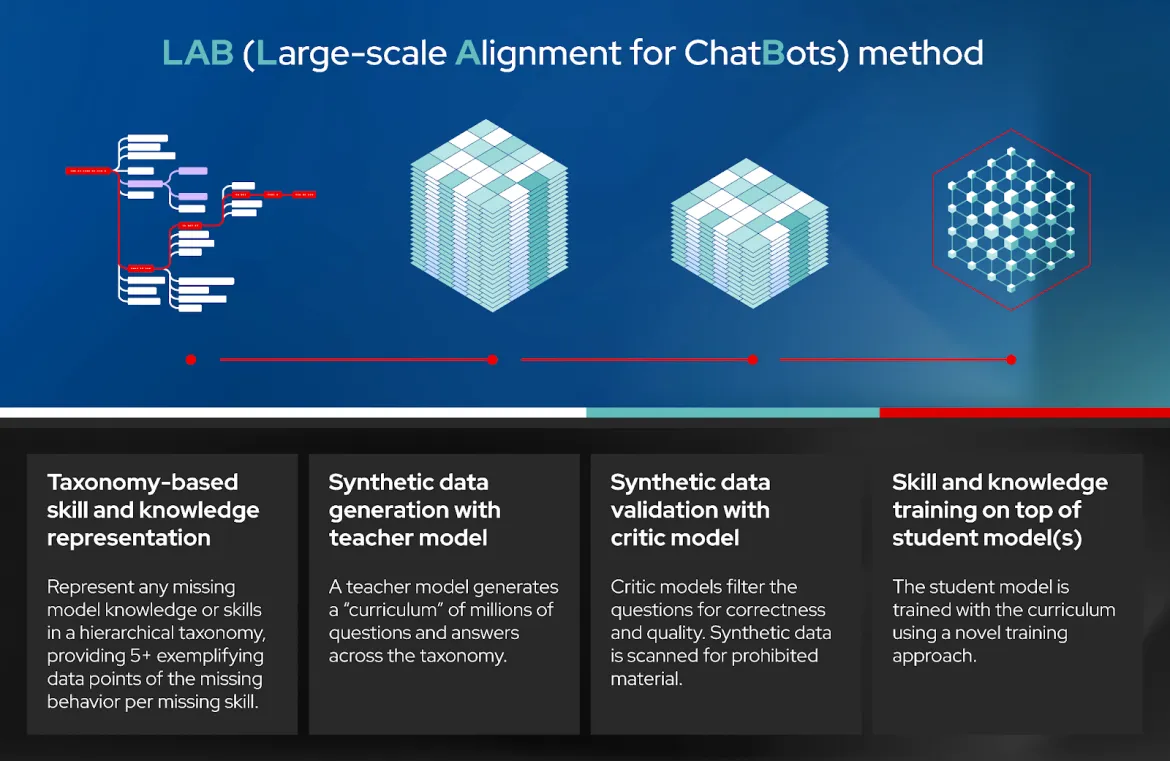

LAB: Large-Scale Alignment for ChatBots è un nuovo approccio per l'allineamento delle istruzioni e per il fine tuning dei modelli linguistici di grandi dimensioni basato sulla tassonomia, che sfrutta la generazione di dati sintetici di alta qualità. In parole semplici, consente agli utenti di personalizzare un LLM con conoscenze e competenze specifiche del dominio. InstructLab genera quindi dati sintetici di alta qualità che vengono utilizzati per addestrare l'LLM. Viene utilizzato un buffer di riproduzione per evitare che si dimentichi. Vedi paragrafo 3.3 del documento accademico per maggiori dettagli.

La tecnica LAB prevede quattro fasi distinte (vedi diagramma):

- Competenze basate sulla tassonomia e rappresentazione delle conoscenze

- Generazione di dati sintetici (SDG) con un modello di riferimento detto "teacher model"

- Convalida dei dati sintetici con un modello critico.

- Formazione sulle competenze e sulle conoscenze in base al modello o ai modelli detti "student model"

InstructLab è il nome del software che implementa la tecnica LAB. Consiste in un'interfaccia a riga di comando che interagisce con un repository git locale di competenze e conoscenze, incluse quelle aggiunte dall'utente, per generare dati sintetici, eseguire il training dell'LLM, servire il modello addestrato e interagire con esso.

Nell'anteprima per sviluppatori, InstructLab utilizza a) un flusso di lavoro git per integrare competenze e conoscenze, b) Mixtral come teacher model per la generazione di dati sintetici, c) deepspeed per l'addestramento in più fasi e d) vllm come server di inferenza. Inoltre, gli strumenti offrono opportunità che consentono la revisione e il feedback umano. Ci stiamo adoperando per aggiungere altri strumenti al fine di rendere le attività future più semplici e scalabili. Come avviene per ogni progetto open source, puoi aiutare a migliorarlo.

InstructLab è anche il nome del progetto della community open source avviato da Red Hat in collaborazione con IBM Research. Il progetto della community riunisce i contributi in una tassonomia pubblica con licenza Apache 2.0 gestita dai membri della community. Un modello addestrato in LAB viene rilasciato periodicamente alla community e include i contributi della tassonomia della community al modello.

3. Red Hat Enterprise Linux con avvio ottimizzato per i modelli Granite e InstructLab

I modelli Granite e gli strumenti InstructLab sopra menzionati vengono scaricati e distribuiti su un'immagine RHEL avviabile con uno stack software ottimizzato per gli acceleratori hardware più diffusi di fornitori come AMD, Intel e NVIDIA . Inoltre, queste immagini RHEL AI verranno avviate ed eseguite nell'ecosistema Red Hat Certified, inclusi i cloud pubblici (IBM Cloud convaldato per la preview per sviluppatori) e i server ottimizzati per l'IA di Dell, Cisco, HPE, Lenovo e SuperMicro. Il nostro test iniziale indica che per completare un'esecuzione end to end di InstructLab in un lasso di tempo ragionevole sono necessari 320 GB di VRAM (4 x GPU NVIDIA H100) o equivalenti.

4. Supporto, ciclo di vita e indennizzo enterprise

Con la disponibilità generale (GA), le sottoscrizioni Red Hat Enterprise Linux AI includeranno il supporto enterprise, un ciclo di vita completo del prodotto che inizia con il modello e il software Granite 7B e l'indennizzo IP da parte di Red Hat.

Tieni presente che nell'anteprima per gli sviluppatori, Red Hat Enterprise Linux AI è supportato dalla community e non dà diritto a supporto e indennizzi da parte di Red Hat.

Dalla sperimentazione alla produzione

Ecco un approccio graduale in tre fasi, dai primi deployment di produzione alla produzione scalabile:

- Fase 1: È possibile iniziare dal proprio laptop (o computer desktop) utilizzando l'interfaccia a riga di comando open source di InstructLab. In questo modo potrai acquisire familiarità con InstructLab e produrre un modello a bassa fedeltà (qlora) con l'aggiunta delle tue competenze e conoscenze.

- Fase 2: È possibile avviare Red Hat Enterprise Linux AI in un server bare metal, in una macchina virtuale on premise o nel cloud. Ora puoi aggiungere un corpus di competenze e conoscenze e formarti per ottenere un modello addestrato e ottimizzato ad alta fedeltà utilizzando InstructLab, con cui puoi interagire e integrare le tue applicazioni.

- Fase 3: Per la produzione su larga scala, puoi utilizzare la stessa metodologia già illustrata (con RHEL AI), ma con l'ulteriore vantaggio di poter distribuire l'addestramento su più nodi, per un completamento più rapido e per una maggiore velocità effettiva grazie a OpenShift IA. Inoltre, OpenShiftAI semplifica notevolmente l'integrazione del modello addestrato con le applicazioni cloud native in produzione.

Conclusione

Red Hat, IBM, la community open source e i nostri partner collaborano per portare le potenzialità dell'innovazione e della collaborazione open source nei modelli linguistici di grandi dimensioni e nel software open enterprise per aziende e organizzazioni. Riteniamo che questo sia solo l'inizio e che il futuro offra molte opportunità.

Ti invitiamo a percorrere questa strada con noi. Entra a far parte della nostra community open source e inizia a contribuire!

Per iniziare ad addestrare i modelli Granite open source, scarica InstructLab cli sul tuo laptop/desktop o vai direttamente all'anteprima RHEL AI Developer Preview. Se hai bisogno di assistenza con l'anteprima per gli sviluppatori, contatta [email protected].

Riferimenti

- Comunicato stampa

- Pagina di destinazione principale per Red Hat Enterprise Linux AI

- Guarda un video per scoprire come InstructLab semplifica l'adozione dell'IA

- Scopri di più sui modelli Granite con licenza open source

- Pagina della community di InstructLab

- Anteprima per sviluppatori RHEL AI

- LAB: Large-Scale Alignment for ChatBots

- Famiglia dei modelli Granite code

- Blog di IBM Research sul Synthetic Training dei LLM

- Come eseguire RHEL AI su IBM Cloud

Sugli autori

A 20+ year tech industry veteran, Jeremy is a Distinguished Engineer within the Red Hat OpenShift AI product group, building Red Hat's AI/ML and open source strategy. His role involves working with engineering and product leaders across the company to devise a strategy that will deliver a sustainable open source, enterprise software business around artificial intelligence and machine learning.

Altri risultati simili a questo

Ricerca per canale

Automazione

Novità sull'automazione IT di tecnologie, team e ambienti

Intelligenza artificiale

Aggiornamenti sulle piattaforme che consentono alle aziende di eseguire carichi di lavoro IA ovunque

Hybrid cloud open source

Scopri come affrontare il futuro in modo più agile grazie al cloud ibrido

Sicurezza

Le ultime novità sulle nostre soluzioni per ridurre i rischi nelle tecnologie e negli ambienti

Edge computing

Aggiornamenti sulle piattaforme che semplificano l'operatività edge

Infrastruttura

Le ultime novità sulla piattaforma Linux aziendale leader a livello mondiale

Applicazioni

Approfondimenti sulle nostre soluzioni alle sfide applicative più difficili

Virtualizzazione

Il futuro della virtualizzazione negli ambienti aziendali per i carichi di lavoro on premise o nel cloud