Red Hat hat heute eine Entwicklervorschau von Red Hat Enterprise Linux AI (RHEL AI) angekündigt. RHEL AI ist eine Plattform für Basismodelle für die Entwicklung, Prüfung und Ausführung hochwertiger generativer Open Source Granite-Modelle, die Unternehmensanwendungen unterstützen. RHEL AI basiert auf dem InstructLab Open Source-Projekt und vereint die Open Source lizenzierten Large Language Models der Granite-Familie von IBM Research mit den InstructLab-Modellanpassungstools, die auf der LAB-Methode (Large-scale Alignment for ChatBots) basieren, in einem optimierten, bootfähigen RHEL Image für eine einfachere Serverbereitstellung.

Das Hauptziel von RHEL AI und dem InstructLab-Projekt besteht darin, es Domain-Experten zu ermöglichen, ihr Wissen und ihre Fähigkeiten direkt in Large Language Models einzubringen. Dadurch können Domain-Experten KI-gestützte Anwendungen (wie Chatbots) effizienter entwickeln. RHEL AI umfasst:

- Zugang zu Innovationen der Community mit Open Source-Modellen und zu Open Source-Kompetenzen für die Weiterbildung

- Benutzerfreundliche Software-Tools und Workflows für Domain-Experten ohne Data Science-Erfahrung, um ihnen Training und Fine Tuning zu ermöglichen

- Paketieren von Software und Betriebssystemen mit optimierter KI-Hardware

- Unternehmenssupport und Entschädigung für geistiges Eigentum

Hintergrund

Large Language Models (LLMs) und darauf basierende Services (wie GPT und ChatGPT) sind allgemein bekannt und werden zunehmend von Unternehmen eingesetzt. Diese Modelle sind meistens Closed Source oder haben eine spezifische Lizenz. In letzter Zeit gibt es eine Reihe von Open Source-Modellen (wie Mistral, Llama, OpenELM). Die Offenheit einiger dieser Modelle ist jedoch begrenzt (zum Beispiel: Einschränkungen der kommerziellen Nutzung und/oder fehlende Offenheit bei Trainingsdaten und Transformer-Gewichtungen oder andere Faktoren im Zusammenhang mit der Reproduzierbarkeit). Der wichtigste Faktor sind vielleicht die fehlenden Möglichkeiten für Communities, zusammenzuarbeiten und zur Verbesserung der Modelle beitragen zu können.

Heutzutage sind LLMs groß und universell einsetzbar. Die Vision von Red Hat ist eine Welt aus zweckorientierten, kosten- und performance-optimierten Modellen, die von erstklassigen MLOps-Tools umgeben sind und bei denen Datenschutz, Datenhoheit und Vertraulichkeit an erster Stelle stehen.

Die Trainings-Pipeline zum Fine Tuning von LLMs erfordert Fachwissen in Data Science und kann teuer sein: sowohl hinsichtlich der Ressourcennutzung für das Training als auch aufgrund der Kosten für hochwertige Trainingsdaten.

Red Hat schlägt (zusammen mit IBM und der Open Source Community) vor, dies zu ändern. Wir schlagen vor, den vertrauten Open Source-Workflow und die damit verbundenen Konzepte wie die freizügige Lizenzierung (z. B. Apache2) für Modelle und Tools für die offene Zusammenarbeit einzuführen, die es einer Community von Nutzern ermöglichen, Beiträge zu LLMs zu erstellen und hinzuzufügen. Dadurch wird auch ein Partnernetzwerk in die Lage versetzt, Angebote und Werte zu liefern, die Erweiterungen und die Integration von geschützten Informationen durch Unternehmen ermöglichen.

Einführung in Red Hat Enterprise Linux AI

Red Hat Enterprise Linux AI besteht aus 4 verschiedenen Basiskomponenten:

1. Open Source Granite-Modelle

RHEL AI enthält hochleistungsfähige, Open Source-lizenzierte, gemeinsam entwickelte Granite-Sprach- und Codemodelle der InstructLab-Community, die von Red Hat vollständig unterstützt und entschädigt werden. Diese Granite-Modelle sind Apache 2-lizenziert und bieten transparenten Zugriff auf Datenquellen und Modellgewichtungen.

Nutzerinnen und Nutzer können ihre eigenen benutzerdefinierten LLMs erstellen, indem sie die Basismodelle mit den eigenen Fähigkeiten und Kenntnissen trainieren. Sie können wählen, ob sie das trainierte Modell und die hinzugefügten Fähigkeiten und Kenntnisse mit der Community teilen oder sie geheim halten möchten. Mehr dazu im nächsten Abschnitt.

Für eine Entwicklervorschau haben Nutzende Zugriff auf das Granite 7b (Basis-)Modell in englischer Sprache und das entsprechende Granite 7b LAB-Modell (weitere Informationen zu LAB finden Sie unten).

In Zukunft wird Red Hat Enterprise Linux AI auch zusätzliche Granite-Modelle enthalten, darunter auch Code der Granite-Modellfamilie. Seien Sie gespannt.

2. InstructLab Model Alignment

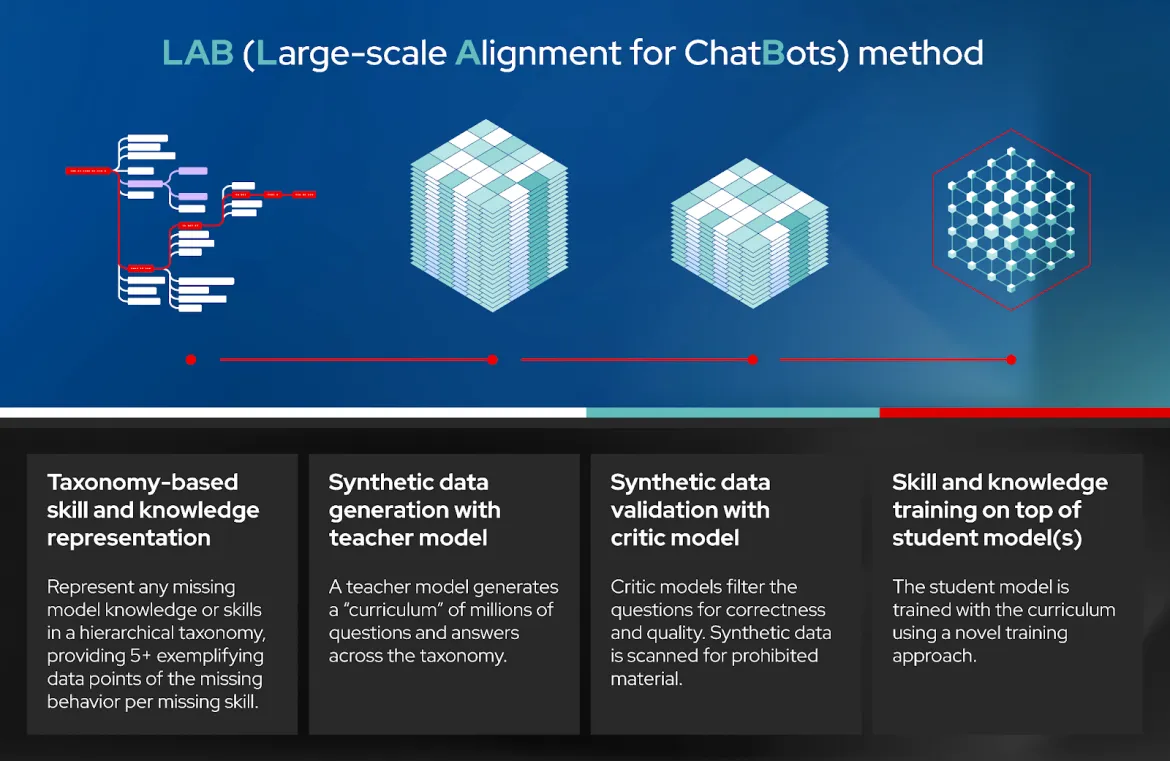

LAB: Large-Scale Alignment for ChatBots ist ein neuartiger Ansatz zur Befehlsausrichtung und Feinabstimmung (Fine Tuning) großer Sprachmodelle mit einem Source-basierten Ansatz, der hochwertige synthetische Daten generiert. Einfach gesagt, Nutzende können so ein LLM mit domainspezifischen Kenntnissen und Fähigkeiten anpassen. InstructLab generiert dann hochwertige synthetische Daten, die zum Trainieren des LLM verwendet werden. Mit einem Replay-Buffer wird das Vergessen verhindert. Weitere Einzelheiten finden Sie in Abschnitt 3.3 der wissenschaftlichen Arbeit.

Die LAB-Technik umfasst vier verschiedene Schritte (siehe Diagramm):

- Taxonomiebasierte Fähigkeiten und Wissensrepräsentation

- Generierung synthetischer Daten mit einem Lehrmodell

- Synthetische Datenvalidierung mit kritischem Modell

- Training von Kompetenzen und Wissen zusätzlich zu Schulungsmodellen

InstructLab ist der Name der Software, die die LAB-Technik implementiert. Es besteht aus einer Befehlszeilenschnittstelle, die mit einem lokalen Git-Repository für Kompetenzen und Wissen interagiert, einschließlich neuer, die der Nutzer hinzugefügt hat, um synthetische Daten zu generieren, das Training des LLM auszuführen, das trainierte Modell bereitzustellen und mit ihm zu kommunizieren.

Für die Entwicklervorschau verwendet InstructLab a) einen Git-Workflow zum Hinzufügen von Kompetenzen und Wissen, b) Mixtral als Lehrmodell zur Generierung synthetischer Daten, c) Deepspeed für das gestaffelte Training und d) vllm als Inferenzserver. Darüber hinaus bieten die Tools Gates, die eine Überprüfung und Feedback durch den Menschen ermöglichen. Wir arbeiten an weiteren Tools, um den Service in Zukunft einfacher und skalierbarer zu machen. Wie bei anderen Open Source-Projekten können Sie die Richtung mitbestimmen.

InstructLab ist auch der Name des Open Source Community-Projekts, das von Red Hat in Zusammenarbeit mit IBM Research ins Leben gerufen wurde. Das Community-Projekt bündelt Beiträge zu einer öffentlichen, von Apache 2.0 lizenzierten Taxonomie, die von Community-Mitgliedern gepflegt wird. Ein in LAB trainiertes Modell wird regelmäßig für die Community veröffentlicht und enthält die Beiträge der Community zur Taxonomie des Modells.

3. Optimiertes startfähiges Red Hat Enterprise Linux für Granite-Modelle und InstructLab

Die bereits erwähnten Granite-Modelle und InstructLab-Tools werden auf ein bootfähiges RHEL-Image mit einem optimierten Software-Stack für gängige Hardware-Beschleuniger von Anbietern wie AMD, Intel und NVIDIA heruntergeladen und bereitgestellt. Darüber hinaus werden diese RHEL AI-Images im Red Hat Certified Ecosystem gebootet und ausgeführt, einschließlich Public Clouds (IBM Cloud validiert zur Entwicklervorschau) und KI-optimierte Server von Dell, Cisco, HPE, Lenovo und SuperMicro. Unsere ersten Tests zeigen, dass 320 GB VRAM (4 x NVIDIA H100 GPUs) oder gleichwertig benötigt werden, um eine End-to-End-Ausführung von InstructLab in angemessener Zeit abzuschließen.

4. Unternehmensweiter Support, Lifecycle und Haftungsfreistellung

Bei allgemeiner Verfügbarkeit (General Availability, GA) werden Red Hat Enterprise Linux AI-Subskriptionen Unternehmens-Support, einen kompletten Produkt-Lifecycle beginnend mit dem Granite 7B-Modell und Software sowie eine Regelung zur Haftungsfreistellung von Red Hat umfassen.

Bitte beachten Sie, dass Red Hat Enterprise Linux AI bei der Entwickler-Vorschau von der Community unterstützt wird und keinen Red Hat Support und keine Haftungsfreistellung bietet.

Vom Experimentieren zur Produktion

Hier finden Sie ein dreistufiges Konzept, vom Einstieg, über erste Produktiv-Deployments bis hin zur Produktion im großen Umfang:

- Schritt 1: Nutzen Sie Ihr Laptop (oder Desktop) und beginnen mit Open Source InstructLab CLI. Auf diese Weise werden Sie mit InstructLab vertraut gemacht und können ein Low-Fidelity-Modell (qlora) erstellen, in das Ihre Kompetenzen und Wissen einfließen.

- Schritt 2: Sie können Red Hat Enterprise Linux AI auf einem Bare Metal-Server, einer virtuellen Maschine On-Premise oder in der Cloud booten. Sie können jetzt ein Korpus an Fähigkeiten und Kenntnissen hinzufügen und trainieren, um mit InstructLab ein hochpräzises, trainiertes und optimiertes Modell zu erhalten, mit dem Sie dann kommunizieren und es in Ihre Anwendungen integrieren können.

- Schritt 3: Für die Produktion in großem Umfang können Sie dieselbe Methodik wie oben (mit RHEL AI) verwenden, jedoch mit dem zusätzlichen Vorteil, dass Sie das Training auf mehrere Knoten verteilen können, um eine schnellere Fertigstellung zu ermöglichen und einen höheren Durchsatz mit OpenShift AI zu erzielen. Darüber hinaus erleichtert OpenShift AI die Integration Ihres trainierten Modells mit Ihren cloudnativen Anwendungen in der Produktion.

Fazit

Red Hat, IBM, die Open Source Community und unsere Partner begeben sich gemeinsam auf eine enorme Reise, um die Leistungsfähigkeit von Open Source-Innovationen und -Zusammenarbeit für Large Language Models und Open Source-Software für Unternehmen und Organisationen zu nutzen. Wir sind davon überzeugt, dass dies nur der Anfang ist und wir noch viele weitere Möglichkeiten vor uns haben.

Wir laden Sie ein, Teil dieser Reise zu werden. Werden Sie Mitglied unserer Open Source Community und tragen Sie dazu bei!

Sie können mit dem Training von quelloffenen Granite-Modellen beginnen, indem Sie die InstructLab CLI auf Ihren Laptop/Desktop herunterladen oder direkt zur RHEL AI Developer Preview wechseln. Wenn Sie Hilfe mit der Entwicklervorschau benötigen, wenden Sie sich an [email protected].

Referenzen

- Pressemitteilung

- Hauptseite für Red Hat Enterprise Linux AI

- Sehen Sie sich ein Video darüber an, wie InstructLab die Hindernisse bei der Einführung von KI senkt

- Mehr über die Open Source-lizenzierten Granite-Modelle erfahren

- Zur InstructLab Community

- RHEL AI Developer Preview

- LAB: Large-Scale Alignment for ChatBots

- Familie von Granite Code-Modellen

- IBM Research Blog on Hybrid Training for LLMs

- How to Run RHEL AI on IBM Cloud

Über die Autoren

A 20+ year tech industry veteran, Jeremy is a Distinguished Engineer within the Red Hat OpenShift AI product group, building Red Hat's AI/ML and open source strategy. His role involves working with engineering and product leaders across the company to devise a strategy that will deliver a sustainable open source, enterprise software business around artificial intelligence and machine learning.

Mehr davon

Nach Thema durchsuchen

Automatisierung

Das Neueste zum Thema IT-Automatisierung für Technologien, Teams und Umgebungen

Künstliche Intelligenz

Erfahren Sie das Neueste von den Plattformen, die es Kunden ermöglichen, KI-Workloads beliebig auszuführen

Open Hybrid Cloud

Erfahren Sie, wie wir eine flexiblere Zukunft mit Hybrid Clouds schaffen.

Sicherheit

Erfahren Sie, wie wir Risiken in verschiedenen Umgebungen und Technologien reduzieren

Edge Computing

Erfahren Sie das Neueste von den Plattformen, die die Operations am Edge vereinfachen

Infrastruktur

Erfahren Sie das Neueste von der weltweit führenden Linux-Plattform für Unternehmen

Anwendungen

Entdecken Sie unsere Lösungen für komplexe Herausforderungen bei Anwendungen

Virtualisierung

Erfahren Sie das Neueste über die Virtualisierung von Workloads in Cloud- oder On-Premise-Umgebungen