Aujourd'hui, Red Hat a annoncé la version préliminaire pour les développeurs de Red Hat Enterprise Linux AI (RHEL AI), une plateforme de modèles de base qui permet de développer, de tester et d'exécuter en toute simplicité les meilleurs modèles d'IA générative Granite Open Source pour alimenter les applications d'entreprise L'IA RHEL est basée sur le projet Open Source InstructLab et combine les outils d'alignement de modèles sous licence Open Source de grands modèles de langage issus des outils d'alignement de modèles IBM Research et InstructLab, sur la base du projet LAB (Large-scale Alignment for chatBoth ), dans une image RHEL optimisée et amorçable pour simplifier les déploiements de serveurs.

Le principal objectif de RHEL AI et du projet InstructLab est de permettre aux spécialistes de domaines de contribuer directement aux grands modèles de langage en utilisant des connaissances et des compétences . Celui-ci permet aux experts de domaine de créer plus efficacement des applications basées sur l'IA (telles que des chatbots). RHEL AI inclut tout ce dont vous avez besoin :

- tirer parti des innovations de la communauté via des modèles Open Source et les compétences et connaissances Open Source pour la formation ;

- fournissant un ensemble d'outils logiciels et un workflow faciles à utiliser qui ciblent les experts du domaine sans expérience en science des données et leur permettent de se former et d'effectuer des ajustements ;

- mise en paquet des logiciels et des systèmes d'exploitation avec matériel d'IA optimisé

- assistance aux entreprises et indemnisation en matière de propriété intellectuelle

Contexte

Les grands modèles de langage et les services qui reposent sur ces modèles (tels que GPT et chatGPT) sont bien connus et de plus en plus adoptés par les entreprises. Ces modèles sont le plus souvent des modèles propriétaires ou sous licence personnalisée. Plus récemment, un certain nombre de modèles ouverts ont commencé à apparaître (tels que Mistral, Llama et OpenELM). L'ouverture de certains de ces modèles est cependant limitée. L'utilisation commerciale est limitée et/ou le manque d'ouverture s'applique à l'entraînement des données, au poids des transformateurs et à d'autres facteurs liés à la reproductibilité. Le facteur le plus important est peut-être l'absence de moyens pour les communautés de collaborer et contribuer aux modèles en vue de les améliorer.

Aujourd'hui, les grands modèles de langage sont volumineux et polyvalents. Red Hat entrevoit une multitude de modèles conçus à cet effet, optimisés pour les coûts et les performances, associés à des outils MLOps de pointe qui placent la confidentialité, la souveraineté et la confidentialité des données au premier plan.

Le pipeline d'entraînement pour ajuster les grands modèles de langage requiert une expertise en science des données et peut être coûteux, à la fois en termes d'utilisation des ressources pour l'entraînement et à cause du coût des données d'entraînement de haute qualité.

Red Hat (ainsi qu'IBM et la communauté Open Source) propose de changer cela. Nous proposons d'introduire le workflow de contributeurs Open Source familier et les concepts associés, tels que les licences permissives (par exemple, Apache2), dans des modèles et des outils de collaboration ouverte qui permettent à une communauté d'utilisateurs de créer et d'ajouter des contributions à des grands modèles de langage. Ainsi, un écosystème de partenaires pourra proposer des offres et de la valeur pour faciliter l'extension et l'intégration d'informations protégées par les entreprises.

Présentation de Red Hat Enterprise Linux AI

Red Hat Enterprise Linux AI se compose de quatre composants fondamentaux distincts :

1. Modèles Open Granite

RHEL AI inclut des modèles de langage et de code Open Source sous licence développés en collaboration par la communauté InstructLab, entièrement pris en charge et indemnisés par Red Hat. Ces modèles de granite sont sous licence Apache 2 et offrent un accès transparent aux sources de données et aux pondérations des modèles.

Les utilisateurs peuvent créer leur propre grand modèle de langage personnalisé en entraînant les modèles de base avec leurs propres compétences et connaissances. Ils peuvent choisir de partager le modèle entraîné ainsi que les compétences et connaissances supplémentaires avec la communauté, ou de les garder privées. En savoir plus dans la section suivante.

Pour la version préliminaire pour les développeurs, les utilisateurs ont accès au modèle Granite 7b en anglais (base) et au modèle Granite 7b LAB correspondant (voir ci-dessous pour plus d'informations sur LAB).

À l'avenir, la solution Red Hat Enterprise Linux AI inclura également d'autres modèles Granite, notamment la famille de modèles de code Granite. Surveillez bien.

2. Alignement de modèles InstructLab

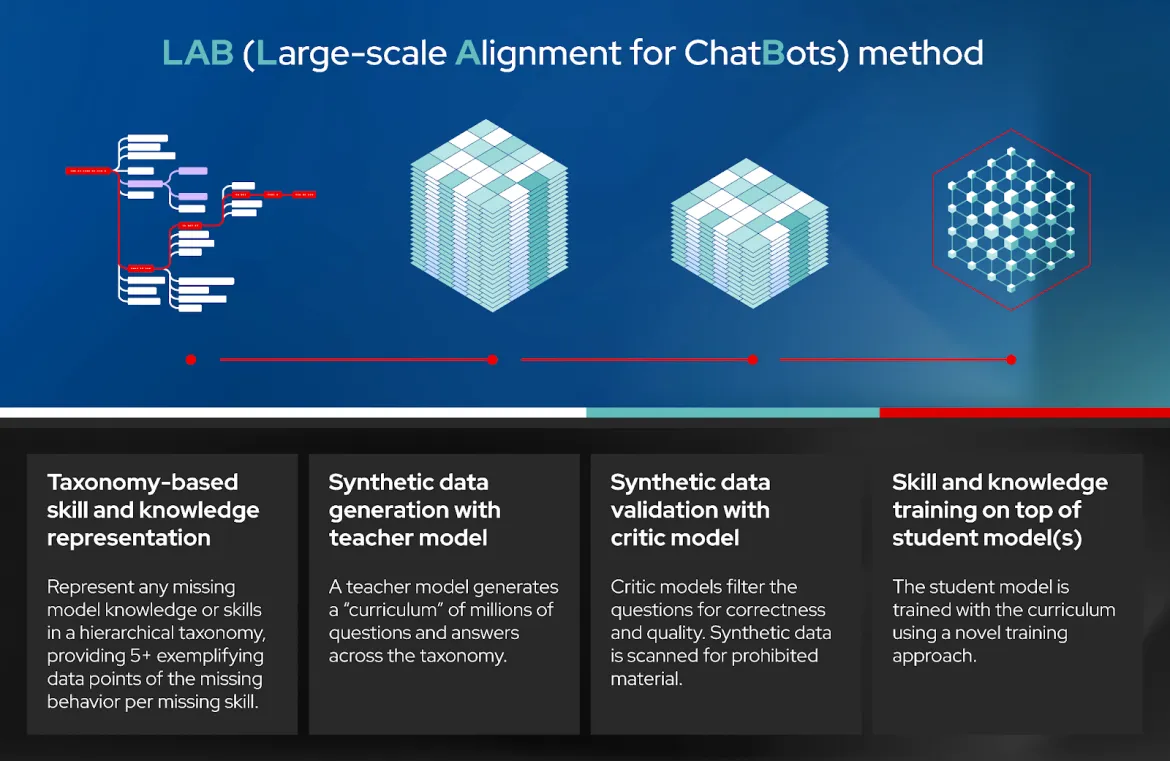

LAB: Large-Scale Alignment for ChatBots est une approche novatrice de l'alignement d'instructions et de l'ajustement de grands modèles de langage qui reposent sur une approche classifiée qui tire parti de la génération de données synthétiques de haute qualité. Plus simplement, il permet aux utilisateurs de personnaliser un grand modèle de langage à l'aide de connaissances et de compétences spécifiques à un domaine. InstructLab génère ensuite des données synthétiques de haute qualité qui sont utilisées pour entraîner le grand modèle de langage. Un tampon de relecture est utilisé pour éviter tout oubli. Pour plus de détails, consultez la section 3.3 de l'article académique.

La technique LAB se compose de quatre étapes distinctes (voir le schéma) :

- Représentation des connaissances et compétences en fonction de la classification

- Génération de données synthétiques (SDG) avec un modèle d'instructeur

- Validation de données synthétiques avec un modèle critique.

- Formation aux compétences et connaissances sur le ou les modèles du ou des participants

InstructLab est le nom du logiciel qui implémente la technique LAB. Il s'agit d'une interface en ligne de commande qui interagit avec un référentiel Git local de compétences et de connaissances, y compris avec celles que l'utilisateur a ajoutées, pour générer des données synthétiques, exécuter l'entraînement du grand modèle de langage, afin de diffuser le modèle entraîné et discuter avec celui-ci.

Dans la version préliminaire pour les développeurs, InstructLab utilise a) un workflow Git pour l'ajout de compétences et de connaissances, b) Mixtral comme modèle d'enseignement pour la génération de données synthétiques, c) deepspeed pour l'entraînement progressif et d) vllm comme serveur d'inférence. En outre, ces outils offrent des passerelles qui permettent l'examen et les commentaires humains. Nous travaillons à l'ajout d'outils pour le rendre plus simple et plus évolutif. Et comme pour n'importe quel projet Open Source, vous pouvez l'aider à trouver sa voie !

InstructLab est également le nom du projet de la communauté Open Source lancé par Red Hat en collaboration avec l'équipe de recherche IBM. Le projet communautaire rassemble les contributions dans une classification publique sous licence Apache 2.0 qui est gérée par les membres de la communauté. Un modèle entraîné en LAB est régulièrement publié dans la communauté. Il inclut les contributions de la méthode communautaire au modèle.

3. Red Hat Enterprise Linux amorçable optimisé pour les modèles Granite et InstructLab

Les modèles Granite et les outils InstructLab mentionnés ci-dessus sont téléchargés et déployés sur une image RHEL amorçable [ avec une pile logicielle optimisée pour les accélérateurs matériels courants de fournisseurs tels que AMD, Intel et NVIDIA. , En outre, ces images RHEL AI démarreront et s'exécuteront dans l'écosystème certifié Red Hat, y compris dans les clouds publics (IBM Cloud validé à la version préliminaire pour les développeurs) et les serveurs optimisés pour l'IA de Dell, Cisco, HPE, Lenovo et SuperMicro. Nos tests initiaux indiquent qu'avec 320 Go de VRAM (4 GPU NVIDIA H100) ou équivalent, il est nécessaire d'effectuer une exécution InstructLab de bout en bout dans un délai raisonnable.

4. Assistance aux entreprises, cycle de vie et indemnisation

À partir de la souscription Red Hat Enterprise Linux AI, les souscriptions Red Hat Enterprise Linux AI comprennent un service d'assistance aux entreprises, un cycle de vie complet à partir du modèle et des logiciels Granite 7B, ainsi qu'une indemnisation des adresses IP par Red Hat.

Veuillez noter que la version préliminaire pour les développeurs de Red Hat Enterprise Linux AI est prise en charge par la communauté. Nous n'avons donc pas besoin de recourir à l'assistance de Red Hat ni d'indemnisation.

De l'expérimentation à la production

Voici une approche en trois étapes pour se lancer dans les premiers déploiements en production et en production à grande échelle :

- [Étape] 1 : Vous pouvez commencer à utiliser votre ordinateur portable à l'aide de l'interface en ligne de commande Open Source InstructLab. Cela vous permet de vous familiariser avec InstructLab et de générer un modèle faible fidélité (qlora) avec vos compétences et connaissances supplémentaires.

- [Étape] 2 : Vous pouvez démarrer Red Hat Enterprise Linux AI sur un serveur bare metal, une machine virtuelle sur site ou dans le cloud. Vous pouvez désormais ajouter un ensemble de compétences et de connaissances et vous entraîner pour obtenir un modèle entraîné et réglé haute fidélité à l'aide d'InstructLab, que vous pourrez ensuite intégrer dans vos applications via la messagerie instantanée.

- [Étape] 3 : Pour la production à grande échelle, vous pouvez utiliser la même méthodologie que ci-dessus (avec RHEL AI), mais avec l'avantage supplémentaire de pouvoir répartir l'entraînement sur plusieurs nœuds pour accélérer la réalisation et augmenter le débit avec OpenShift AI : En outre, OpenShift AI facilite l'intégration de votre modèle entraîné avec vos applications cloud-native en production.

Conclusion

Red Hat, avec IBM, la communauté Open Source et nos partenaires, s'est lancé dans un parcours incroyable qui permettra de mettre la puissance de l'innovation et de la collaboration Open Source au service des grands modèles de langage et des logiciels d'entreprise Open Source. Nous sommes convaincus que ce n'est qu'un début et que de nombreuses opportunités s'offrent à nous.

Nous vous invitons à faire partie de ce parcours. N'hésitez pas à rejoindre notre communauté Open Source et commencez à contribuer !

Vous pouvez vous lancer dans l'entraînement des modèles Granite Open Source en téléchargeant l'interface en ligne de commande InstructLab sur votre ordinateur portable/de bureau ou en accédant directement à la version préliminaire pour les développeurs de RHEL AI. Si vous avez besoin d'aide avec la version préliminaire pour les développeurs, veuillez contacter [email protected].

Références

- Communiqué de presse

- Page principale de Red Hat Enterprise Linux AI

- Regardez une vidéo sur la manière dont InstructLab réduit les obstacles à l'adoption de l'IA

- En savoir plus sur les modèles Granite sous licence Open Source

- Page de la communauté InstructLab

- Aperçu pour les développeurs RHEL AI

- LAB: Large-Scale Alignment for ChatBots

- Définition de la famille de modèles de code en granite

- Blog de recherche IBM sur le fonctionnement des grands modèles de langage

- Comment exécuter RHEL AI sur le cloud

À propos des auteurs

A 20+ year tech industry veteran, Jeremy is a Distinguished Engineer within the Red Hat OpenShift AI product group, building Red Hat's AI/ML and open source strategy. His role involves working with engineering and product leaders across the company to devise a strategy that will deliver a sustainable open source, enterprise software business around artificial intelligence and machine learning.

Contenu similaire

Parcourir par canal

Automatisation

Les dernières nouveautés en matière d'automatisation informatique pour les technologies, les équipes et les environnements

Intelligence artificielle

Actualité sur les plateformes qui permettent aux clients d'exécuter des charges de travail d'IA sur tout type d'environnement

Cloud hybride ouvert

Découvrez comment créer un avenir flexible grâce au cloud hybride

Sécurité

Les dernières actualités sur la façon dont nous réduisons les risques dans tous les environnements et technologies

Edge computing

Actualité sur les plateformes qui simplifient les opérations en périphérie

Infrastructure

Les dernières nouveautés sur la plateforme Linux d'entreprise leader au monde

Applications

À l’intérieur de nos solutions aux défis d’application les plus difficiles

Virtualisation

L'avenir de la virtualisation d'entreprise pour vos charges de travail sur site ou sur le cloud