今天,红帽发布了 红帽企业 Linux AI(RHEL AI)的开发人员预览版,这是一个基础模型平台,可用于无缝开发、测试和运行同类最佳的开源 Granite 生成式 AI 模型,为企业应用。RHEL AI 基于 InstructLab 开源项目 ,并结合了来自 IBM 研究院的开源许可的大型语言模型和 InstructLab 模型对齐工具,这些工具基于 LAB(Large-scale Alignment for ChatBots ) 方法,在优化的可引导 RHEL 镜像中简化服务器部署。

RHEL AI 和 InstructLab 项目的主要目标是让领域专家能够利用 知识 和 技能直接为大型语言模型做出贡献。这使得领域专家能够更高效地构建融合了 AI 的应用(如聊天机器人)。RHEL AI 包含您需要的一切:

- 通过开源模型和开源技能和知识进行培训,充分利用社区创新

- 提供一套用户友好的软件工具和工作流,面向没有数据科学经验的领域专家,并允许他们进行培训和微调

- 将软件和操作系统与优化的 AI 硬件支持打包在一起

- 企业级支持和知识产权保障

背景

大型语言模型(LLM)和基于它们的服务(如 GPT 和 ChatGPT)广为人知,并越来越多地被企业组织采用。这些模型通常是闭源的,或者具有自定义许可证。最近,一些开放模型开始出现(如 Mistral、Llama 和 OpenELM)。但是,其中一些模型的开放性是有限的(例如:商业用途的限制和/或在训练数据和 Transformer 权重以及与可再现性相关的其他因素方面缺乏开放性)。最重要的因素可能是缺乏社区协作并为改进模型做出贡献的方式。

如今的 LLM 规模庞大,用途广泛。红帽设想了一个专门构建、成本和性能优化模型的世界,使用世界一流的 MLOps 工具,将数据隐私、主权和机密性放在首位。

用于微调 LLM 的训练管道需要数据科学专业知识,并且可能代价高昂:一方面是在训练资源使用方面,另一方面是因为高质量训练数据的成本。

红帽(与 IBM 和开源社区一起)提议改变这种状况。我们建议将熟悉的开源贡献者工作流和相关概念(如许可许可(如 Apache2))引入模型和开放协作工具,使社区用户能够创建和添加对 LLM 的贡献。这也将赋能合作伙伴生态系统,以提供产品和价值,从而实现企业扩展和整合受保护的信息。

红帽企业 Linux AI 介绍

红帽企业 Linux AI 由四个不同的基础组件组成:

1.开放式 Granite 模型

RHEL AI 包含来自 InstructLab 社区协作开发的高性能 Granite 语言和代码模型,并由红帽提供全面支持和保障。这些 Granite 模型 已获得 Apache 2 许可,可透明访问数据源和模型权重。

用户可以通过使用自己的技能和知识训练基础模型来创建自己的自定义 LLM。可以选择与社区共享经过训练的模型以及增加的技能和知识,也可以选择保密。下一节将详细介绍这方面的内容。

对于开发人员预览,用户可以访问 Granite 7b 英语(基础)模型,以及相应的 Granite 7b LAB 模型 (有关 LAB 的更多信息,请参见下文)。

未来,红帽企业 Linux AI 还将包含其他的 Granite 模型,包括 Granite code 模型系列。请继续关注我们。

2.InstructLab 模型对齐

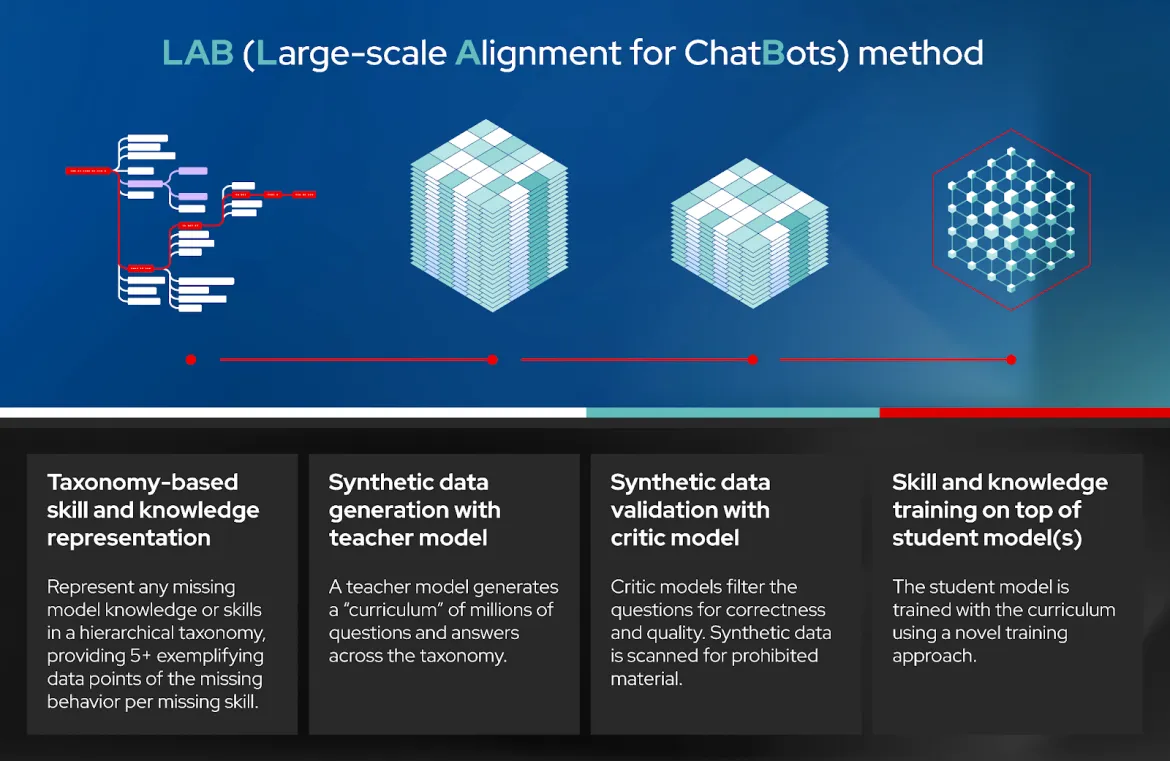

LAB:聊天机器人大规模对齐 是一种新颖的指令对齐方法,通过利用高质量合成数据生成的分类驱动方法对大型语言模型进行微调。简单来说,它允许用户使用特定领域的知识和技能来自定义 LLM。然后,InstructLab 生成用于训练 LLM 的高质量合成数据。重放缓冲区用于防止遗忘。有关更多详细信息,请参阅学术论文的 第 3.3 节。

LAB 技术包含四个不同的步骤(见示意图):

- 基于分类的技能和知识表示

- 使用教师模型生成合成数据(SDG)

- 使用 Critic 模型进行综合数据验证。

- 基于学员模型的技能和知识培训

InstructLab 是实施 LAB 技术的软件的名称。它包含一个命令行界面,与技能和知识(包括用户添加的新技能)的本地 Git 存储库交互,以生成合成数据,运行 LLM 训练,为经过训练的模型提供服务并与之聊天。

对于开发人员预览,InstructLab 使用 a) git 工作流来添加技能和知识,b) 作为教师模型来生成合成数据,c) deepspeed 用于分阶段培训,以及 d) vllm 作为推理服务器。除此之外,工具还提供允许人工审查和反馈的门控。我们正在努力添加更多工具,以使其在未来变得更加容易和可扩展。与任何开源项目一样,您可以帮助引导项目的发展方向!

InstructLab 也是开源社区项目的名称,该项目由红帽与 IBM 研究院合作启动。社区项目将贡献汇集到一个由社区成员维护的 Apache 2.0 许可的公共分类中。LAB 训练的模型会定期发布到社区,其中包括社区对模型分类的贡献。

3.针对 Granite 模型和 InstructLab 优化的可启动红帽企业 Linux

上述的 Granite 模型和 InstructLab 工具已下载并部署到可启动的 RHEL 镜像中,该镜像具有针对 AMD、英特尔和 NVIDIA 等供应商的热门硬件加速器优化的软件堆栈。此外,这些 RHEL AI 镜像将在红帽认证生态系统中启动和运行,包括公共云(IBM Cloud 已通过开发人员预览验证)以及来自戴尔、思科、HPE、联想和 SuperMicro 的 AI 优化服务器。我们的初步测试表明,在合理的时间内完成端到端 InstructLab 运行需要 320GB VRAM(4 个 NVIDIA H100 GPU)或同等配置。

4.企业级支持、生命周期和赔偿

在正式发布(GA)时,红帽企业 Linux AI 订阅将包括企业支持、从Granite 7B 模型和软件开始的完整产品生命周期,以及红帽的知识产权保障。

请注意,对于开发人员预览版,红帽企业 Linux AI 是由社区支持的,没有红帽支持和保障。

从实验到生产

以下是一个分三步走的分阶段方法,教您如何开始将首次生产部署大规模投入生产:

- 第 1 步: 您可以使用笔记本电脑(或台式机)开始使用开源的 InstructLab CLI。这将帮助您熟悉 InstructLab,并根据您的技能和知识生成低保真度模型 (qlora)。

- 第 2 步: 您可以将红帽企业 Linux AI 引导到裸机服务器、本地或云端的虚拟机。现在,您可以使用 InstructLab 添加技能和知识的语料库并进行训练,以获得经过训练和调优的高保真模型,然后与模型对话并与应用集成。

- 第 3 步: 对于大规模生产,您可以使用与上述相同的方法(使用 RHEL AI),但有一个额外的好处,即能够将训练分散到多个节点上,从而更快地完成训练,并通过 OpenShift 提高吞吐量AI。此外,借助 OpenShiftAI,您可以更轻松地将经过训练的模型与生产中的云原生应用集成。

结论

红帽携手 IBM、开源社区和我们的合作伙伴踏上了一段不可思议的旅程,将开源创新与协作的力量带入大型语言模型,并为公司和组织带来开放式企业软件。我们相信,这仅仅是一个开始,未来还有很多机会。

我们诚邀您的加入。请加入我们的开源社区并开始做出贡献!

您可以在笔记本电脑/台式机上下载 InstructLab cli ,或直接跳转到 RHEL AI 开发人员预览版,开始训练开源的Granite 模型。如果您需要开发人员预览版的帮助,请联系 [email protected]。

参考资料

关于作者

A 20+ year tech industry veteran, Jeremy is a Distinguished Engineer within the Red Hat OpenShift AI product group, building Red Hat's AI/ML and open source strategy. His role involves working with engineering and product leaders across the company to devise a strategy that will deliver a sustainable open source, enterprise software business around artificial intelligence and machine learning.